资讯专栏INFORMATION COLUMN

摘要:为了探索多种训练方案,何恺明等人尝试了在不同的迭代周期降低学习率。实验中,何恺明等人还用预训练了同样的模型,再进行微调,成绩没有任何提升。何恺明在论文中用来形容这个结果。

何恺明,RBG,Piotr Dollár。

三位从Mask R-CNN就开始合作的大神搭档,刚刚再次联手,一文“终结”了ImageNet预训练时代。

他们所针对的是当前计算机视觉研究中的一种常规操作:管它什么任务,拿来ImageNet预训练模型,迁移学习一下。

但是,预训练真的是必须的吗?

这篇重新思考ImageNet预训练(Rethinking ImageNet Pre-training)就给出了他们的答案。

FAIR(Facebook AI Research)的三位研究员从随机初始状态开始训练神经网络,然后用COCO数据集目标检测和实例分割任务进行了测试。结果,丝毫不逊于经过ImageNet预训练的对手。

甚至能在没有预训练、不借助外部数据的情况下,和COCO 2017冠军平起平坐。

结果

训练效果有图有真相。

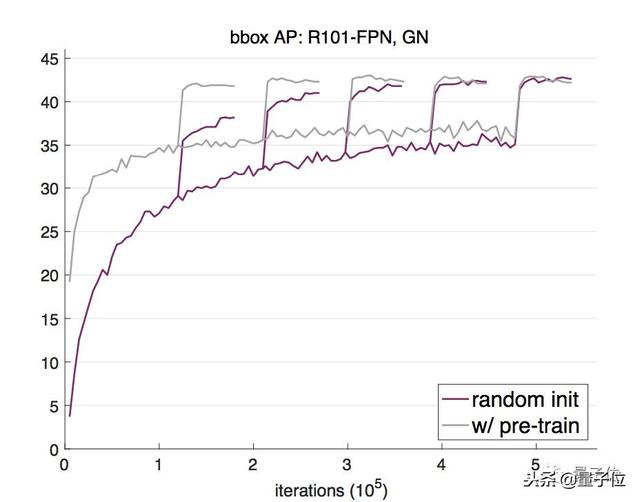

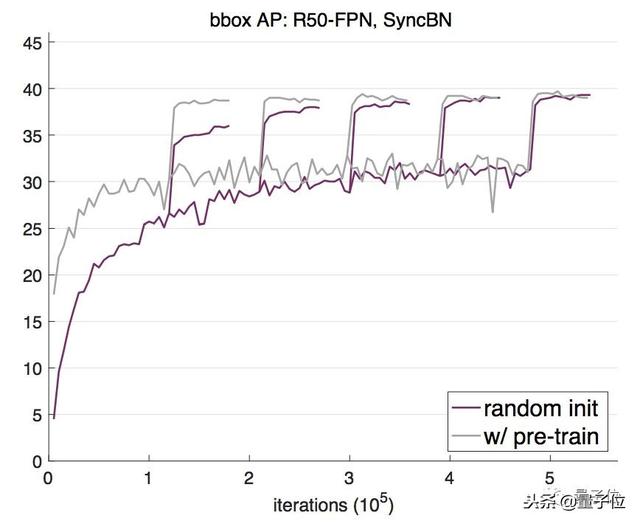

他们用2017版的COCO训练集训练了一个Mask R-CNN模型,基干网络是用了群组归一化(GroupNorm)的ResNet-50 FPN。

随后,用相应的验证集评估随机权重初始化(紫色线)和用ImageNet预训练后再微调(灰色线)两种方法的边界框平均检测率(AP)。

可以看出,随机权重初始化法开始不及预训练方法效果好,但随着迭代次数的增加,逐渐达到了和预训练法相当的结果。

为了探索多种训练方案,何恺明等人尝试了在不同的迭代周期降低学习率。

结果显示,随机初始化方法训练出来的模型需要更多迭代才能收敛,但最终收敛效果不比预训练再微调的模型差。

主干网络换成ResNet-101 FPN,这种从零开始训练的方法依然呈现出一样的趋势:从零开始先是AP不及预训练法,多次迭代后两者终趋于不分上下。

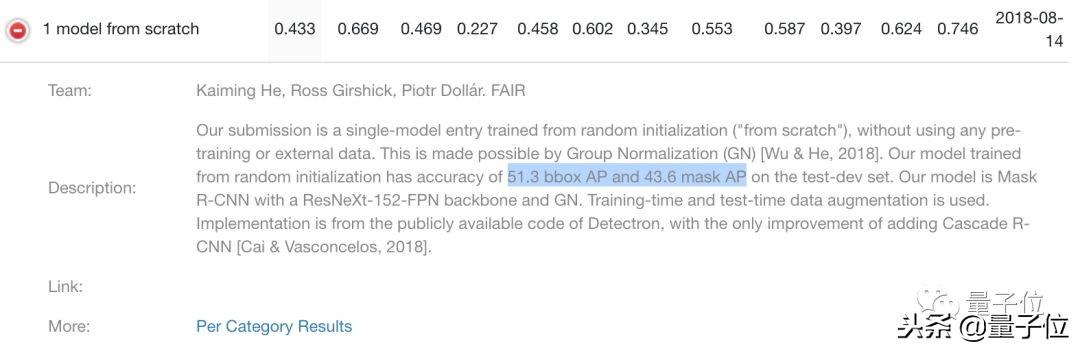

效果究竟能有多好?答案前面也说过了,和COCO 2017冠军选手平起平坐。

从零开始模型的效果,由COCO目标检测任务来证明。在2017版验证集上,模型的bbox(边界框)和mask(实例分割)AP分别为50.9和43.2;

他们还在2018年竞赛中提交了这个模型,bbox和mask AP分别为51.3和43.6。

这个成绩,在没有经过ImageNet预训练的单模型中是较好的。

这是一个非常庞大的模型,使用了ResNeXt-152 8×32d基干,GN归一化方法。从这个成绩我们也能看出,这个大模型没有明显过拟合,非常健壮(robust)。

实验中,何恺明等人还用ImageNet预训练了同样的模型,再进行微调,成绩没有任何提升。

这种健壮性还有其他体现。

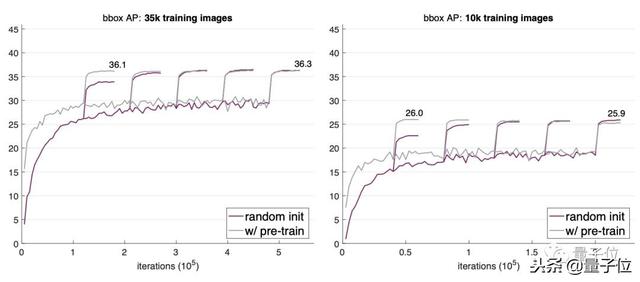

比如说,用更少的数据进行训练,效果还是能和预训练再微调方法持平。何恺明在论文中用“Even more surprising”来形容这个结果。

当他们把训练图像数量缩减到整个COCO数据集的1/3(35000张图)、甚至1/10(10000张图)时,经过多次迭代,随机初始化看起来还略优于预训练法的效果。

不过,10000张图已经是极限,继续降低数据量就不行了。当他们把训练数据缩减到1000张图片,出现了明显的过拟合。

怎样训练?

想抛弃ImageNet预训练,用不着大动干戈提出个新架构。不过,两点小改动在所难免。

第一点是模型的归一化方法,第二点是训练长度。

我们先说模型归一化(Normalization)。

因为目标检测任务的输入数据通常分辨率比较高,导致批次大小不能设置得太大,所以,批归一化(Batch Normalization,BN)不太适合从零开始训练目标检测模型。

于是,何恺明等人从最近的研究中找了两种可行的方法:群组归一化(Group Normalization,GN)和同步批归一化(Synchronized Batch Normalization,SyncBN)。

GN是吴育昕和何恺明合作提出的,发表在ECCV 2018上,还获得了较佳论文荣誉提名。这种归一化方法把通道分成组,然后计算每一组之内的均值和方差。它的计算独立于批次维度,准确率也不受批次大小影响。

SyncBN则来自旷视的MegDet,和香港中文大学Shu Liu等人的CVPR 2018论文Path Aggregation Network for Instance Segmentation。这是一种跨GPU计算批次统计数据来实现BN的方法,在使用多个GPU时增大了有效批次大小。

归一化方法选定了,还要注意收敛问题,简单说是要多训练几个周期。

道理很简单:你总不能指望一个模型从随机初始化状态开始训练,还收敛得跟预训练模型一样快吧。

所以,要有耐心,多训练一会儿。

上图就是这两种方法的对比。假设微调的模型已经预训练了100个周期,那么,从零开始训练的模型要迭代的周期数是微调模型的3倍,见到的像素数量才能差不多,实例级、图片级的样本数量依然差距很大。

也就是说,要想从随机初始化状态开始训练,要有大量样本。

到底要不要用ImageNet预训练?

这篇论文还贴心地放出了从实验中总结的几条结论:

不改变架构,针对特定任务从零开始训练是可行的。

从零开始训练需要更多迭代周期,才能充分收敛。

在很多情况下,甚至包括只用10000张COCO图片,从零开始训练的效果不逊于用ImageNet预训练模型微调。

用ImageNet预训练能加速在目标任务上的收敛。

ImageNet预训练未必能减轻过拟合,除非数据量极小。

如果目标任务对定位比识别更敏感,ImageNet预训练的作用较小。

所以,关于ImageNet预训练的几个关键问题也就有了答案:

它是必需的吗?并不是,只要目标数据集和计算力足够,直接训练就行。这也说明,要提升模型在目标任务上的表现,收集目标数据和标注更有用,不要增加预训练数据了。

它有帮助吗?当然有,它能在目标任务上数据不足的时候带来大幅提升,还能规避一些目标数据的优化问题,还缩短了研究周期。

我们还需要大数据吗?需要,但一般性大规模分类级的预训练数据集就不用了,在目标领域收集数据更有效。

我们还要追求通用表示吗?依然需要,这还是个值得赞赏的目标。

想更深入地理解这个问题,请读论文:

论文:

Rethinking ImageNet Pre-training

Kaiming He,Ross Girshick,PiotrDollár

https://arxiv.org/abs/1811.08883

声明:文章收集于网络,如有侵权,请联系小编及时处理,谢谢!

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4841.html

摘要:何恺明和两位大神最近提出非局部操作为解决视频处理中时空域的长距离依赖打开了新的方向。何恺明等人提出新的非局部通用网络结构,超越。残差连接是何恺明在他的年较佳论文中提出的。 Facebook何恺明和RGB两位大神最近提出非局部操作non-local operations为解决视频处理中时空域的长距离依赖打开了新的方向。文章采用图像去噪中常用的非局部平均的思想处理局部特征与全图特征点的关系。这种...

摘要:大神何恺明受到了质疑。今天,上一位用户对何恺明的提出质疑,他认为何恺明年的原始残差网络的结果没有被复现,甚至何恺明本人也没有。我认为,的可复现性经受住了时间的考验。 大神何恺明受到了质疑。今天,Reddit 上一位用户对何恺明的ResNet提出质疑,他认为:何恺明 2015 年的原始残差网络的结果没有被复现,甚至何恺明本人也没有。网友称,他没有发现任何一篇论文复现了原始 ResNet 网络的...

摘要:从标题上可以看出,这是一篇在实例分割问题中研究扩展分割物体类别数量的论文。试验结果表明,这个扩展可以改进基准和权重传递方法。 今年10月,何恺明的论文Mask R-CNN摘下ICCV 2017的较佳论文奖(Best Paper Award),如今,何恺明团队在Mask R-CNN的基础上更近一步,推出了(以下称Mask^X R-CNN)。这篇论文的第一作者是伯克利大学的在读博士生胡戎航(清华...

摘要:但是其仍然存在一些问题,而新提出的解决了式归一化对依赖的影响。上面三节分别介绍了的问题,以及的工作方式,本节将介绍的原因。作者基于此,提出了组归一化的方式,且效果表明,显著优于等。 前言Face book AI research(FAIR)吴育昕-何恺明联合推出重磅新作Group Normalization(GN),提出使用Group Normalization 替代深度学习里程碑式的工作B...

摘要:现在,官方版开源代码终于来了。同时发布的,是这项研究背后的一个基础平台。是的物体检测平台,今天宣布开源,它基于,用写成,这次开放的代码中就包含了的实现。说,将平台开源出来,是想要加速世界各地实验室的研究,推动物体检测的进展。 等代码吧。从Mask R-CNN论文亮相至今的10个月里,关于它的讨论几乎都会以这句话收尾。现在,官方版开源代码终于来了。同时发布的,是这项研究背后的一个基础平台:De...

阅读 1107·2021-11-18 10:02

阅读 1361·2021-09-23 11:22

阅读 2675·2021-08-21 14:08

阅读 1688·2019-08-30 15:55

阅读 1777·2019-08-30 13:45

阅读 3296·2019-08-29 16:52

阅读 3144·2019-08-29 12:18

阅读 1700·2019-08-26 13:36