资讯专栏INFORMATION COLUMN

摘要:近年来,深度学习在计算机感知自然语言处理和控制方面取得了重大进展。位列新泽西州的发明家名人堂,并获得年神经网络先锋奖年杰出研究奖年终身成就奖和来自墨西哥的名誉博士学位。

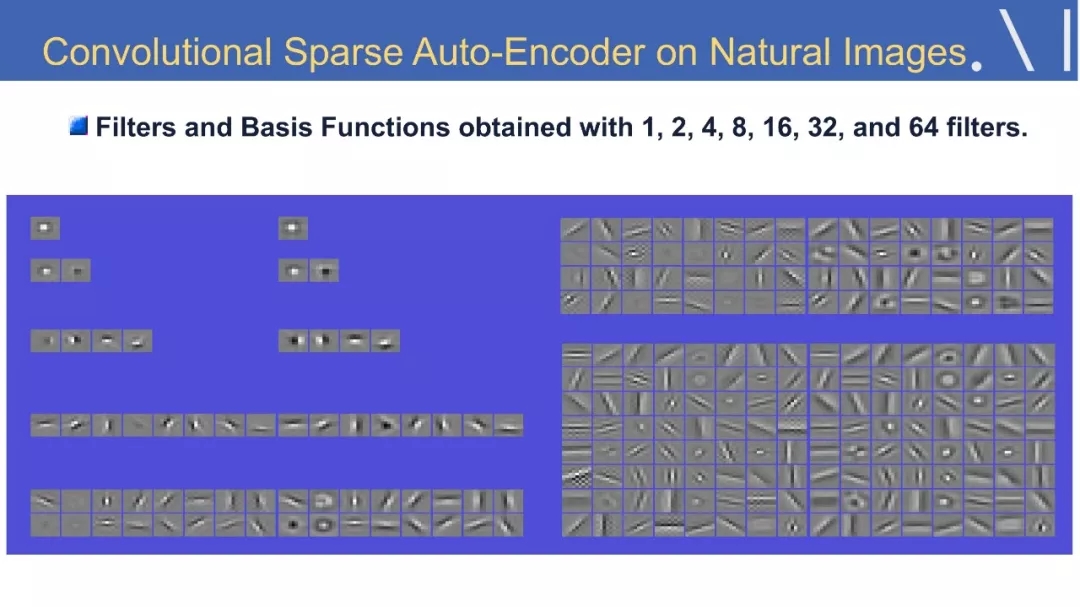

Yann Lecun是卷积网络模型的发明者,该模型被广泛地应用于模式识别应用中,因此他也被称为卷积网络之父,是公认的世界人工智能三巨头之一。 2018年11月08日,他来到加州大学圣巴巴拉分校,为在场师生作了一场关于自监督学习的前沿报告,近日他在twitter上公开了报告的全程录像以及Slides全文,现为大家编译如下。

介绍:

11月08日,应加州大学圣巴巴拉分校,统计与应用概率学系(Department of Statistics and Applied Probability)邀请,Facebook副总裁兼人工智能科学家、纽约大学数据科学中心创始主任Yann Lecun为在场师生做了一场自监督学习的前沿报告。

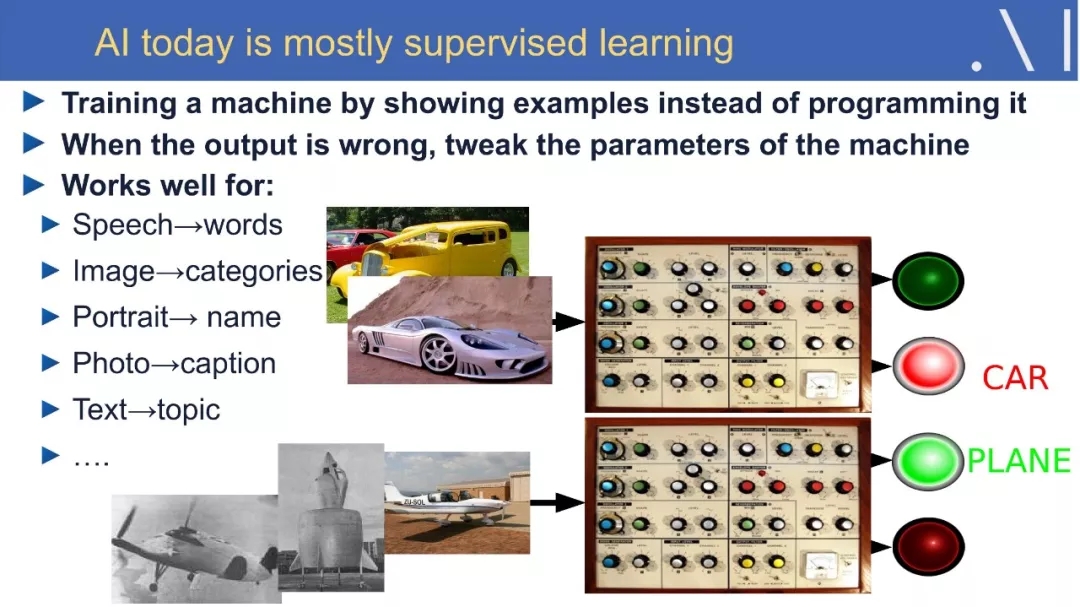

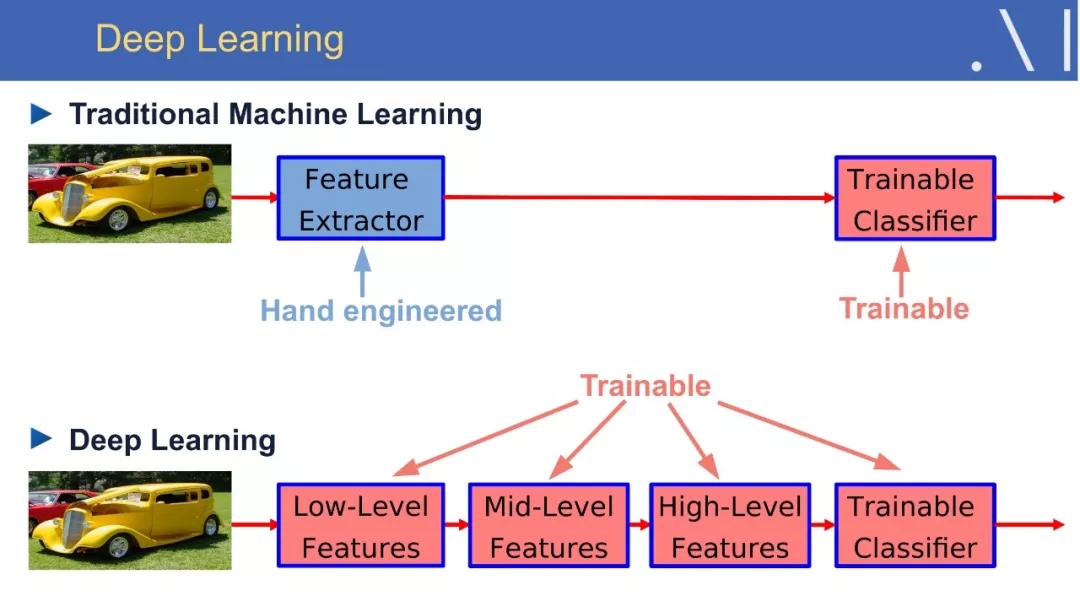

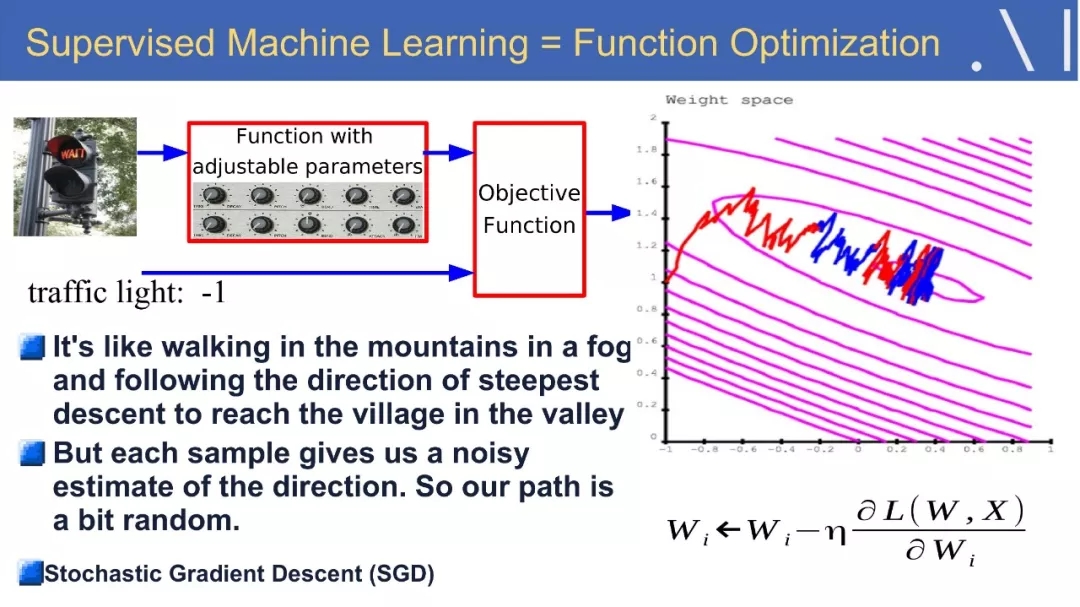

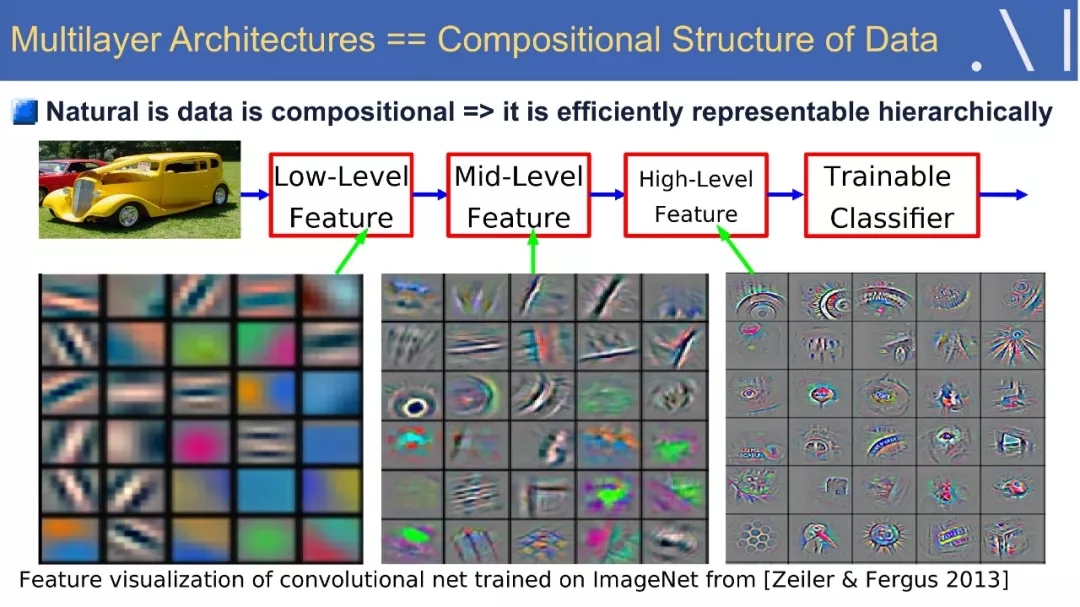

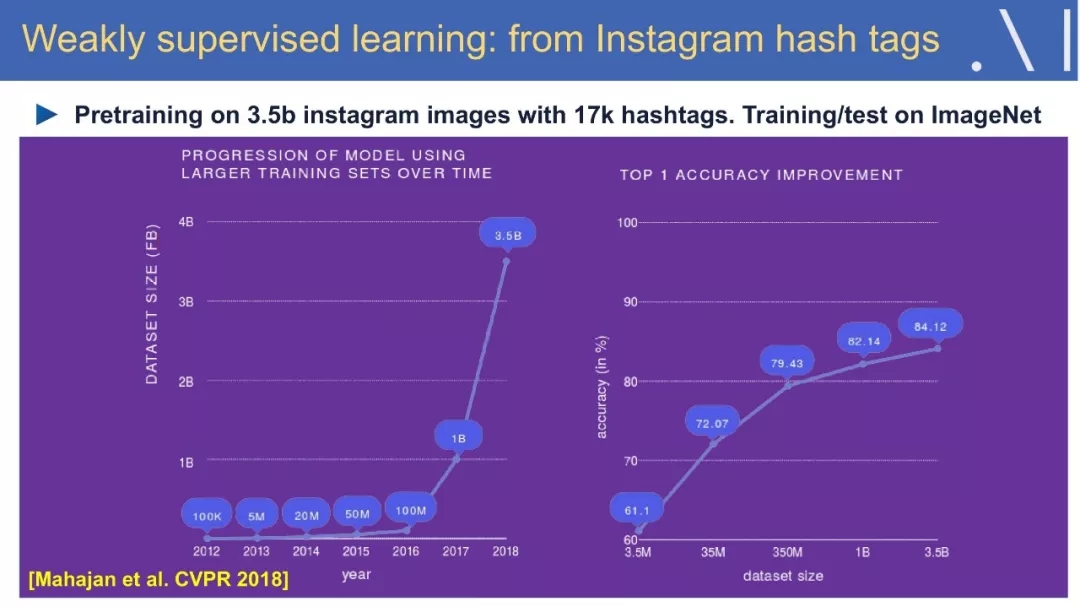

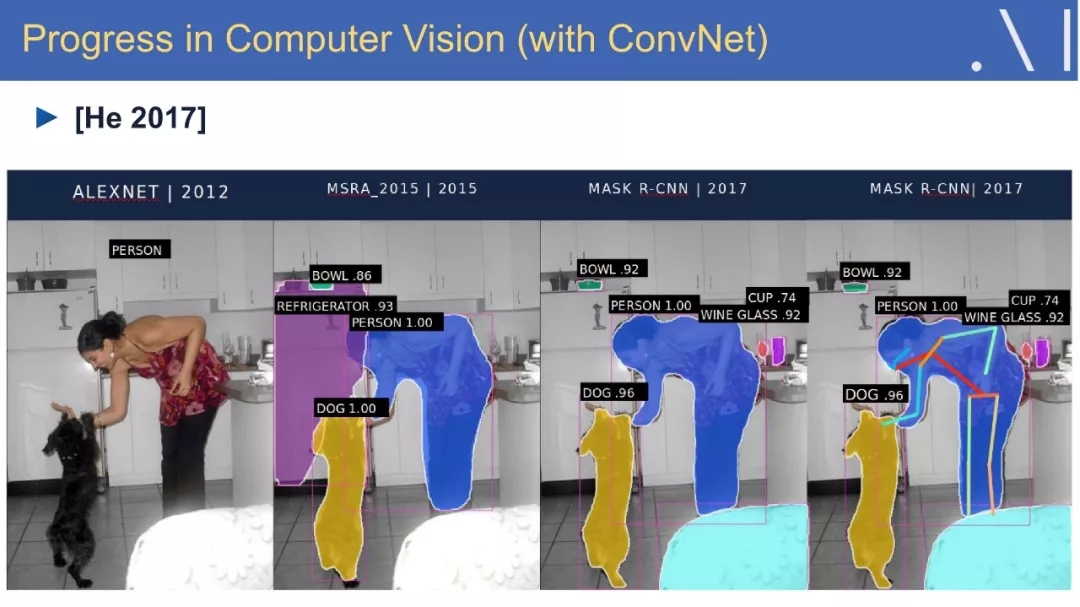

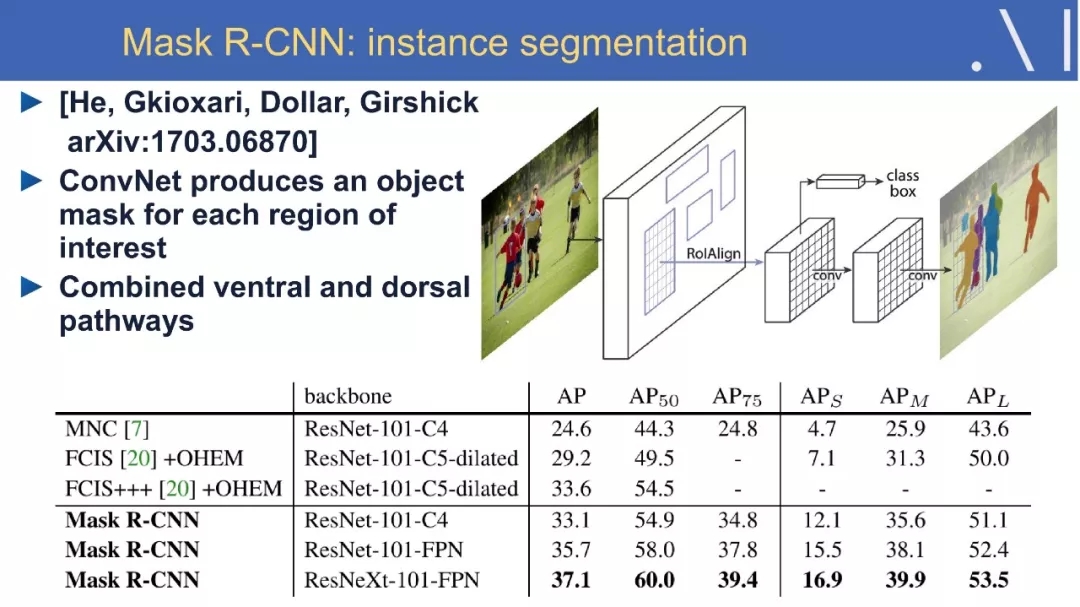

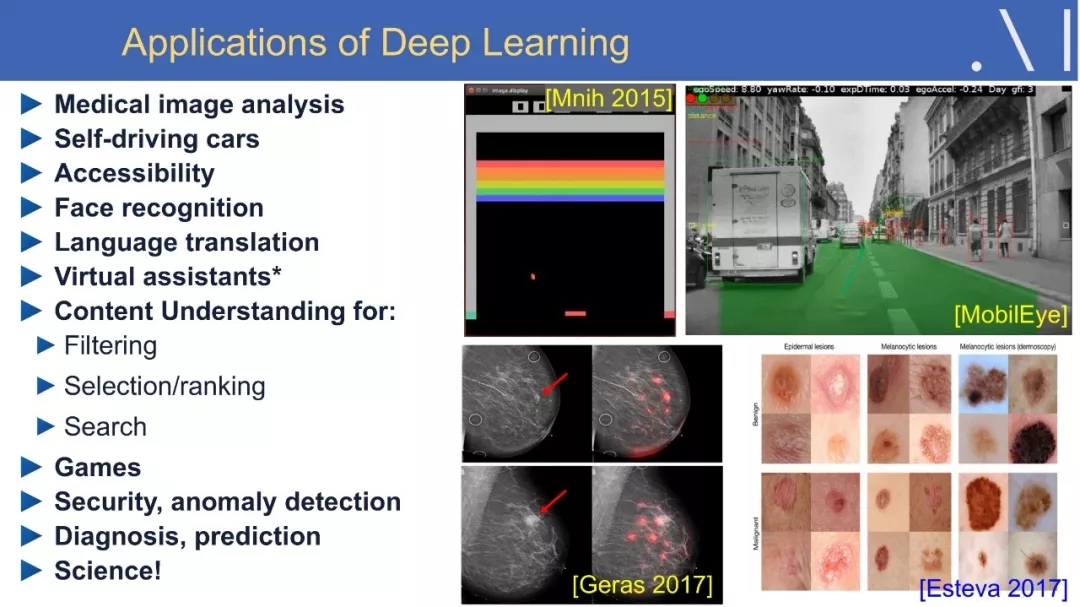

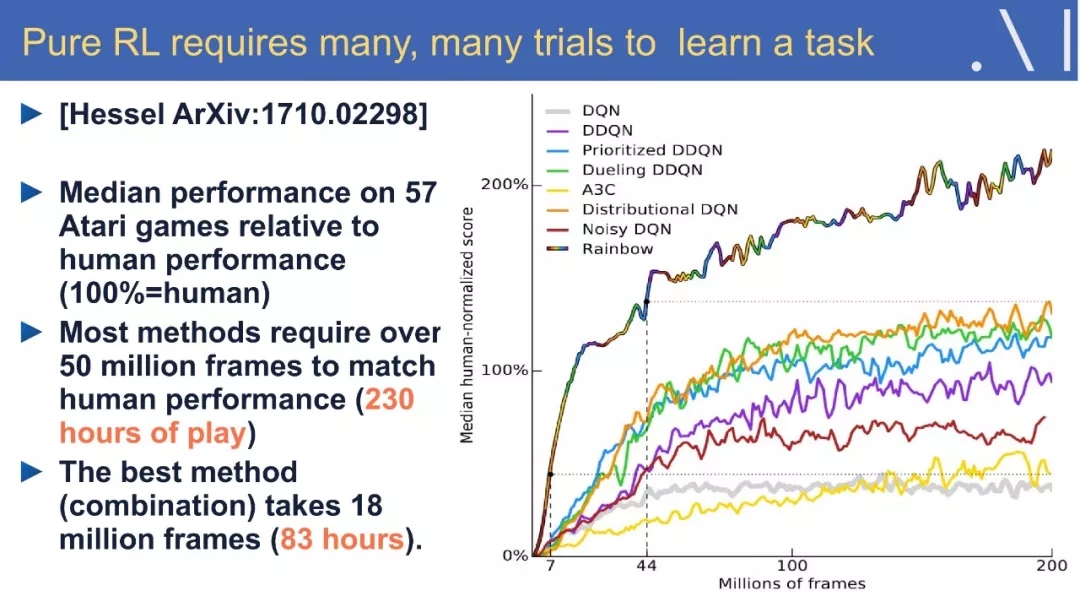

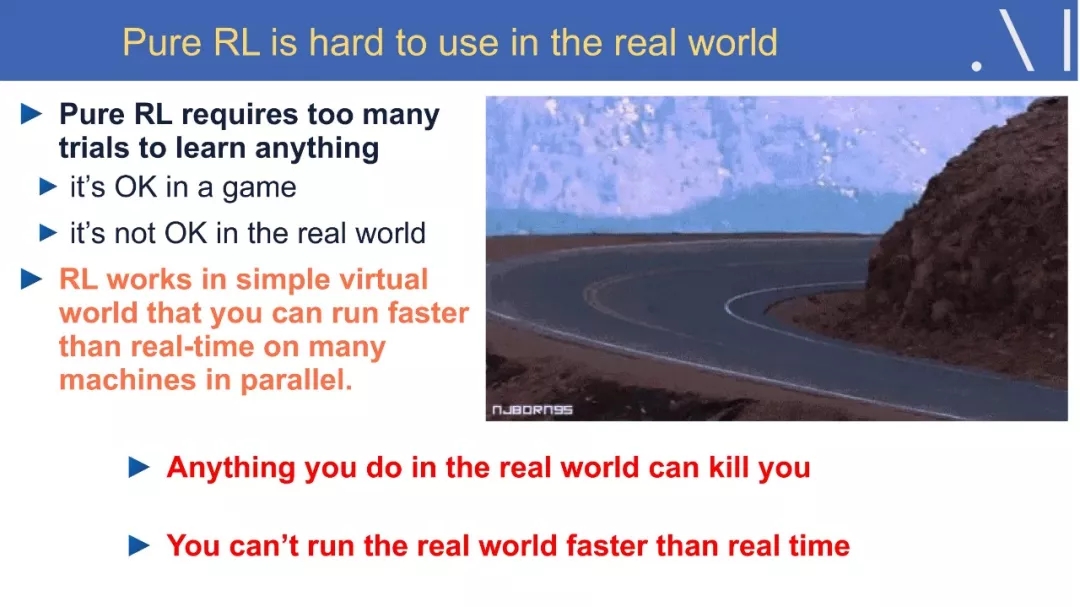

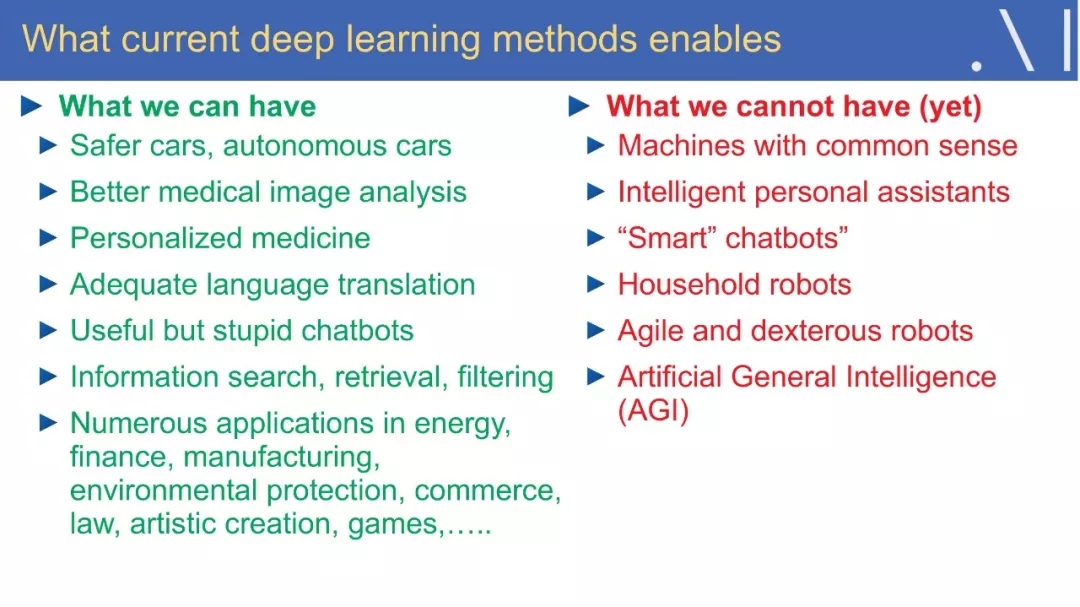

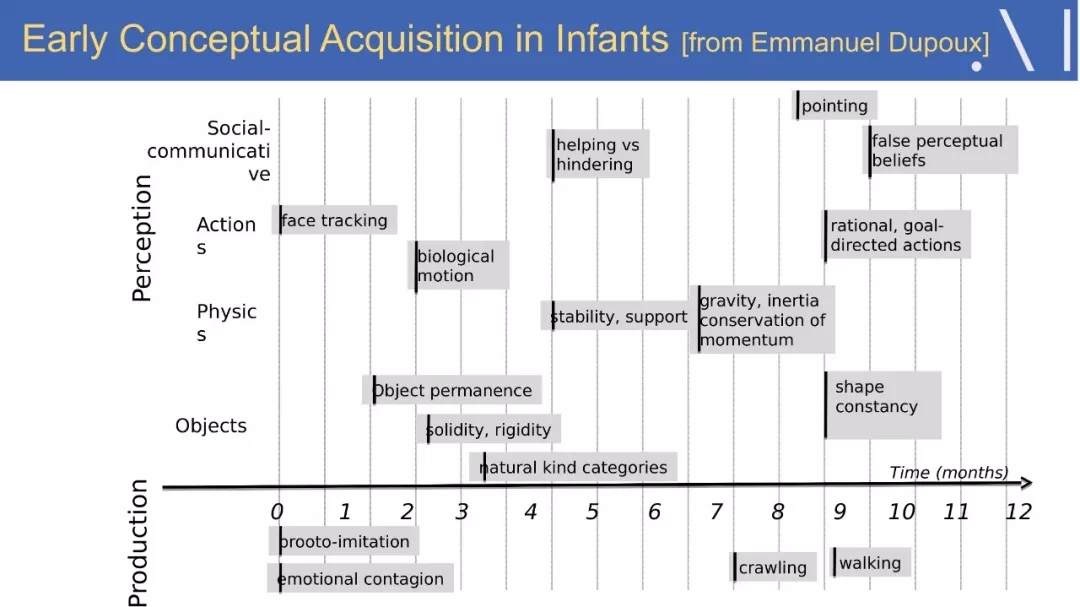

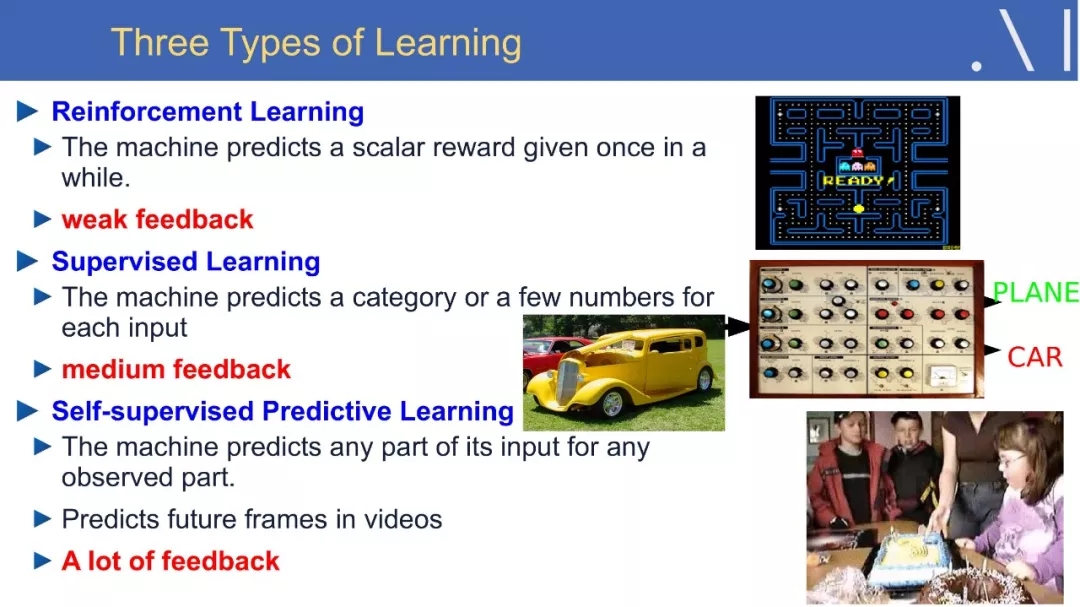

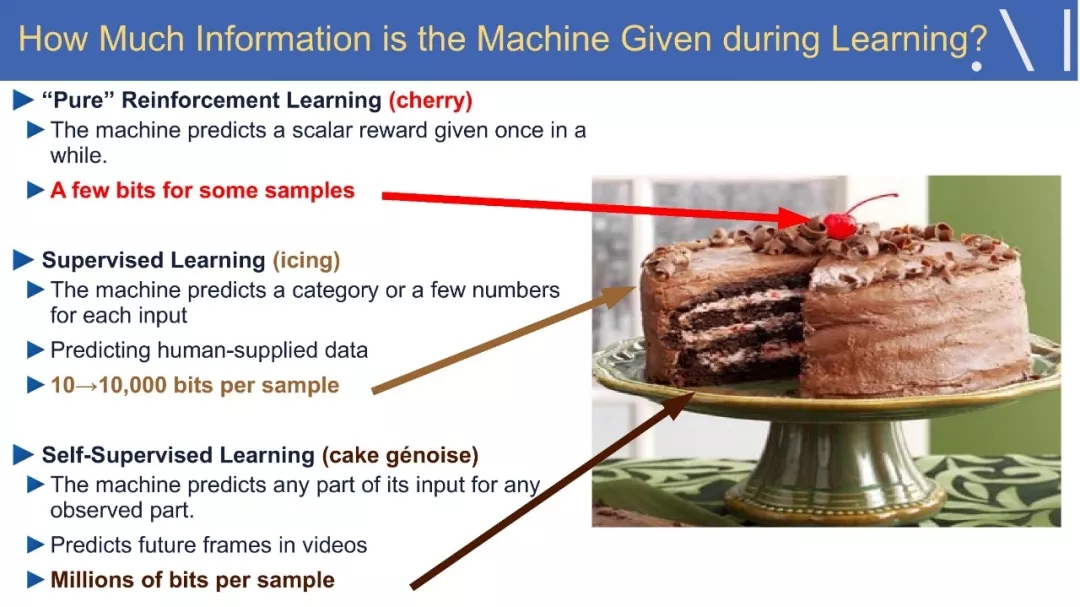

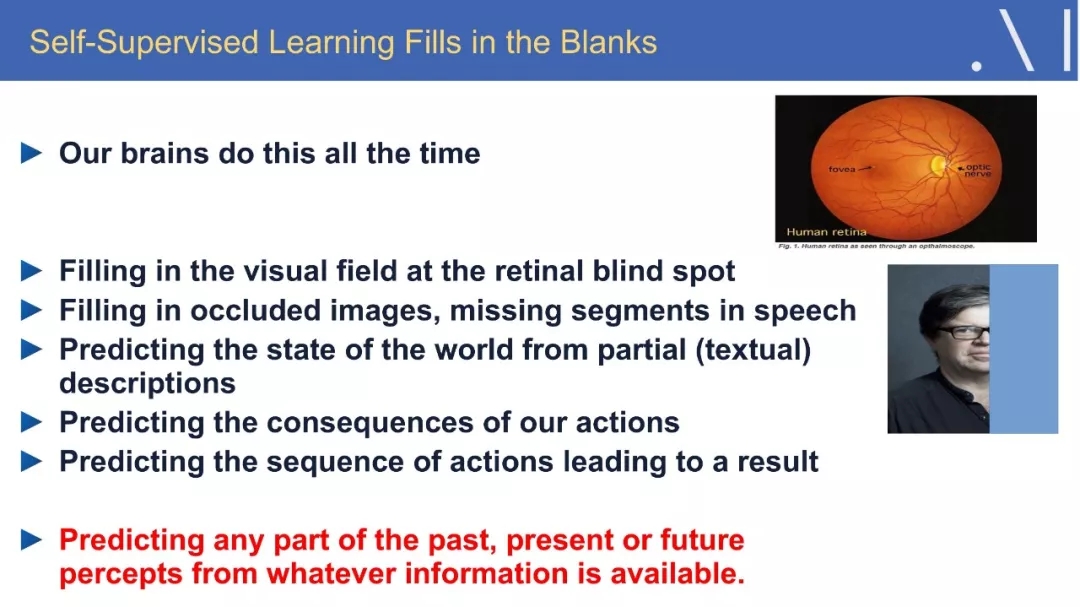

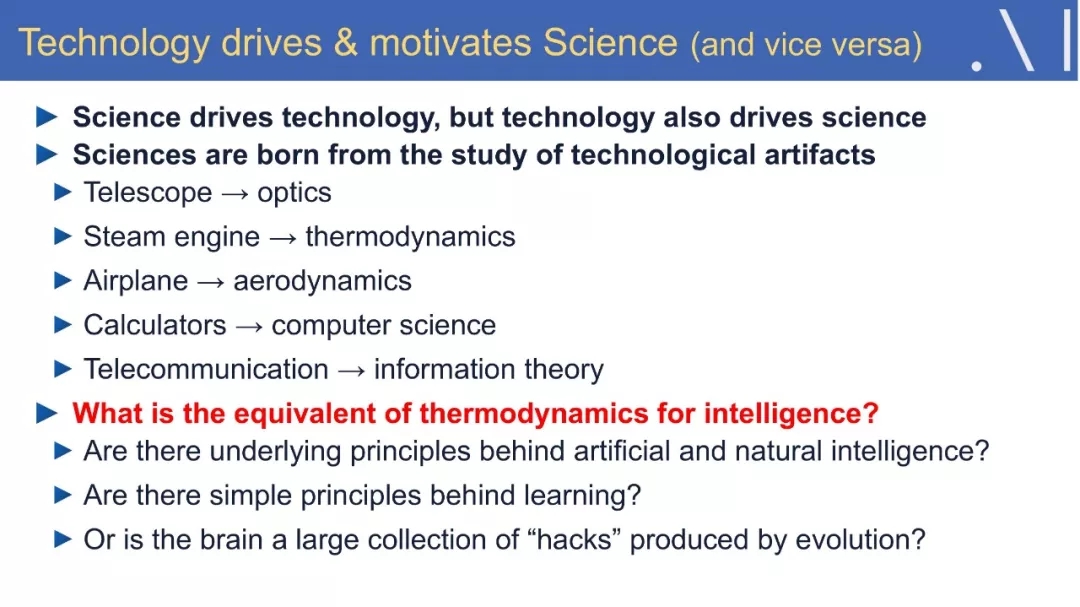

近年来,深度学习在计算机感知、自然语言处理和控制方面取得了重大进展。但几乎所有这些成功都在很大程度上依赖于有监督学习,在监督学习中,机器被要求预测人类提供的标签信息,或通过无模型的强化学习方法,不断的尝试各种行为空间的动作,以期达到收益(reward)较大化。这导致了监督学习需要大量的标记样本,使得它只适用于特定的任务。而强化学习即使在简单的学习任务中,也需要与环境进行大量的交互。相比之下,动物和人类似乎只通过观察和偶尔的互动便学会了大量与任务无关的关于世界如何运转的知识。动物学习新任务所需要的训练样本,以及与世界的互动都非常的少。

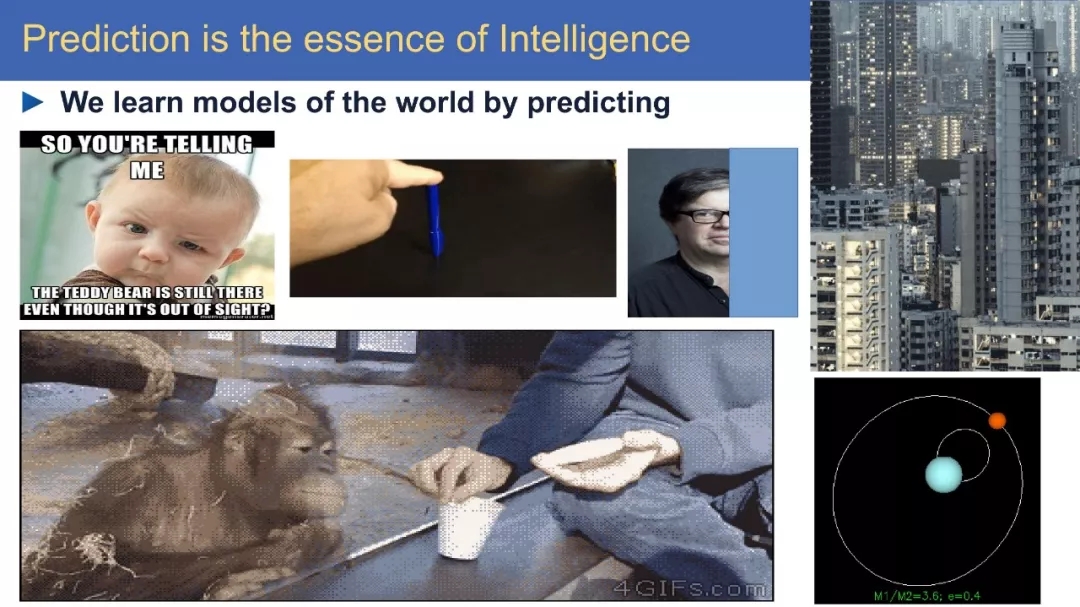

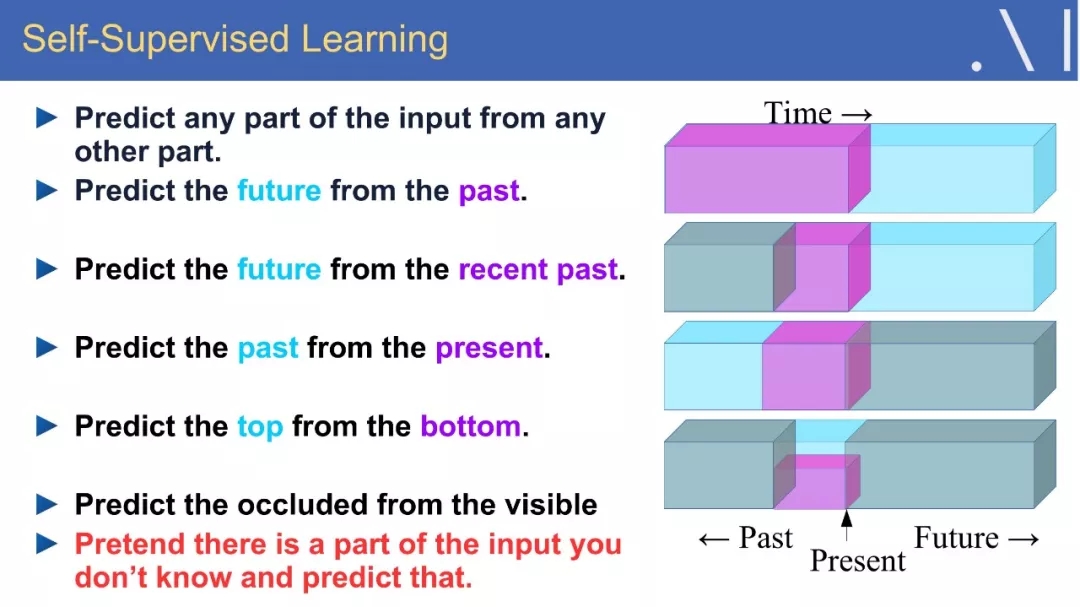

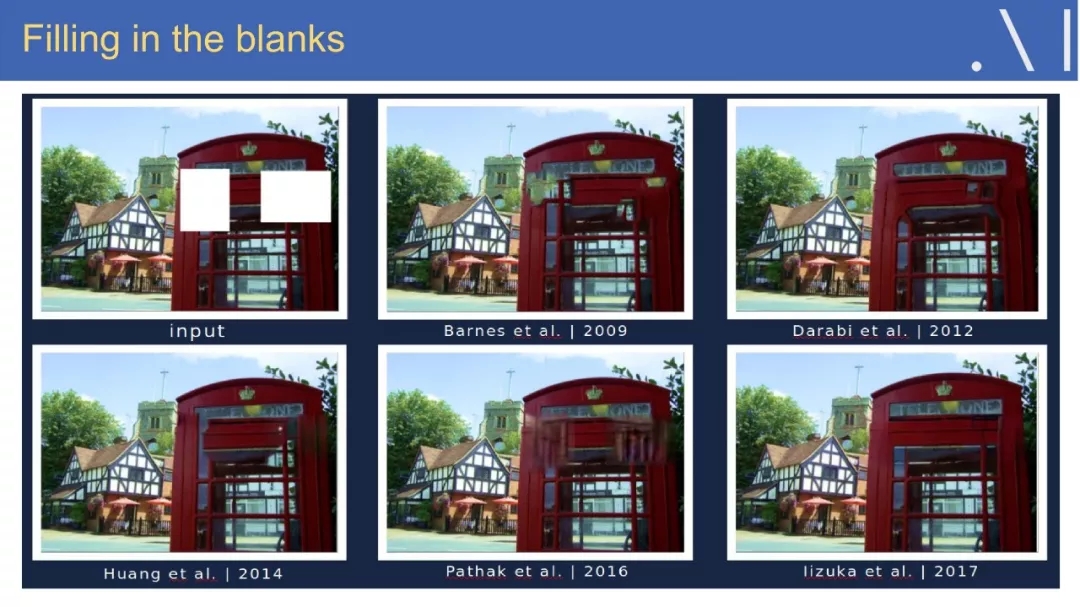

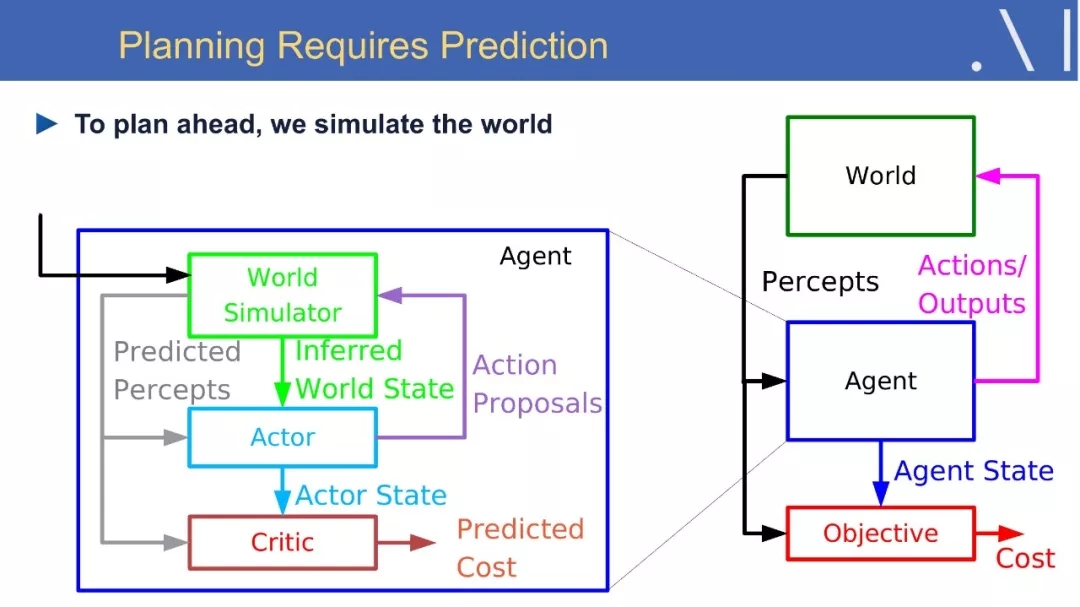

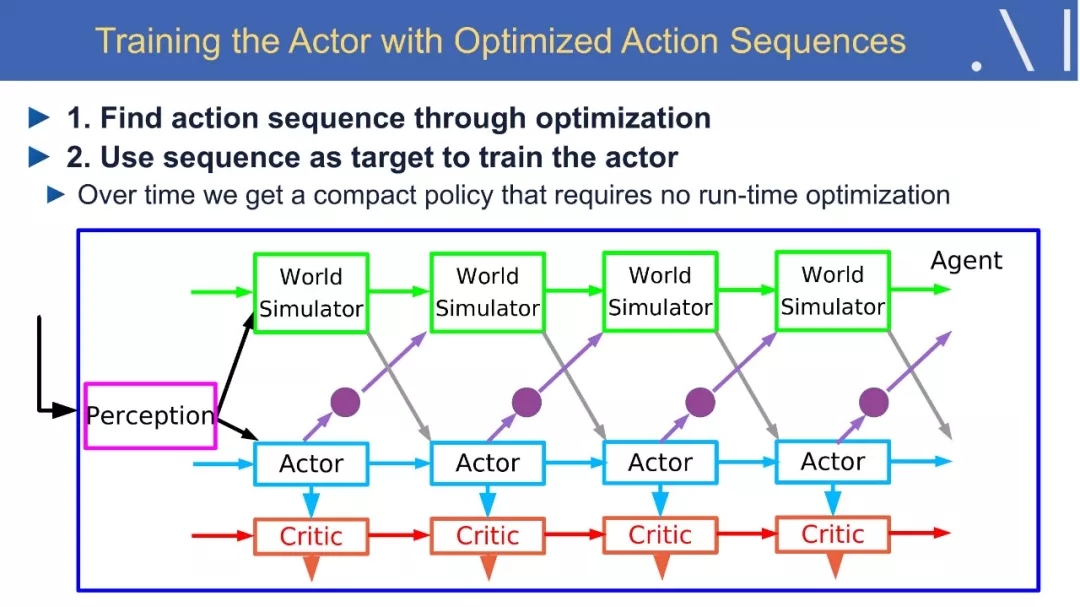

我们甚至能在30个小时的练习中,学会如何驾驶飞机。那么人类和动物是如何进行有效的学习呢?这里将提出一个假设:即预测模型中的自监督学习,是人工智能方法中必不可少的一部分。有了这些模型,人们就可以预测结果并计划如何行动,好的预测模型可能是直觉、推理和“常识”的基础,让我们能够填补缺失的信息:从过去和现在的经验中预测未来,或从嘈杂的世界中推断当前的状态。有人可能会说,预测是智力的本质,在简要介绍了深度学习的现状之后,我们将讨论一些有前途的自监督学习的原则和方法。

作者简介:

在人工智能研究领域,Yann LeCun、Geoffrey Hinton 和 Yoshua Bengio一直被公认为深度学习三巨头。

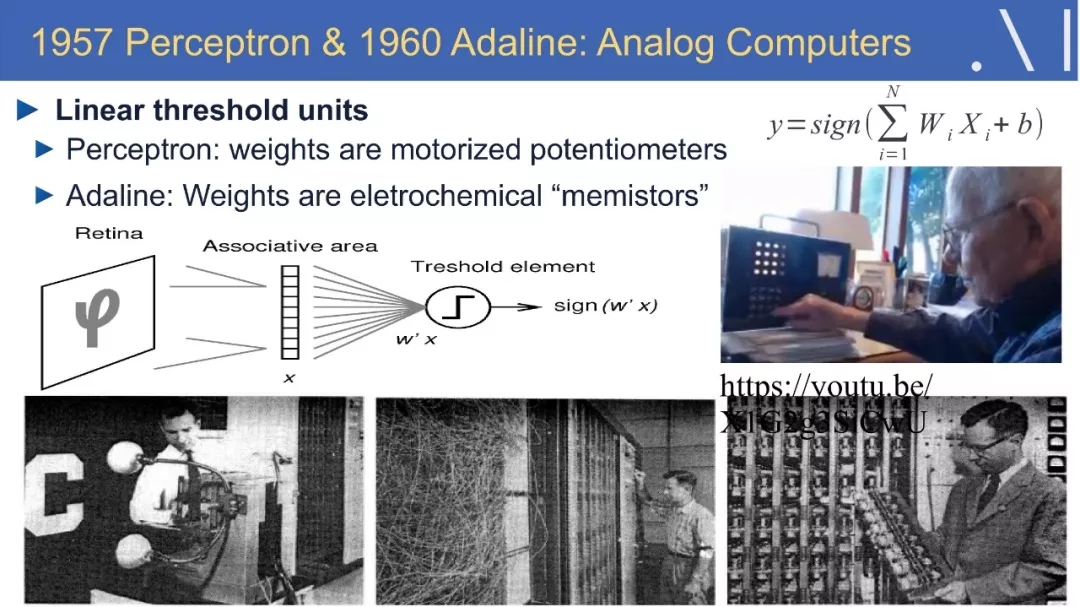

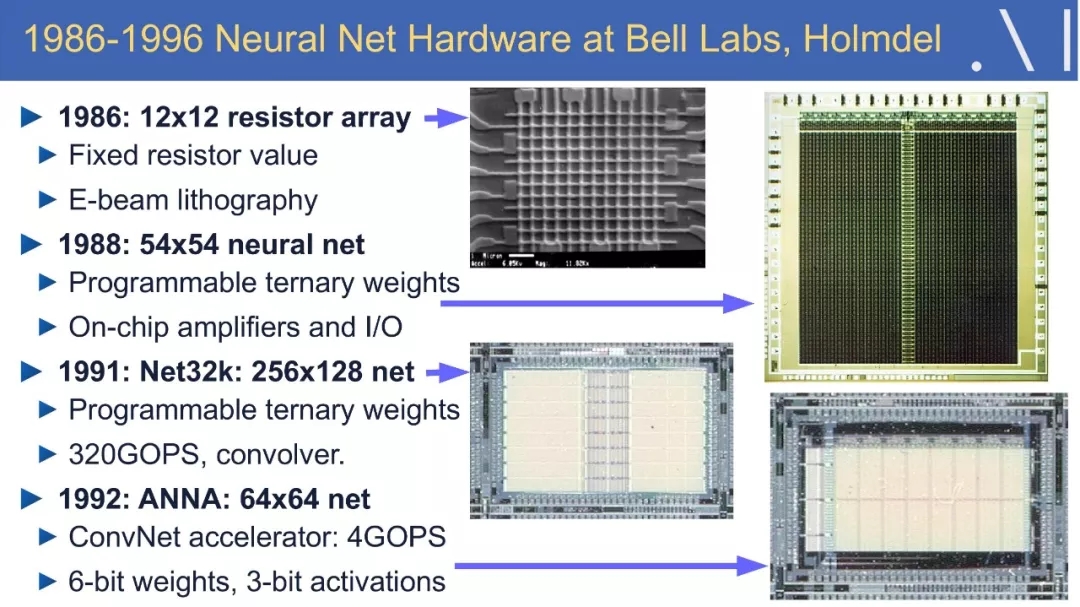

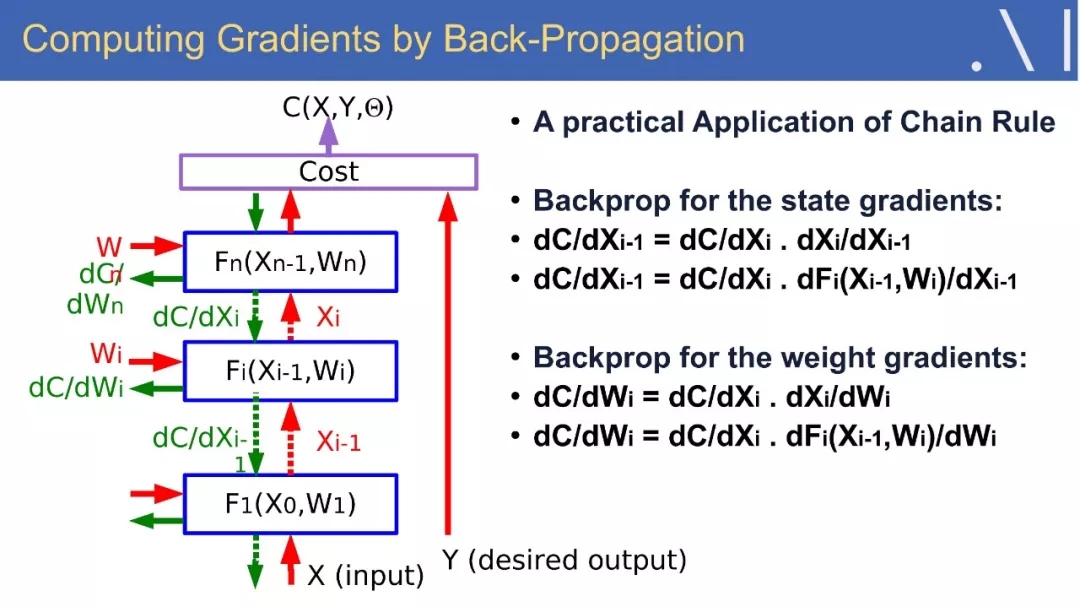

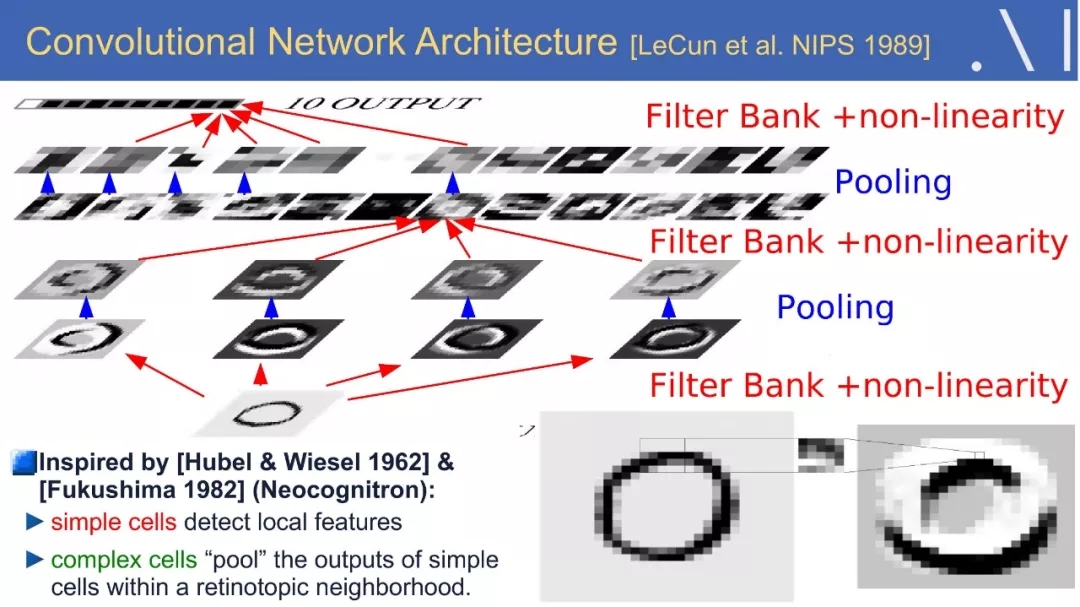

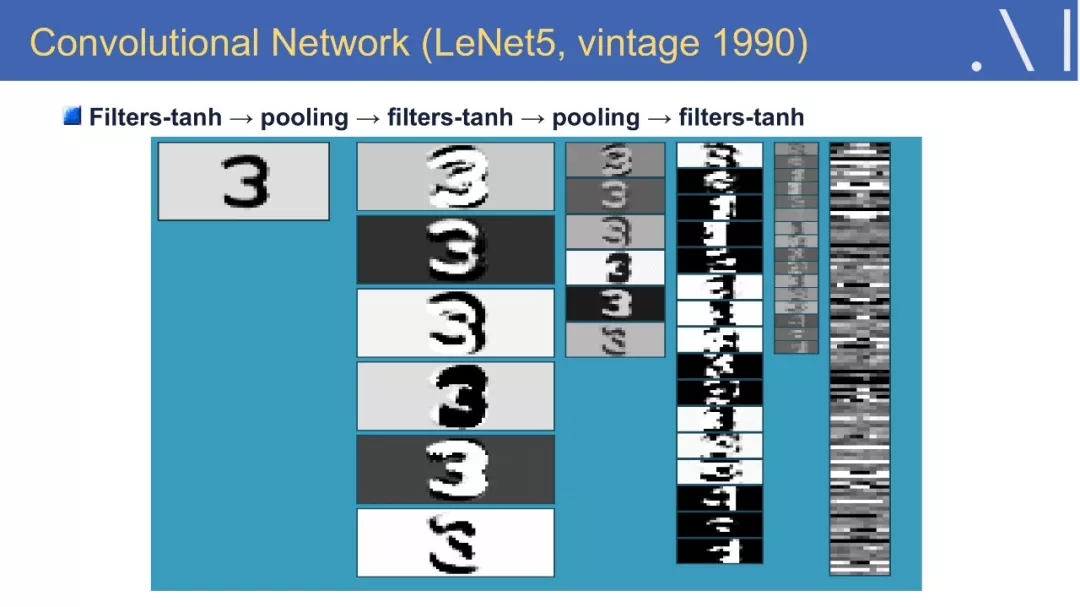

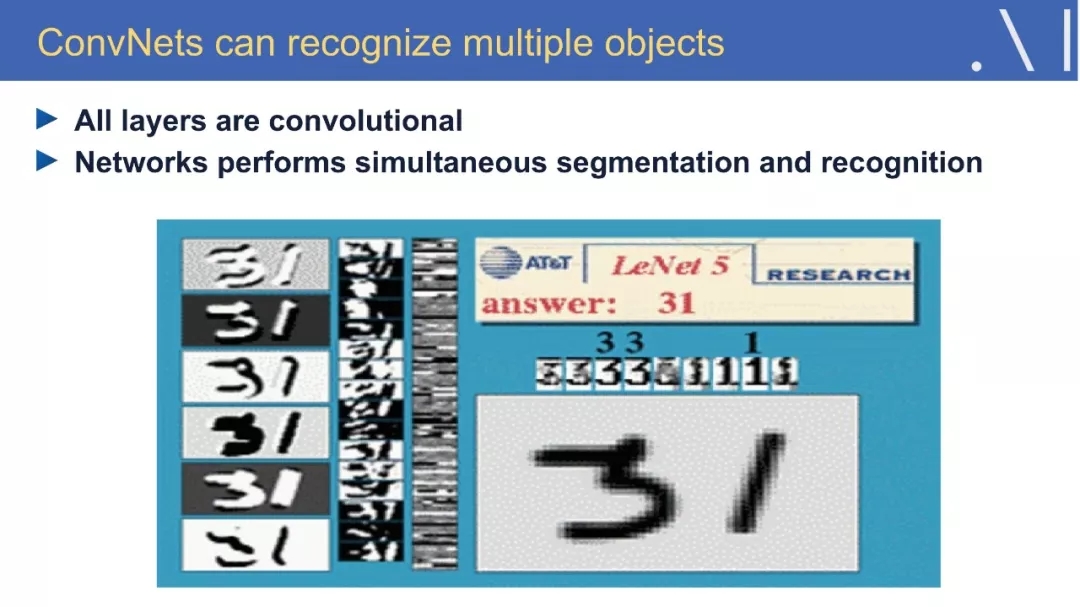

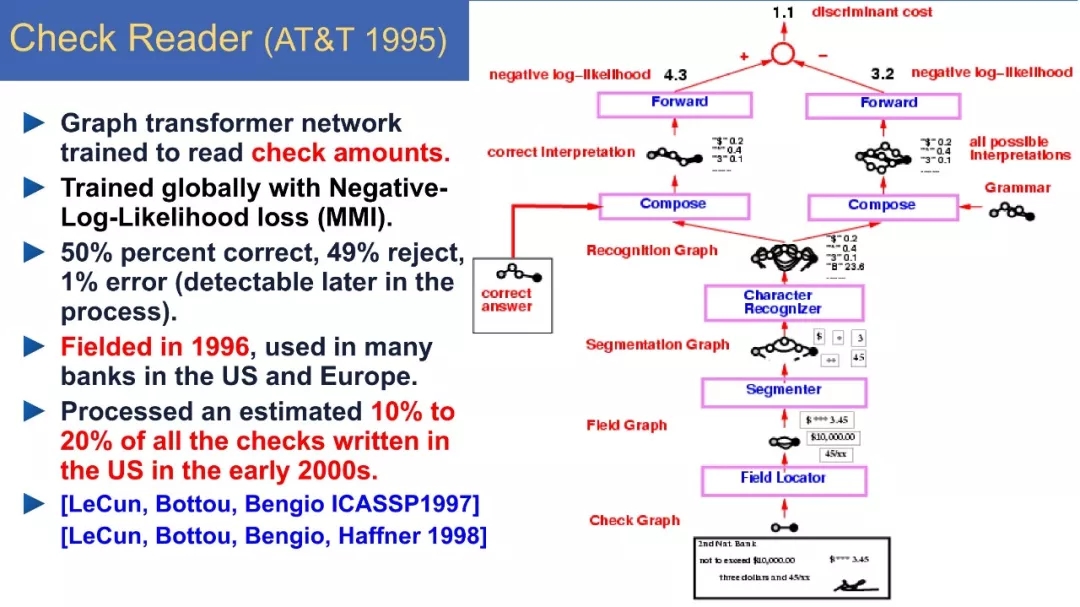

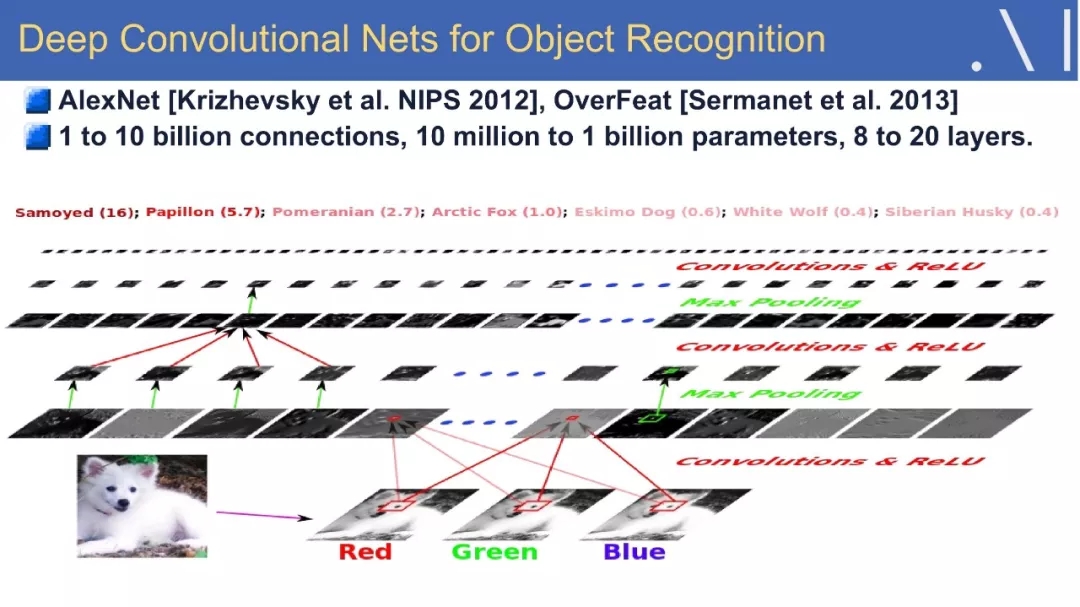

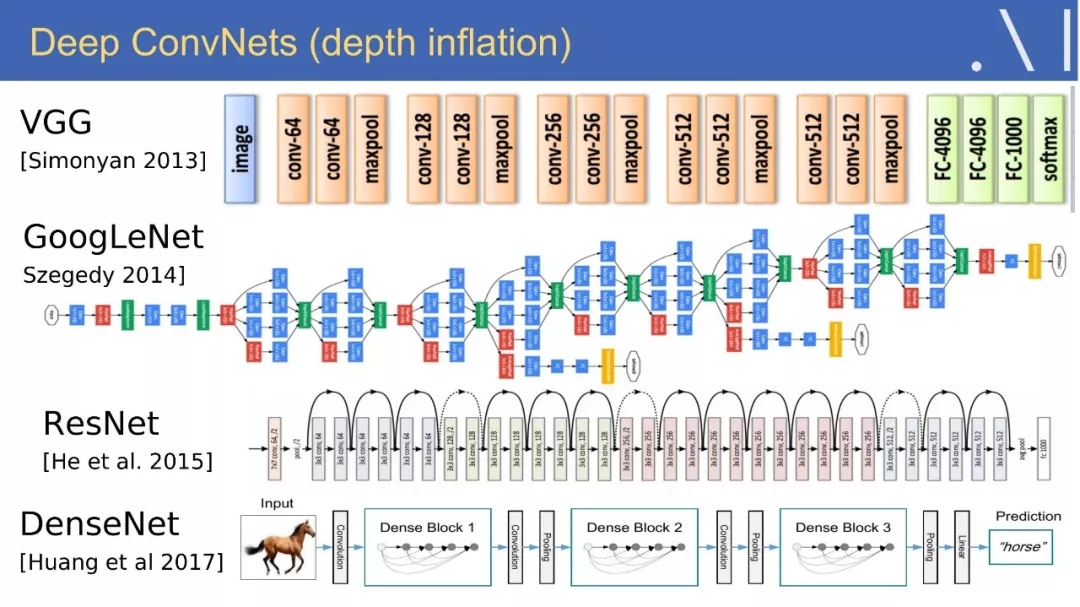

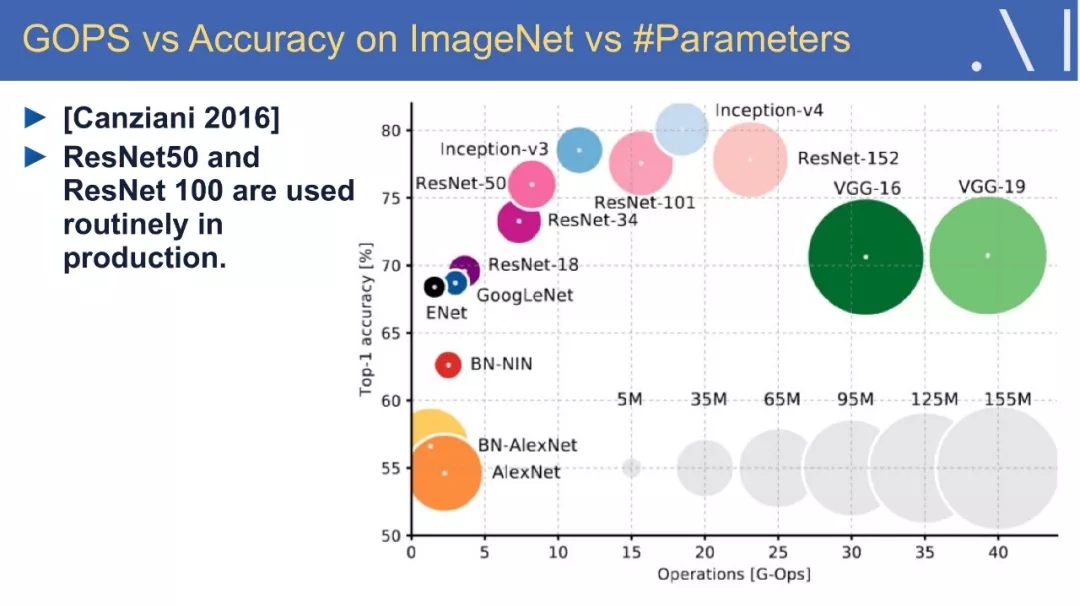

Yann LeCun,自称中文名“杨立昆”,计算机科学家,被誉为“卷积网络之父”,为卷积神经网络(CNN,Convolutional Neural Networks)和图像识别领域做出了重要贡献,以手写字体识别、图像压缩和人工智能硬件等主题发表过 190 多份论文,研发了很多关于深度学习的项目,并且拥有14项相关的美国专利。他同Léon Bottou和Patrick Haffner等人一起创建了DjVu图像压缩技术,同Léon Bottou一起开发了一种开源的Lush语言,比Matlab功能还要强大,并且也是一位Lisp高手。(Backpropagation,简称BP)反向传播这种现阶段常用来训练人工神经网络的算法,就是 LeCun 和其老师“神经网络之父”Geoffrey Hinton 等科学家于 20 世纪 80 年代中期提出的,而后 LeCun 在贝尔实验室将 BP 应用于卷积神经网络中,并将其实用化,推广到各种图像相关任务中。

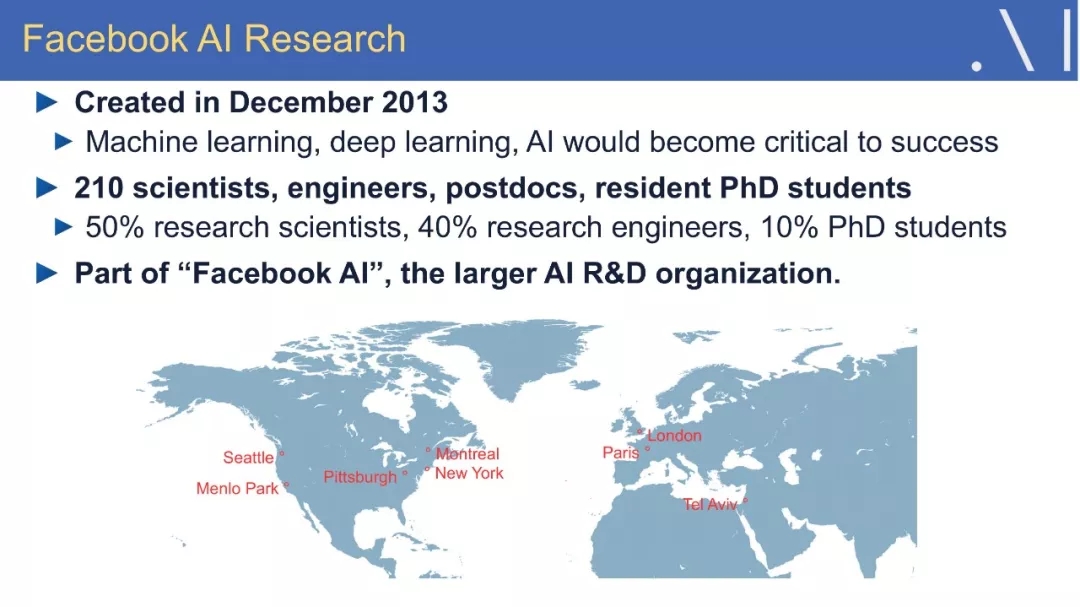

Yann LeCun 也是Facebook人工智能研究院院长,纽约大学的 Silver 教授,隶属于纽约大学数据科学中心、Courant 数学科学研究所、神经科学中心和电气与计算机工程系。加盟Facebook之前,Lecun已在贝尔实验室工作超过20年,期间他开发了一套能够识别手写数字的系统,叫作LeNet,用到了卷积神经网络,已开源。他在 1983 年在巴黎 ESIEE 获得电子工程学位,1987 年在 Université P&M Curie 获得计算机科学博士学位。在完成了多伦多大学的博士后研究之后,他在 1988 年加入了 AT&T 贝尔实验室(AT&T Bell Laboratories /Holmdel, NJ),在 1996 年成为 AT&T Labs-Research 的图像处理研究部门主管。2003 年,他加入纽约大学获得教授任职,并在 NEC 研究所(普林斯顿)呆过短暂一段时间。2012 年他成为纽约大学数据科学中心的创办主任。2013 年末,他成为 Facebook 的人工智能研究中心(FAIR)负责人,并仍保持在 NYU 中兼职教学。从 2015 到 2016 年,Yann LeCun 还是法兰西学院的访问学者。

LeCun 是 ICLR 的发起人和常任联合主席(general co-chair),并且曾在多个编辑委员会和会议组织委员会任职。他是加拿大高级研究所(Canadian Institute for Advanced Research)机器与大脑学习(Learning in Machines and Brains)项目的联合主席。他同样是 IPAM 和 ICERM 的理事会成员。他曾是许多初创公司的顾问,并是 Elements Inc 和 Museami 的联合创始人。LeCun 位列新泽西州的发明家名人堂,并获得 2014 年 IEEE 神经网络先锋奖(Neural Network Pioneer Award)、2015 年 IEEE PAMI 杰出研究奖、2016 年 Lovie 终身成就奖和来自墨西哥 IPN 的名誉博士学位。

视频地址:

https://ucsb.app.box.com/s/msam98ewhhk48t60p75glvm9h0fv57fl

内容大纲:

1、深度学习现状

2、强化学习进展

3、距离真正的人工智能,我们错过了什么?

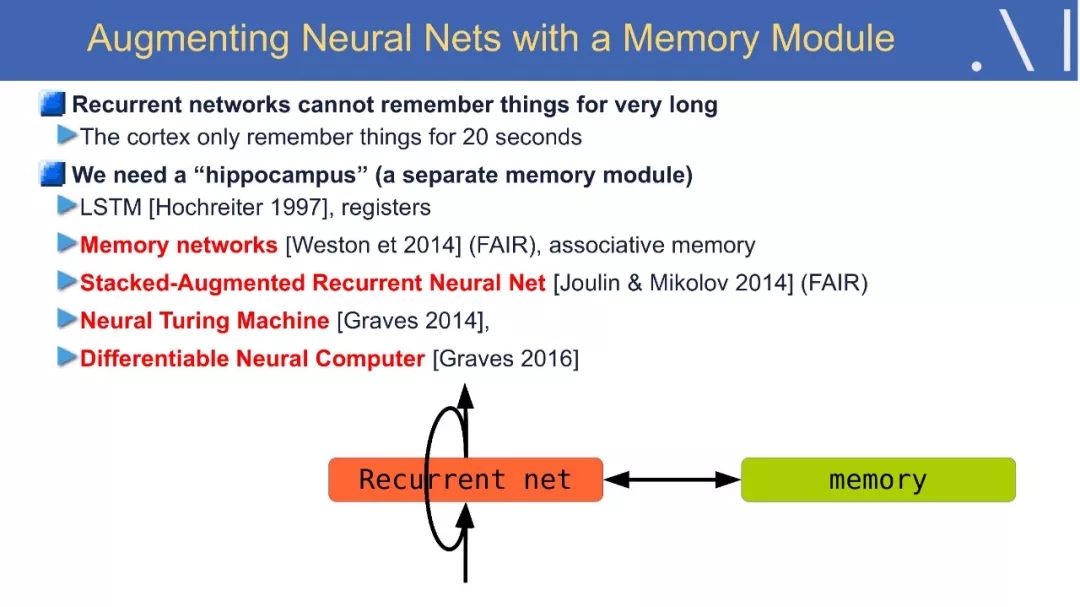

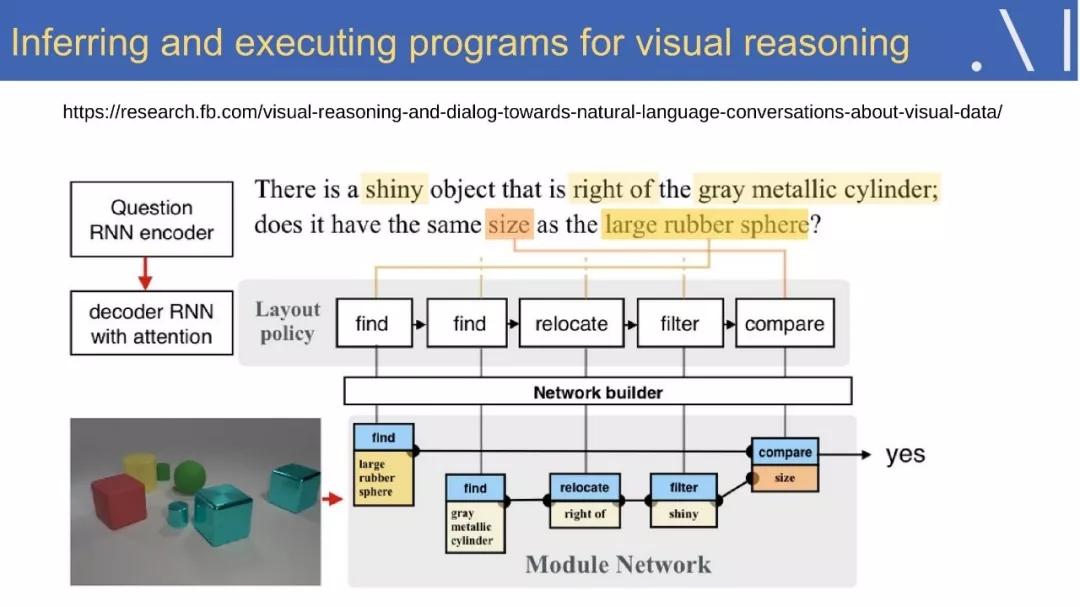

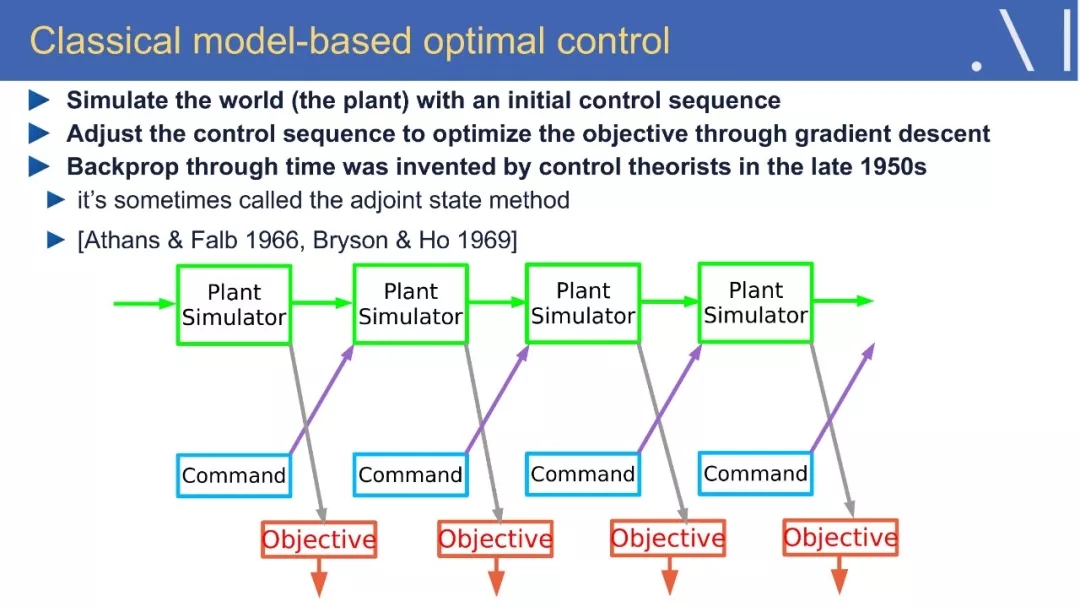

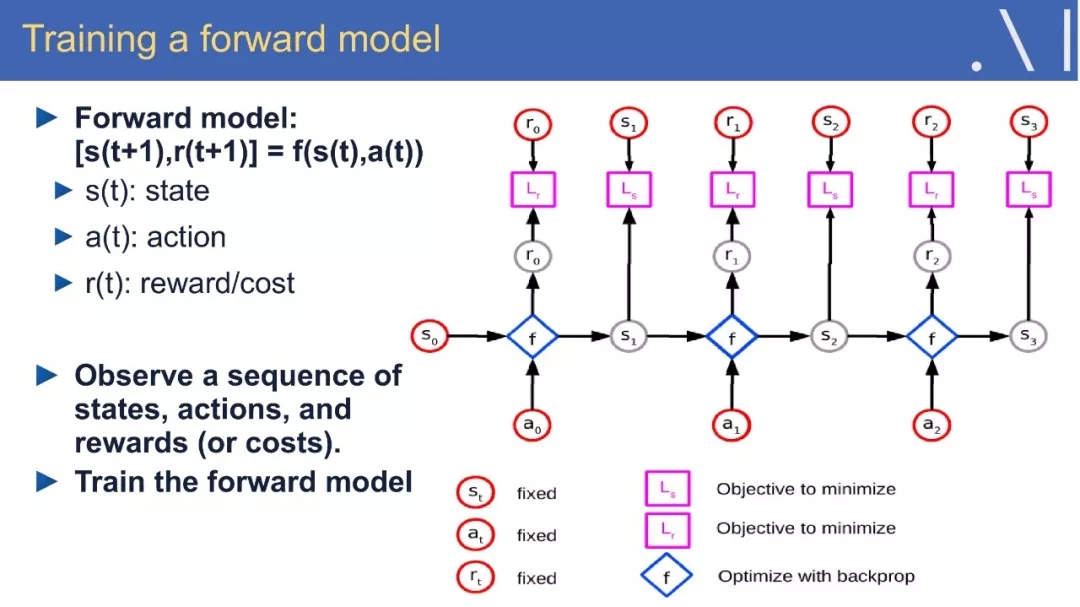

4、可微分编程:深度学习与推理的结合

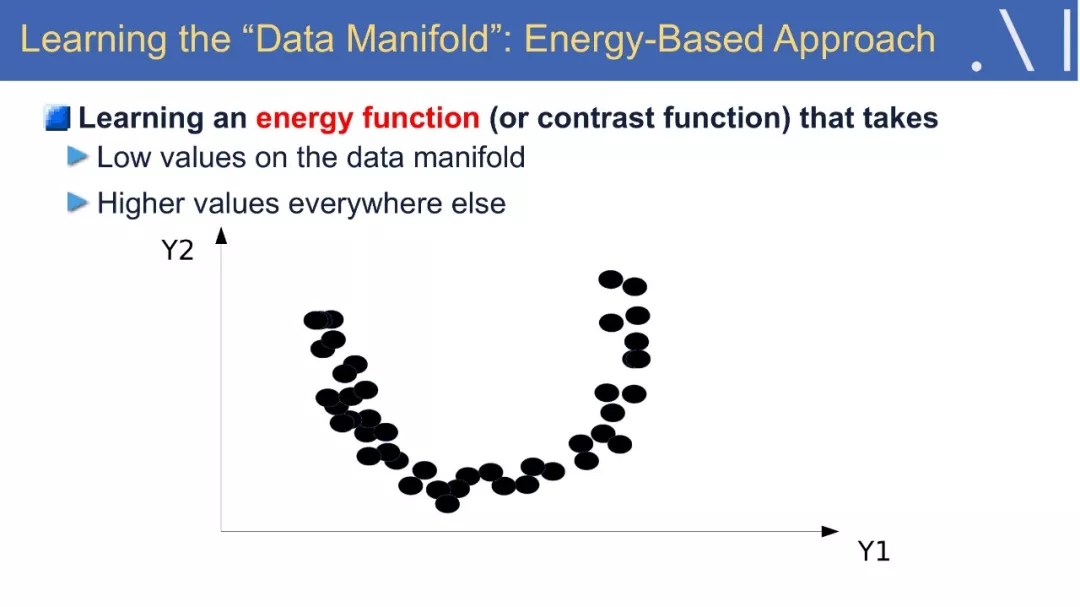

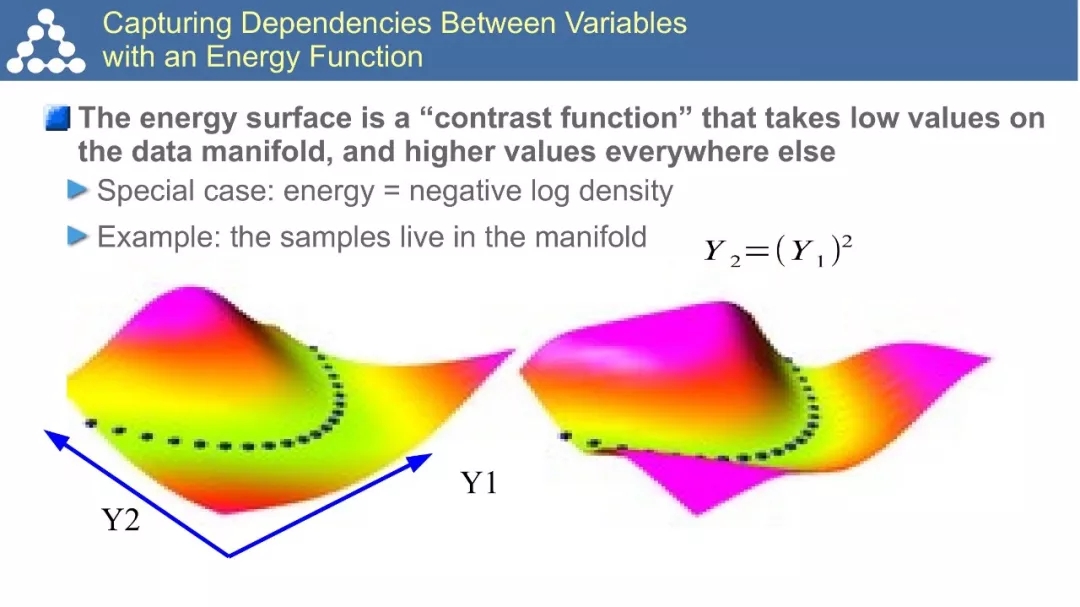

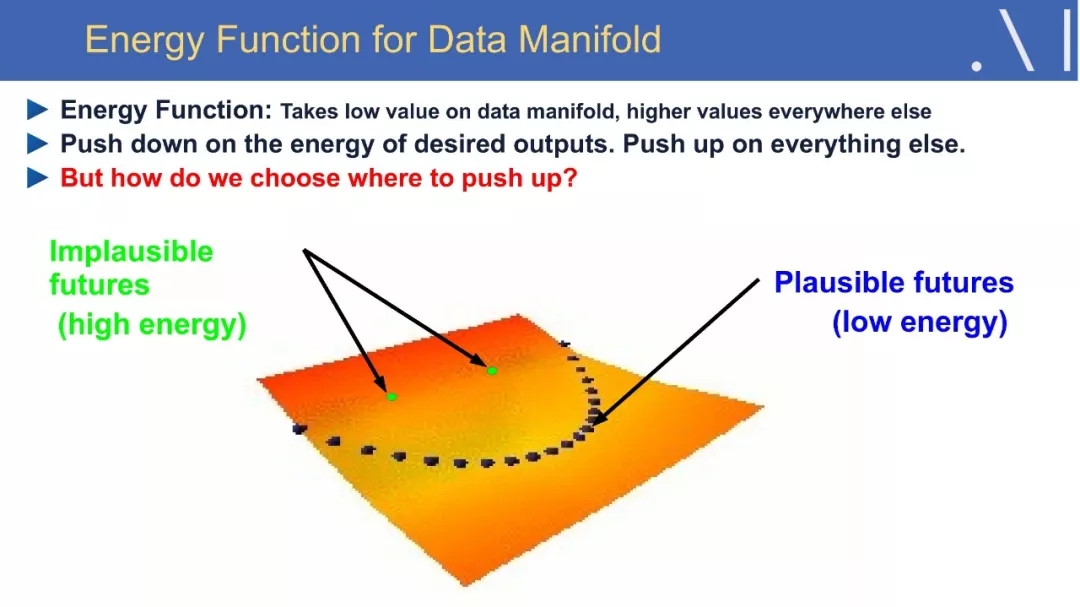

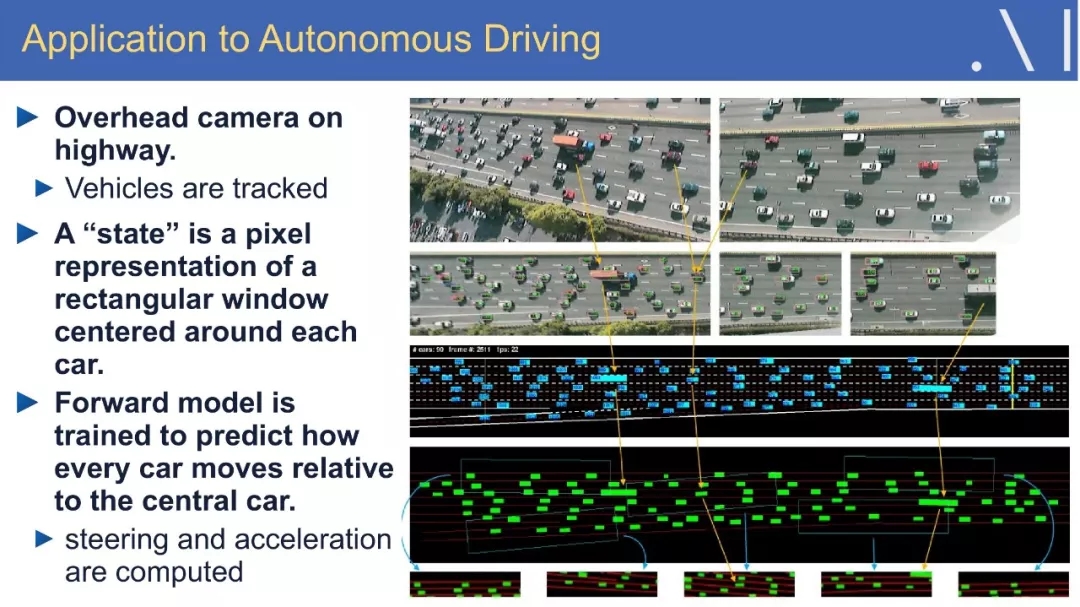

5、学习真实世界的预测模型

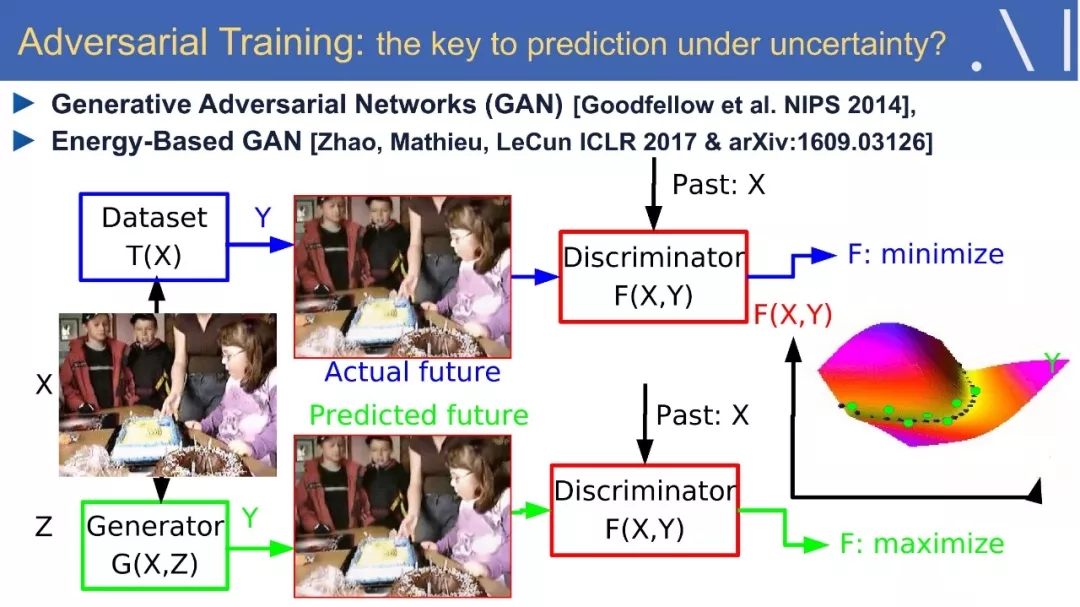

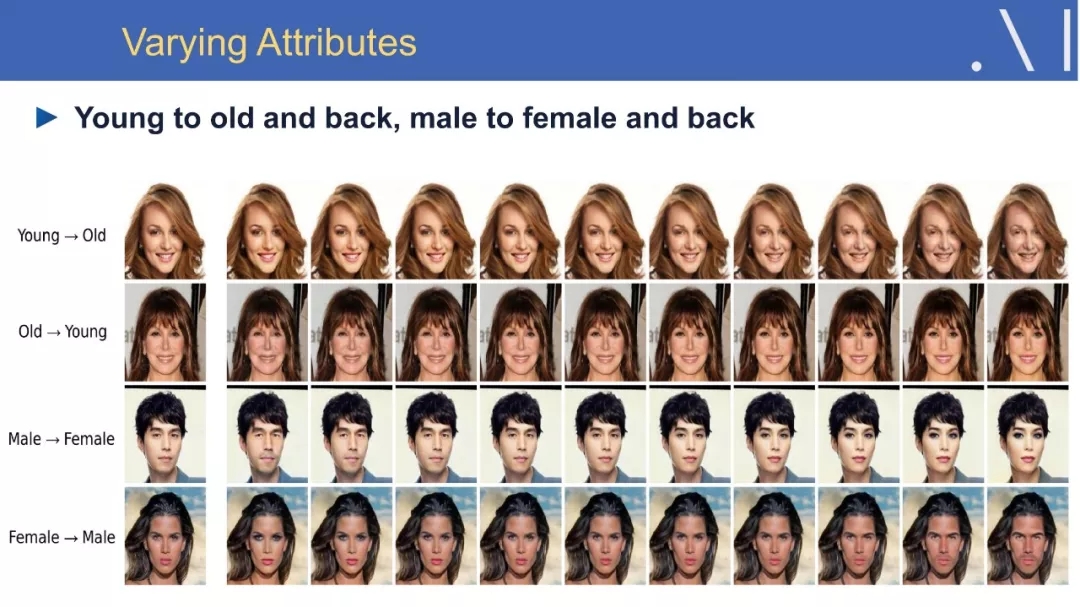

6、对抗训练

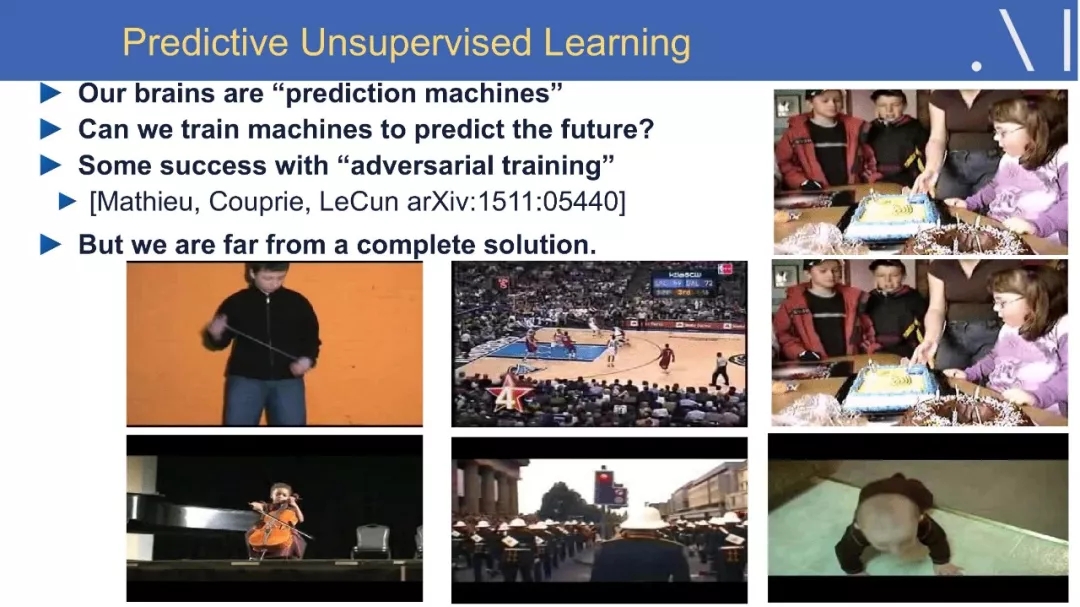

7、采用对抗训练的视频预测方法

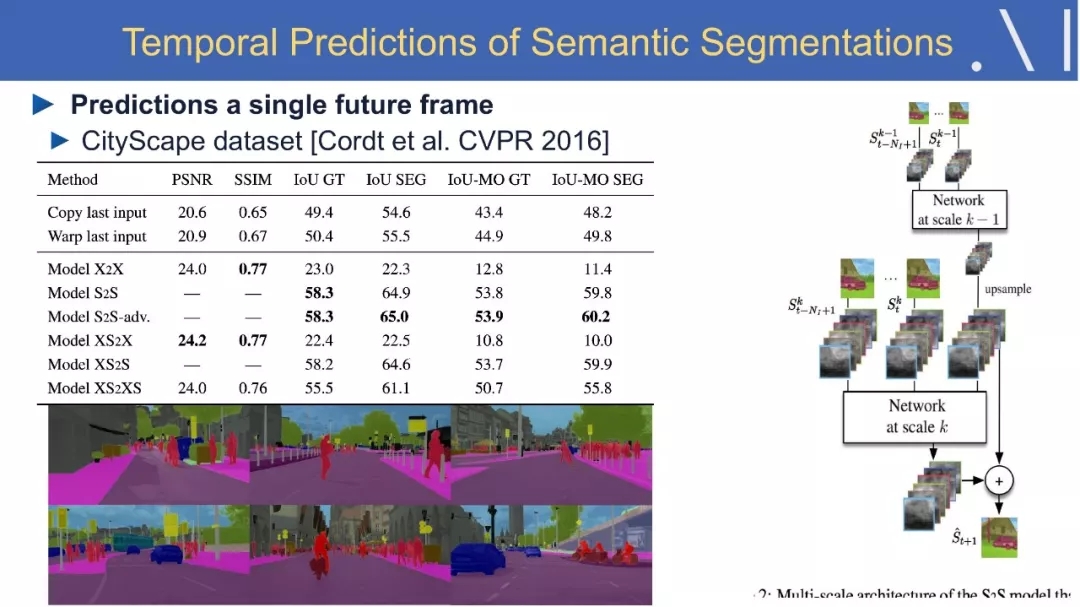

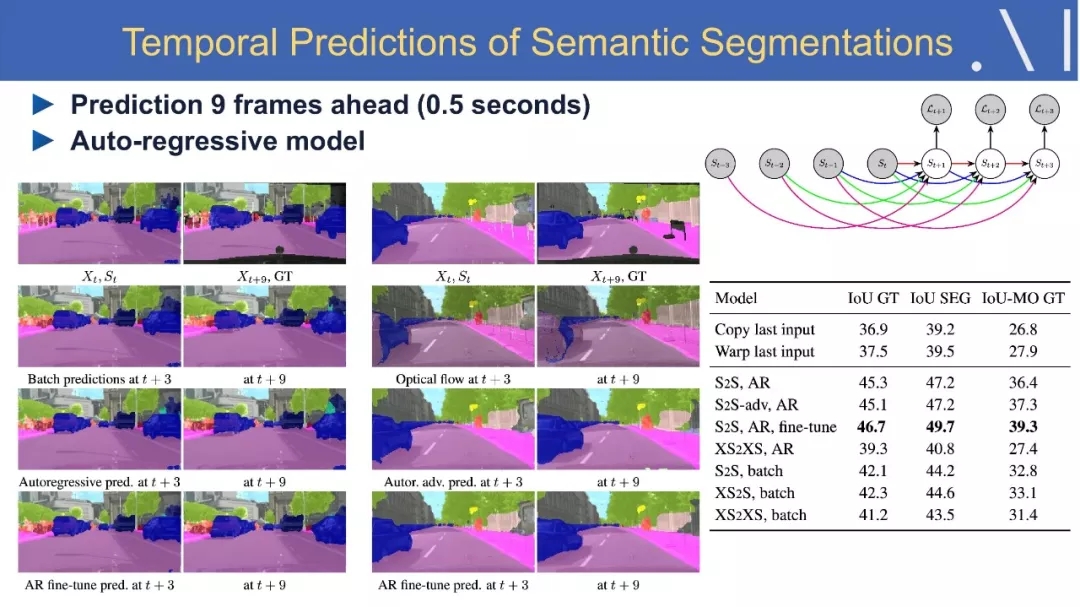

8、语义分割中的视频预测方法

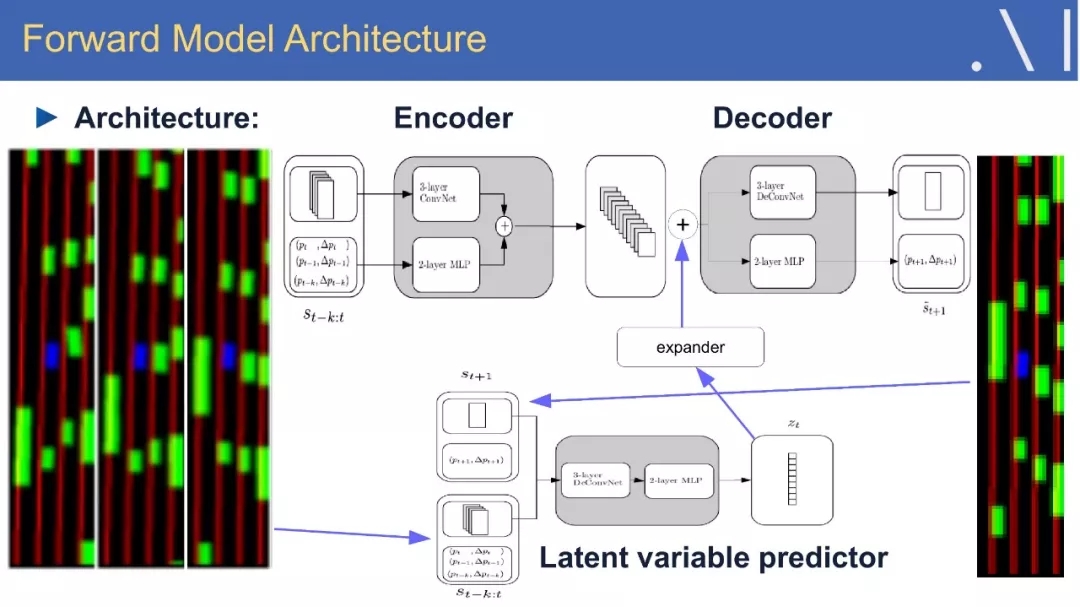

9、Stochastic Latent-Variable Forward Model:目标编码网络

10、AI对未来的影响

内容全文:

声明:文章收集于网络,如有侵权,请联系小编及时处理,谢谢!

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4832.html

摘要:无监督式学习是突破困境的关键,采用无监督学习的对抗训练让拥有真正自我学习的能力。如何让拥有人类的常识认为要用无监督式学习。强化学习是蛋糕上不可或缺的樱桃,所需要资料量可能大约只有几个,监督式学习 6 月 29 日,台湾大学。卷积神经网络之父、FacebookAI 研究院院长 Yann LeCun 以「Deep Learning and the Path to AI」为题,对深度学习目前的发展...

摘要:几乎没有人比岁的更能与深度学习紧密地联系在一起。他于年成为纽约大学教授,并从此引领了深度学习的发展。最近,深度学习及其相关领域已然成为最活跃的计算机研究领域之一。 本文原载IEEE,作者Lee Gomes,由机器之心翻译出品,参与成员:电子羊、翬、泥泥刘、赤龙飞、郑劳蕾、流明。人工智能经历了几次低潮时期,这些灰暗时光被称作「AI寒冬」。这里说的不是那段时期,事实上,人工智能如今变得异常火热,...

摘要:主流机器学习社区对神经网络兴趣寡然。对于深度学习的社区形成有着巨大的影响。然而,至少有两个不同的方法对此都很有效应用于卷积神经网络的简单梯度下降适用于信号和图像,以及近期的逐层非监督式学习之后的梯度下降。 我们终于来到简史的最后一部分。这一部分,我们会来到故事的尾声并一睹神经网络如何在上世纪九十年代末摆脱颓势并找回自己,也会看到自此以后它获得的惊人先进成果。「试问机器学习领域的任何一人,是什...

摘要:多加了这两层卷积层和汇集层是卷积神经网络和普通旧神经网络的主要区别。卷积神经网络的操作过程那时,卷积的思想被称作权值共享,也在年和关于反向传播的延伸分析中得到了切实讨论。 导读:这是《神经网络和深度学习简史》第二部分,这一部分我们会了解BP算法发展之后一些取得迅猛发展的研究,稍后我们会看到深度学习的关键性基础。神经网络获得视觉随着训练多层神经网络的谜题被揭开,这个话题再一次变得空前热门,罗森...

摘要:人工智能的主流算法深度学习的历史,堪称也是深度学习三剑客和共同走过的年艰难而辉煌的不悔人生。之后使用一种称为监督学习的方法来训练感知器,以正确区分不同形状。表示,多层次神经网络的结构并不会使感知器强大到有实用价值。 人工智能的主流算法Deep Learning深度学习的历史,堪称Deep History, 也是深度学习三剑客Geoff Hinton, Yann LeCun 和Yoshua B...

阅读 2713·2021-11-17 17:00

阅读 1995·2021-10-11 10:57

阅读 3821·2021-09-09 11:33

阅读 1004·2021-09-09 09:33

阅读 3603·2019-08-30 14:20

阅读 3408·2019-08-29 11:25

阅读 2863·2019-08-26 13:48

阅读 805·2019-08-26 11:52