资讯专栏INFORMATION COLUMN

摘要:现在,人脸识别的克星反人脸识别问世了。多伦多大学教授和研究生的团队开发了一种算法,可以动态地破坏人脸识别系统。因此,成功的攻击需要同时欺骗所有对象方案。算法对抗生成器训练给定人脸检测置信度的对抗成功率。

论文地址:

https://joeybose.github.io/assets/adversarial-attacks-face.pdf

在一些社交媒体平台,每次你上传照片或视频时,它的人脸识别系统会试图从这些照片和视频中得到更多信息。比如,这些算法会提取关于你是谁、你的位置以及你认识的其他人的数据,并且,这些算法在不断改进。

现在,人脸识别的克星——“反人脸识别”问世了。

多伦多大学Parham Aarabi教授和研究生Avishek Bose的团队开发了一种算法,可以动态地破坏人脸识别系统。

他们的解决方案利用了一种叫做对抗训练(adversarial training)的深度学习技术,这种技术让两种人工智能算法相互对抗。

现在,深度神经网络已经被应用于各种各样问题,如自动驾驶车辆、癌症检测等,但是我们迫切需要更好地理解这些模型容易受到攻击的方式。在图像识别领域,在图像中添加小的、往往不可察觉的干扰就可以欺骗一个典型的分类网络,使其将图像错误地分类。

这种被干扰的图像被称为对抗样本( adversarial examples),它们可以被用来对网络进行对抗攻击(adversarial attacks)。在制造对抗样本方面已经有几种方法,它们在复杂性、计算成本和被攻击模型所需的访问级别等方面差异很大。

一般来说,对抗攻击可以根据攻击模型的访问级别和对抗目标进行分类。白盒攻击(white-box attacks)可以完全访问它们正在攻击的模型的结构和参数;黑盒攻击(black-box attacks)只能访问被攻击模型的输出。

一种基线方法是快速梯度符号法(FGSM),它基于输入图像的梯度对分类器的损失进行攻击。FGSM是一种白盒方法,因为它需要访问被攻击分类器的内部。攻击图像分类的深度神经网络有几种强烈的对抗攻击方法,如L-BFGS、acobian-based Saliency Map Attack(JSMA)、DeepFool和carlin - wagner等。然而,这些方法都涉及到对可能的干扰空间进行复杂的优化,这使得它们速度慢,计算成本高。

与攻击分类模型相比,攻击目标检测的pipeline要困难得多。较先进的检测器,例如Faster R-CNN,使用不同尺度和位置的对象方案,然后对它们进行分类;其目标的数量比分类模型大几个数量级。

此外,如果受到攻击的方案只是总数的一小部分,那么仍然可以通过不同的方案子集正确地检测出受干扰的图像。因此,成功的攻击需要同时欺骗所有对象方案。

在这个案例中,研究人员证明了对较先进的人脸检测器进行快速对抗攻击是可能的。

研究人员开发了一种“隐私滤镜”,可以干扰人脸识别算法。该系统依赖于2种AI算法:一种执行连续的人脸检测,另一种设计来破坏前者。

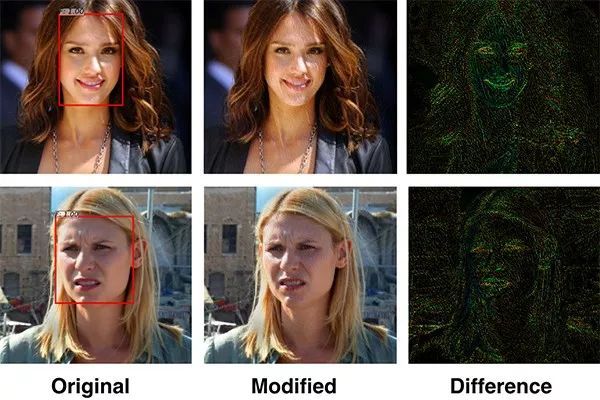

研究人员提出一种针对基于Faster R-CNN的人脸探测器的新攻击方法。该方法通过产生微小的干扰(perturbation),当将这些干扰添加到输入的人脸图像中时,会导致预训练过的人脸探测器失效。

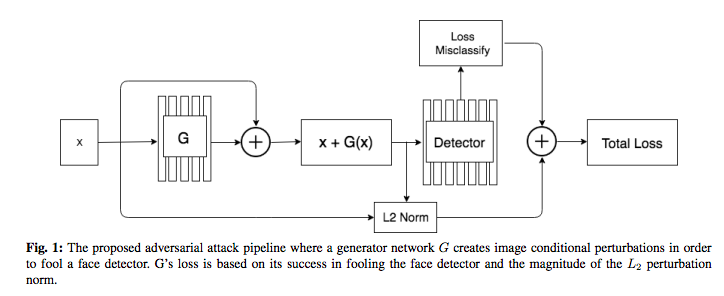

为了产生对抗干扰,研究人员提出针对基于预训练Faster R-CNN人脸检测器训练一个生成器。给定一个图像,生成器将产生一个小的干扰,可以添加到图像中以欺骗人脸检测器。人脸检测器只在未受干扰的图像上进行脱机训练,因此对生成器的存在浑然不觉。

随着时间的推移,生成器学会了产生干扰,这种干扰可以有效地欺骗它所训练的人脸探测器。生成一个对抗样本相当快速而且成本低,甚至比FGSM的成本更低,因为为输入创建一个干扰只需要在生成器经过充分的训练后进行前向传递( forward pass)。

两个神经网络相互对抗,形成“隐私”滤镜

研究人员设计了两个神经网络:第一个用于识别人脸,第二个用于干扰第一个神经网络的识别人脸任务。这两个神经网络不断地相互对抗,并相互学习。

其结果是一个类似instagram的“隐私”滤镜,可以应用于照片,以保护隐私。其中的秘诀是他们的算法改变了照片中的一些特定像素,但人眼几乎察觉不到这些变化。

“干扰性的AI算法不能‘攻击’用于检测人脸的神经网络正在寻找的东西。” 该项目的主要作者Bose说:“例如,如果检测网络正在寻找眼角,干扰算法就会调整眼角,使得眼角的像素不那么显眼。算法在照片中造成了非常微小的干扰,但对于检测器来说,这些干扰足以欺骗系统。”

算法1:对抗生成器训练

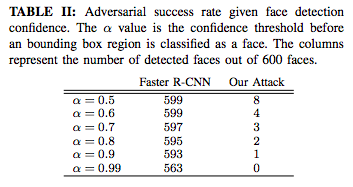

给定人脸检测置信度的对抗成功率。α值是边界框区域被分类为人脸之前的confidence threshold,右边两列表示600张照片中检测到脸部的数量。

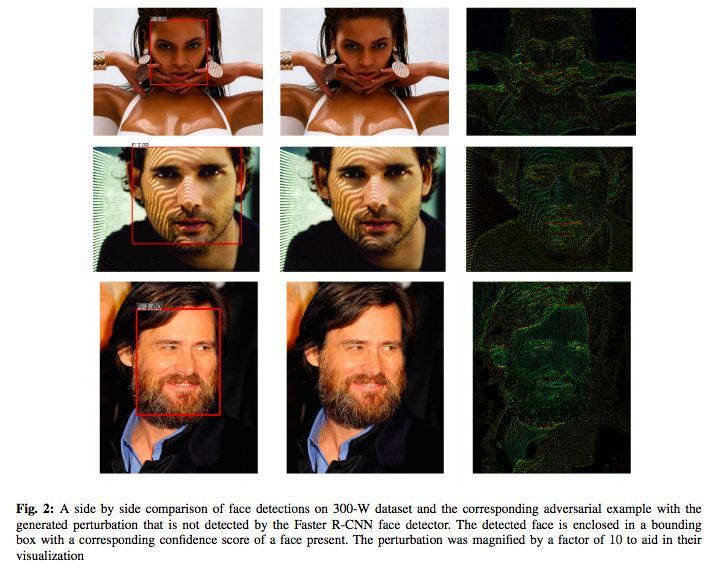

研究人员在300-W人脸数据集上测试了他们的系统,该数据集包含多种族,不同照明条件和背景环境的超过600张人脸照片,是一个业界的标准库。结果表明,他们的系统可以将原本可检测到的人脸比例从接近100%降低到0.5%。

所提出的对抗攻击的pineline,其中生成器网络G创建图像条件干扰,以欺骗人脸检测器。

Bose说:“这里的关键是训练两个神经网络相互对抗——一个创建越来越强大的面部检测系统,另一个创建更强大的工具来禁用面部检测。”该团队的研究将于即将举行的2018年IEEE国际多媒体信号处理研讨会上发表和展示。

将300-W数据集的人脸检测和相应的对抗样本进行对比,这些样本具有生成的干扰,没有被Faster R-CNN人脸检测器检测到。被检测到的人脸被包围在具有相应置信度值的边界框中。 为了可视化,干扰被放大了10倍。

除了禁用面部识别之外,这项新技术还会干扰基于图像的搜索、特征识别、情感和种族判断以及其他可以自动提取面部属性。

接下来,该团队希望通过app或网站公开这个隐私滤镜。

“十年前,这些算法必须要由人类定义,但现在是神经网络自己学习——你不需要向它们提供任何东西,除了训练数据,”Aarabi说。“最终,它们可以做出一些非常了不起的事情,有巨大的潜力。”

原文:

https://www.eurekalert.org/multimedia/pub/171921.php

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4776.html

摘要:中科院自动化所,中科院大学和南昌大学的一项合作研究,提出了双路径,通过单一侧面照片合成正面人脸图像,取得了当前较好的结果。研究人员指出,这些合成的图像有可能用于人脸分析的任务。恢复的图像的质量严重依赖于训练过程中的先验或约束条件。 中科院自动化所(CASIA),中科院大学和南昌大学的一项合作研究,提出了双路径 GAN(TP-GAN),通过单一侧面照片合成正面人脸图像,取得了当前较好的结果。研...

摘要:人脸识别技术所独具的活性判别能力保证了他人无法以非活性的照片木偶蜡像来欺骗识别系统。人脸识别技术所采用的依据是人脸照片或实时摄取的人脸图像,因而无疑是最容易获得的。 人脸识别是近年来模式识别、图像处理、机器视觉、神经网络以及认知科学等领域研究的热点课题之一,被广泛应用于公共安全(罪犯识别等)...

摘要:本文着重以人脸识别为例介绍深度学习技术在其中的应用,以及优图团队经过近五年的积累对人脸识别技术乃至整个人工智能领域的一些认识和分享。从年左右,受深度学习在整个机器视觉领域迅猛发展的影响,人脸识别的深时代正式拉开序幕。 腾讯优图隶属于腾讯社交网络事业群(SNG),团队整体立足于腾讯社交网络大平台,专注于图像处理、模式识别、机器学习、数据挖掘、深度学习、音频语音分析等领域开展技术研发和业务落地。...

阅读 3370·2021-11-10 11:36

阅读 3264·2021-10-08 10:21

阅读 2895·2021-09-29 09:35

阅读 2443·2021-09-22 16:06

阅读 4012·2021-09-09 09:33

阅读 1349·2019-08-30 15:44

阅读 3191·2019-08-30 10:59

阅读 3004·2019-08-29 15:32