资讯专栏INFORMATION COLUMN

摘要:近日,发布了其关于神经网络可解释性的研究成果,他们通过删除网络中的某些神经元组,从而判定其对于整个网络是否重要。泛化性良好的网络对于删除神经元的操作更具适应性。通过删除单个神经元和神经元组,我们测量了破坏网络对性能的影响。

深度学习算法近年来取得了长足的进展,也给整个人工智能领域送上了风口。但深度学习系统中分类器和特征模块都是自学习的,神经网络的可解释性成为困扰研究者的一个问题,人们常常将其称为黑箱。但理解深度神经网络的工作原理,对于解释其决策方式,并建立更强大的系统至关重要。

近日,DeepMind 发布了其关于神经网络可解释性的研究成果,他们通过删除网络中的某些神经元组,从而判定其对于整个网络是否重要。核心发现有如下两点:

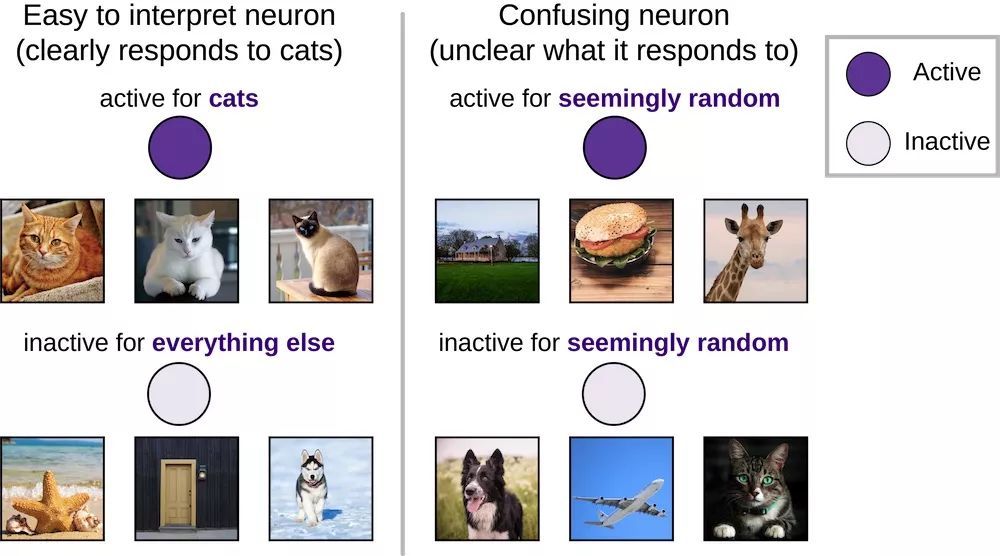

可解释的神经元(例如“猫神经元”)并不比难以解释的神经元更重要。

泛化性良好的网络对于删除神经元的操作更具适应性。

以下内容来自 DeepMind,人工智能头条翻译。

深度神经网络由许多独立的神经元组成,这些神经元以复杂且反直觉的方式结合起来,进而解决各种具有挑战性的任务。这种复杂性赋予了神经网络强大的功能,但也使其成为一个令人困惑且不透明的黑箱。

理解深度神经网络的工作原理,对于解释其决策、建立更强大的系统至关重要。想象一下,在不了解各个齿轮如何装配的情况下,制造一块钟表的难度会有多大。在神经科学和深度学习领域中,理解神经网络的一种方法是研究单个神经元的作用,特别是那些容易解释的神经元。

我们即将在第六届国际学习表征会议(ICLR)上发表关于单一方向泛化重要性的研究,它采用了一种受实验神经科学启发的方法——探索损伤的影响——来确定深层神经网络中的小组神经元的重要性,以及更容易解释的神经元的重要性是否更高。

通过删除单个神经元和神经元组,我们测量了破坏网络对性能的影响。在实验中,我们有两个惊人的发现:

之前的许多研究都试图去理解容易解释的个体神经元(例如“猫神经元”,或者说深层网络中只有对猫的图像有反应的神经元),但是我们发现这些可解释的神经元并不比难以解释的神经元更重要。

与只能对已经见过的图像进行分类的网络相比,对未见过的图像也能正确分类的网络对神经元缺失有着更好的弹性。换句话说,泛化性良好的网络比泛化性差的网络对单方向的依赖性要小很多。

“猫神经元”或许更容易解释,但是它们的重要性并不会更高

在神经科学和深度学习中,容易解释的神经元(“选择性”神经元)已经被广泛分析,它们只对单一输入类别的图像(例如狗)有积极回应。在深度学习中,这导致了研究者对猫神经元(cat neurons)、情感神经元(sentiment neurons)和括号神经元(parentheses neurons)的重视。然而,与大多数具有低选择性、更令人费解、难以解释的活性的神经元相比,这些为数不多的具有高选择性神经元的相对重要性仍然未知。

与那些对看似随机的图像集作出积极或消极回应的令人困惑的神经元相比,具有清晰回应模式(比如只对“狗”积极回应,对其他一切类别消极回应)的神经元更容易解释。

为了评估神经元的重要性,我们测量了删除神经元后,神经网络在图像分类任务中的性能变化。如果一个神经元是非常重要的,删除它应该会产生严重的后果,而且网络性能会大大降低,而删除一个不重要的神经元应该没有什么影响。神经科学家通常进行类似的实验,尽管他们不能达到这些实验所必需的细粒度精度,但是在人工神经网络中则很容易实现。

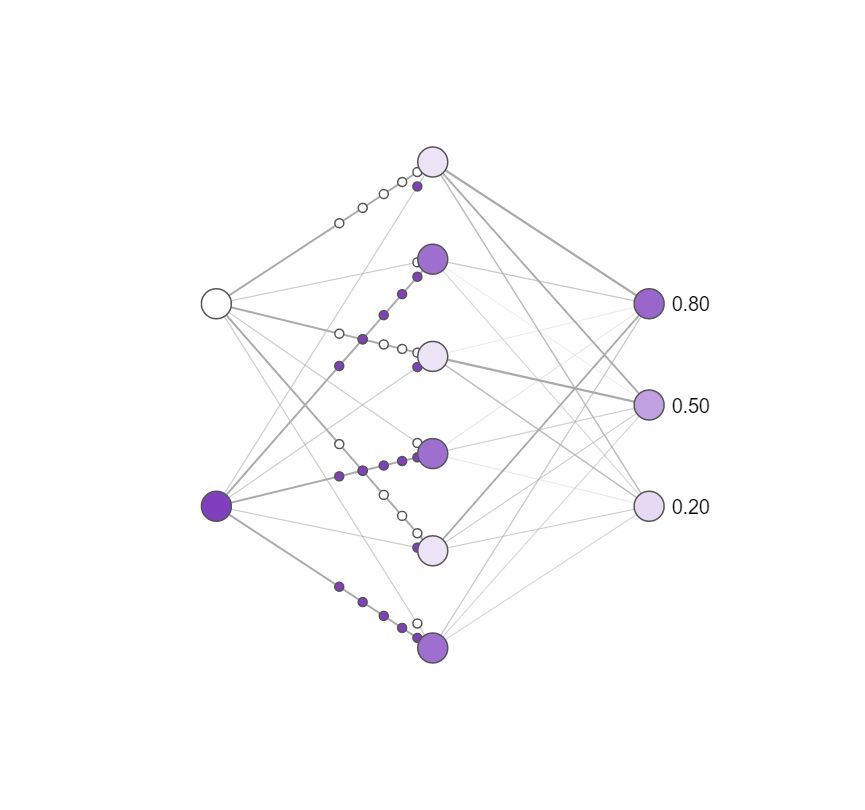

删除神经元对简单神经网络影响的概念图。颜色越深,代表神经元越活跃。你可以在原网页上尝试单击隐藏层神经元删除它们,并查看输出神经元的活动变化。请注意,仅删除一个或两个神经元对输出的影响很小,而删除大多数神经元的影响很大,并且某些神经元比其他神经元更重要!

令人惊讶的是,我们发现选择性和重要性之间没有什么关系。换句话说,“猫神经元”并不比令人困惑的神经元更重要。这一发现与神经科学最近的研究成果相呼应,后者已经证明,令人困惑的的神经元实际上可以提供相当多的信息。为了理解深度神经网络,我们的研究不能只局限于最容易解释的神经元。

虽然“猫神经元”可能更容易记解释,但它们并不比令人困惑且没有明显偏好的神经元更加重要。

泛化能力更强的网络更不容易崩溃

虽然我们希望创建智能系统,但是只有当这个系统能够泛化到新的场景时,我们才能称之为智能系统。例如,如果一个图像分类网络只能对它见过的特定的狗的图像进行分类,却认不出同一只狗的图像时,这个网络就是无用的。这些系统只有在对新的实例进行智能分类时,才算是有作用的。

伯克利、Google Brain、DeepMind 最近合作发表的一篇论文在 ICLR 2017 上获得了较佳论文。该论文表明,深度网络可以简单地记住每一幅图像,而不是以更人性化的方式学习(例如,理解“狗”的抽象概念)。

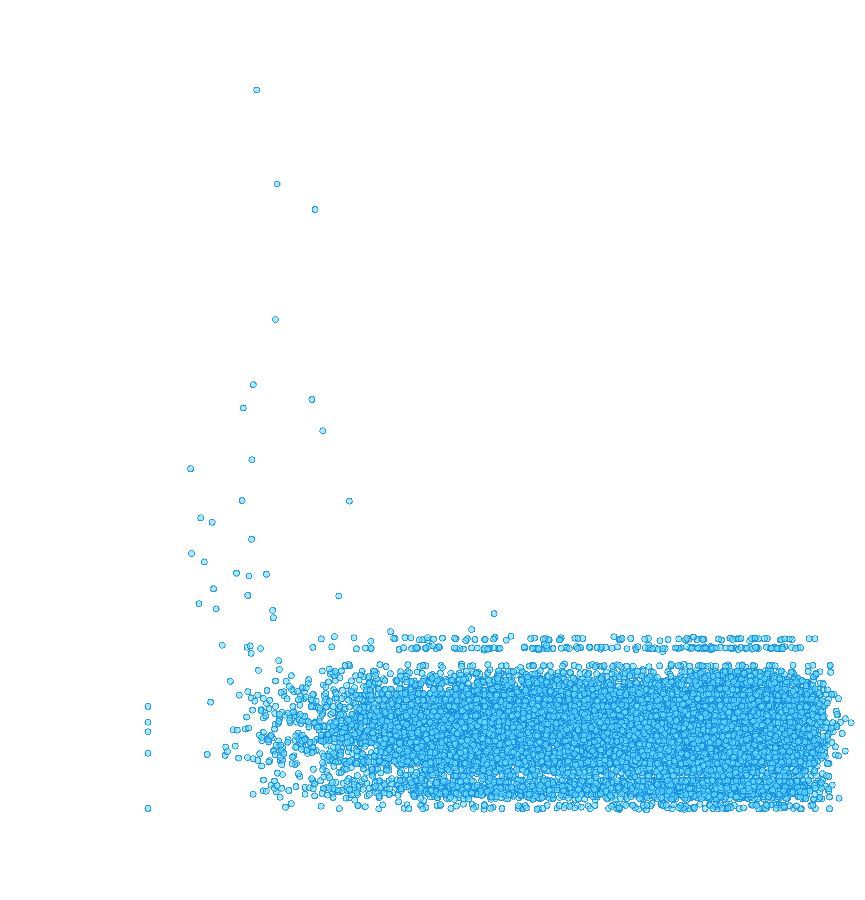

然而,关于神经网络是否学习到了决定泛化能力的解,我们一直没有明确的答案。通过逐步删除越来越大的神经元群,我们发现,相比简单地记忆先前在训练中看到的图像的网络,泛化良好的网络对删除神经元的鲁棒性强得多。换句话说,泛化能力更强的网络更不容易崩溃(尽管这种情况可能发生)。

随着越来越多的神经元群被删除,泛化良好的网络的性能下降速度明显更慢。

通过这种方式测量神经网络的鲁棒性,我们可以评估这个网络是否在利用我们不希望的记忆能力在“作弊”。理解网络在记忆时如何是变化的,将有助于我们建立泛化能力更好的新网络。

受神经科学启发的分析方法

这些发现证明了,使用实验神经科学启发的技术可以帮助我们理解神经网络的能力。使用这些方法,我们发现高选择性的独立神经元并不比非选择性神经元更重要,并且泛化良好的网络比简单地记忆训练数据的网络对独立神经元的依赖性更小。这些结果暗示,独立神经元的重要性可能远不如我们认为的那么重要。

通过解释所有神经元的作用,而不仅仅是那些容易理解的神经元,我们希望更好地理解神经网络的内部工作原理,并且利用这种理解来构建更智能和更通用的系统。

阅读完整论文:https://arxiv.org/abs/1803.06959

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4753.html

摘要:深度学习现在被视为能够超越那些更加直接的机器学习的关键一步。的加入只是谷歌那一季一系列重大聘任之一。当下谷歌醉心于深度学习,显然是认为这将引发下一代搜索的重大突破。移动计算的出现已经迫使谷歌改变搜索引擎的本质特征。 Geoffrey Hiton说:我需要了解一下你的背景,你有理科学位吗?Hiton站在位于加利福尼亚山景城谷歌园区办公室的一块白板前,2013年他以杰出研究者身份加入这家公司。H...

摘要:康纳尔大学数学博士博士后则认为,图神经网络可能解决图灵奖得主指出的深度学习无法做因果推理的核心问题。图灵奖得主深度学习的因果推理之殇年初,承接有关深度学习炼金术的辩论,深度学习又迎来了一位重要的批评者。 作为行业的标杆,DeepMind的动向一直是AI业界关注的热点。最近,这家世界最较高级的AI实验室似乎是把他们的重点放在了探索关系上面,6月份以来,接连发布了好几篇带关系的论文,比如:关系归...

摘要:第二次则是今年初,论文被深度学习盛会拒绝。表示遗憾乃至愤怒的人不在少数。他认为,使从其他学术实验室中脱颖而出的,是它的跨领域文化。腾讯也在筹建人工智能实验室,近期消息就会正式公布。 牛津大学和 DeepMind 的研究人员合作,开发出一款能够阅读唇语的系统,这个名叫 Watch, Attend and Spell(WAS)的软件在实际表现中远远超越了人类专家的水平。研究人员使用计算机视觉和机...

摘要:年的深度学习研讨会,压轴大戏是关于深度学习未来的讨论。他认为,有潜力成为深度学习的下一个重点。认为这样的人工智能恐惧和奇点的讨论是一个巨大的牵引。 2015年ICML的深度学习研讨会,压轴大戏是关于深度学习未来的讨论。基于平衡考虑,组织方分别邀请了来自工业界和学术界的六位专家开展这次圆桌讨论。组织者之一Kyunghyun Cho(Bengio的博士后)在飞机上凭记忆写下本文总结了讨论的内容,...

摘要:有一些缺陷并不完善,但是这个学生所提交的用深度学习所预测的转向角还是不错的。 本文作者:奥利弗 · 卡梅隆(Oliver Cameron),现Udacity无人驾驶领导人,前YCombinator孵化创业公司创始人。有许多人分析过深度学习重要性以及它是怎样风靡世界的,我十分赞同他们的说法。研究/应用深度学习时使我感觉自己最像个魔术师,我清楚地知道在未来的三年里,任何一个伟大的软件都将被深度学...

阅读 3263·2021-11-08 13:18

阅读 1408·2021-10-09 09:57

阅读 1254·2021-09-22 15:33

阅读 4122·2021-08-17 10:12

阅读 5154·2021-08-16 11:02

阅读 2743·2019-08-30 10:56

阅读 1029·2019-08-29 18:31

阅读 3306·2019-08-29 16:30