资讯专栏INFORMATION COLUMN

摘要:在最近的一次大会上,表示,他对反向传播深表怀疑,并认为我的观点是将它完全摒弃,然后重新开始。相对于对象函数计算反向传播。通常,目标函数是预测分布与实际分布之间差异的量度。所以也许无监督的学习不需要目标函数,但是它仍然可能需要反向传播。

Geoffrey Hinton终于公开阐述了他对那些早已令许多人惶恐不安的事物的看法。在最近的一次AI大会上,Hinton表示,他对反向传播“深表怀疑”,并认为:“我的观点是将它完全摒弃,然后重新开始”。

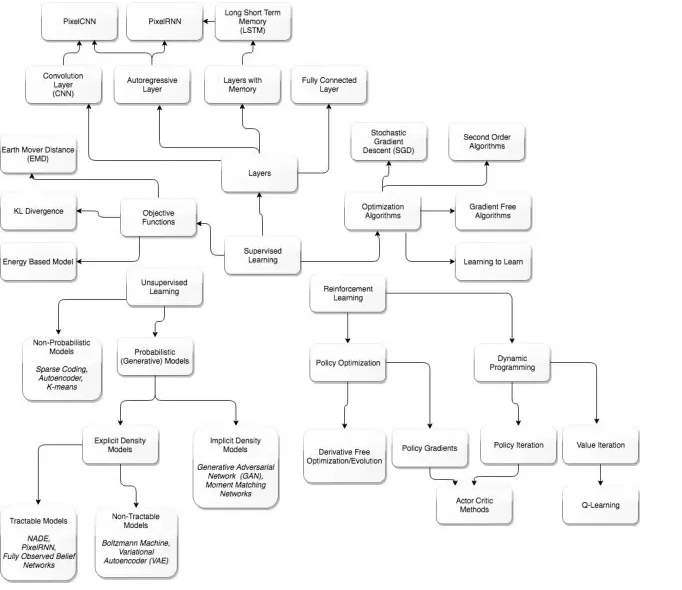

现如今,反向传播已成为深度学习的“面包和黄油”机制。研究人员发现,可以在解决方案中使用任何计算层,的要求就是层必须是可微的。换句话说,我们要能够计算出层的梯度。

关于反向传播有这么几个问题值得思考。第一个是经过计算的梯度是否始终是学习的正确方向?直观感觉这个是有问题的。人们总能发现问题,其中向着最明显的方向移动并不总是能够找到解决方案。因此忽略梯度也可能产生一个解决方案,这也没什么可意外的。关于适应性观点与优化性观点之间的区别,我在之前的文章里阐述过,有兴趣的可以查阅。

我们来回顾一下,并试图以历史的视角来了解这种反向传播思想的来源。从历史上看,机器学习源于曲线拟合的一般理解。在线性回归的具体示例下(即用直线进行预测),计算梯度是求解最小二乘问题的方法。在优化问题中,除了使用梯度求解较佳解决方案之外,还有许多其他可供选择的方法。事实上,随机梯度下降可能是最基本的优化方法之一,所以人们可能认为它是一个非常出色的,最简单的算法之一,而实际上它的性能确实是非常棒的。

大多数优化专家一直认为,深度学习的高维空间将需要一个非凸(non-convex)的解决方案,因此难以优化。然而,由于一些无法解释的原因,深度学习使用随机梯度下降(SGD)的运行效果非常好。许多研究人员后来提出了许多不同的观点,以解释为什么使用SGD时深度学习的优化效果如此好。一个更具说服力的观点是,在高维空间中,人们更有可能找到一个鞍点(saddle point)而不是local valley。总会有足够的维度和梯度,指向一条逃逸路线。

指南

合成梯度(Synthetic Gradients),一种使层分离的方法,从而使得反向传播并不总是必不可少,或者使得梯度计算可以被延迟,而这样方法也同样被证明是有效的。这个发现可能是一个暗示,即其他更为通用的事情正在发生。这就好像任何一种趋向于增量的更新,无论方向如何(在合成梯度的情况下都是随机的)同样有效。

还有一个关于所使用的典型目标函数的问题。相对于对象函数计算反向传播。通常,目标函数是预测分布与实际分布之间差异的量度。通常,有些东西导出Kullback-Liebler散度或者像Wassertsein这样的其他相似性分布测量。然而,在这些相似性计算中,在监督训练中存在“标签”。在同一次采访中,Hinton对无监督的学习表示:“我怀疑这意味着摆脱反向传播。”他进一步说,“我们显然不需要所有的标签数据。”

简而言之,如果你没有目标函数,则不能进行反向传播。如果你没有预测值和标记(实际或训练数据)值之间的度量,则无法得到目标函数。所以要实现“无监督学习”,你可能会抛弃计算梯度的能力。

让我们从更广泛的视角来检验目标函数的目的。目标函数是衡量内部模型在预测其环境方面的准确程度。任何智能自动化过程的目的是制定较精确的内部模型。然而,没有任何东西需要在任何时候或不断地进行模型与环境之间的测量。也就是说,自动化过程不需要执行反向传播来学习。自动化过程可能是做一些其他事情以改进其内部模型。

其他一些东西,我们称之为“想象或梦想”,不需要直接的现实验证。我们目前最典型的就是生成对抗网络(GAN)。GAN由两个网络组成,一个生成器和一个鉴别器。可以将鉴别器视为与目标函数一致的神经网络。也就是说,它使内部生成器网络得到现实验证。生成器是一种重现不断趋近现实的自动化过程。GAN使用反向传播工作,它执行无监督学习。所以也许无监督的学习不需要目标函数,但是它仍然可能需要反向传播。

另一种观察无监督学习的方法是一种元学习(meta-learning)。系统不需要监督训练数据的一种可能性是,学习算法已经开发了自己的内部模型,以便较好地进行。换句话说,仍然有一些监督,它恰好隐含在学习算法中。学习算法如何赋予这种能力是一个很大的未知数。

总而言之,现在说我们是否可以摆脱反向传播还为时尚早。我们当然可以使用一个不太严格的版本(即合成梯度或其他启发式算法)。然而,渐近学习(gradual learning)或者说爬山算法(hill climbing)似乎仍然是一个必要条件。我当然会很有兴趣找到任何使渐近学习或爬山算法无效的研究。事实上,这类似于宇宙的行为,更具体地说就是热力学第二定律。更具体地说,该熵始终增加。信息引擎将降低自己的熵,以换取环境中的熵增加。因此,没有办法完全避免梯度。这样做将需要一些“信息永动机”(perpetual motion information machine)。

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4606.html

摘要:然而反向传播自诞生起,也受到了无数质疑。主要是因为,反向传播机制实在是不像大脑。他集结了来自和多伦多大学的强大力量,对这些替代品进行了一次评估。号选手,目标差传播,。其中来自多伦多大学和,一作和来自,来自多伦多大学。 32年前,人工智能、机器学习界的泰斗Hinton提出反向传播理念,如今反向传播已经成为推动深度学习爆发的核心技术。然而反向传播自诞生起,也受到了无数质疑。这些质疑来自各路科学家...

摘要:近几年以卷积神经网络有什么问题为主题做了多场报道,提出了他的计划。最初提出就成为了人工智能火热的研究方向。展现了和玻尔兹曼分布间惊人的联系其在论文中多次称,其背后的内涵引人遐想。 Hinton 以深度学习之父 和 神经网络先驱 闻名于世,其对深度学习及神经网络的诸多核心算法和结构(包括深度学习这个名称本身,反向传播算法,受限玻尔兹曼机,深度置信网络,对比散度算法,ReLU激活单元,Dropo...

摘要:有几次,人工智能死在人工神经网络上。在过去十年中,他一直在举办为期一周的有关神经网络的暑期学校,我曾经拜访过。神经网络压缩信息之后,这些信息无法复原。 魔法已经进入这个世界。如今,许多美国人口袋里装着薄薄的黑色平板,这些机器接入遥远的数字云和卫星,它们解码语言、通过摄像头观察并标记现实,挖掘个人数据,它们以某种方式理解、预测着我们的心愿。倾听、帮助着人类。因为与多伦多大学有个约会,这个夏天,...

摘要:多加了这两层卷积层和汇集层是卷积神经网络和普通旧神经网络的主要区别。卷积神经网络的操作过程那时,卷积的思想被称作权值共享,也在年和关于反向传播的延伸分析中得到了切实讨论。 导读:这是《神经网络和深度学习简史》第二部分,这一部分我们会了解BP算法发展之后一些取得迅猛发展的研究,稍后我们会看到深度学习的关键性基础。神经网络获得视觉随着训练多层神经网络的谜题被揭开,这个话题再一次变得空前热门,罗森...

摘要:本文试图揭开让人迷惘的云雾,领悟背后的原理和魅力,品尝这一顿盛宴。当然,激活函数本身很简单,比如一个激活的全连接层,用写起来就是可是,如果我想用的反函数来激活呢也就是说,你得给我解出,然后再用它来做激活函数。 由深度学习先驱 Hinton 开源的 Capsule 论文 Dynamic Routing Between Capsules,无疑是去年深度学习界最热点的消息之一。得益于各种媒体的各种...

阅读 2490·2021-09-22 15:27

阅读 3260·2021-09-03 10:32

阅读 3563·2021-09-01 11:38

阅读 2544·2019-08-30 15:56

阅读 2260·2019-08-30 13:01

阅读 1580·2019-08-29 12:13

阅读 1466·2019-08-26 13:33

阅读 933·2019-08-26 13:30