资讯专栏INFORMATION COLUMN

摘要:例如,即插即用生成网络通过优化结合了自动编码器损失,损失,和通过与训练的分类器定于的分类损失的目标函数,得到了较高水平的样本。该论文中,作者提出了结合的原则性方法。

在机器学习研究领域,生成式对抗网络(GAN)在学习生成模型方面占据着统治性的地位,在使用图像数据进行训练的时候,GAN能够生成视觉上以假乱真的图像样本。但是这种灵活的算法也伴随着优化的不稳定性,导致模式崩溃(mode collapse)。将自动编码器(auto-encoder)与GAN相结合,能够使模型更好的表示所有被训练的数据,以阻止模式崩溃。来自Google DeepMind的研究者Mihaela Rosca等人利用生成模型的层级结构,提出了将自动编码器与生成对抗网络相结合的原则,结合了两种方法的优点,得到了顶尖结果。

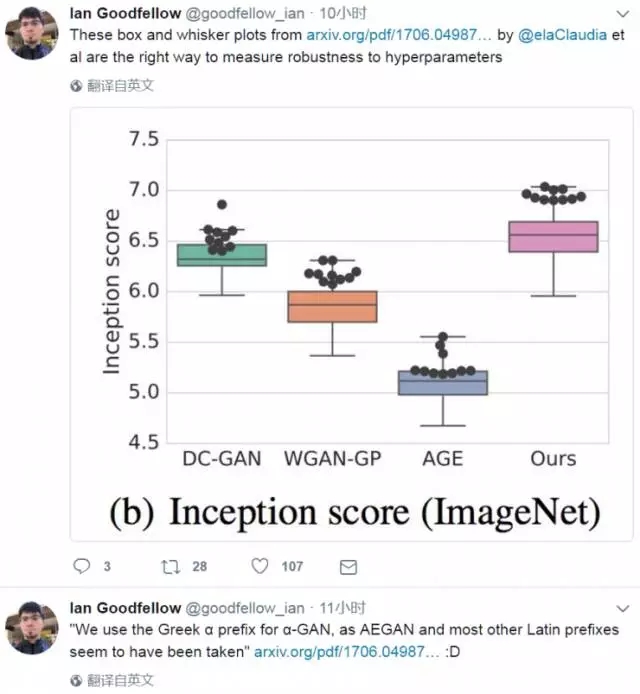

而Ian Goodfellow也鼎力推荐了论文内容。

以下为 AI科技评论据论文内容进行的部分编译:

论文摘要

生成对抗网络是目前机器学习研究领域学习生成模型的最主要的方法之一,它提供了一种学习隐变量模型的更灵活的算法。定向隐变量模型描述了源噪声数据是如何通过非线性函数变换为貌似真实的数据样本的,而GAN则通过辨别真实数据和模型生成数据来驱动学习过程。GAN可以在大型数据集上进行训练,当使用图像数据进行训练的时候,GAN能够生成视觉上相当真实的图像样本。但这种灵活性也带来了优化过程中的不稳定性,会导致模式崩溃的问题,即生成的数据不能反应潜在的数据分布的差异。基于自编码器的GAN(auto-encoder-based GAN, AE-GAN)正是为了解决这个问题的GAN变种,它使用了自动编码器来鼓励模型更好的表示所有被训练的数据,从而阻止模式崩溃。

自动编码器的应用成功的改善了GAN训练。例如,即插即用生成网络(plug and play generative network, PPGN)通过优化结合了自动编码器损失,GAN损失,和通过与训练的分类器定于的分类损失的目标函数,得到了较高水平的样本。AE-GAN可以大致分为三种:(1)使用自动编码器作为判别器,例如energy-based GAN和boundary-equilibrium GAN。(2)使用去噪自动编码器以得到更称其的辅助损失函数,例如denoising feature matching GAN。(3)结合了VAE和GAN的方法,例如变分自动编码器GAN(variational auto-encoder GAN, VAE-GAN)。

该论文中,作者提出了结合AE-GAN的原则性方法。通过探索由GAN学习到的隐变量模型的层次结构,作者展示了如何将变分自动编码器与GAN结合到一起。该方法能够克服各自方法的限制,因此具有极大的优势。当基于图像进行训练时,VAE方法经常会生成模糊的图像,但VAE不会像GAN一样受到模式崩溃问题的困扰。GAN几乎不允许对模型进行分布假设,而VAE允许对隐变量进行推断,这对于表征学习,可视化和解释是很有用的。该论文开发的方法结合了这两个方法中的优点,提供统一的学习目标函数,无监督,不需要预训练或外部分类器,并且可以轻松的扩展到其他生成模型任务。

该论文主要进行了一下工作:

表明变分推理(variational inference)同样使用与GAN,以及如何可以将判别器用于具有隐式后验近似的变分推理。

在学习生成模型时,可以组合likelihood-based和likelihood-free模型。在likelihood-free设定中,开发了具有合成似然性的变分推理,使得可以学习这种模型。

制定了自动编码GAN(auto-encoding GAN,α-GAN)的原则目标函数,并描述了使它进行实际工作所需的思考。

评估是GAN研究中的主要挑战之一,作者使用了一系列评估措施仔细评估了该方法的性能,与DC-GAN, WGAN和对抗-生成-编码器(adversarial-generator-encoder,AGE)进行比较,展示了论文中的方法与这些方法有相媲美的性能,并强调隐生成模型中持续评估的挑战。

实验结果

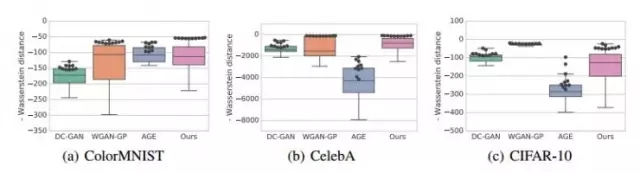

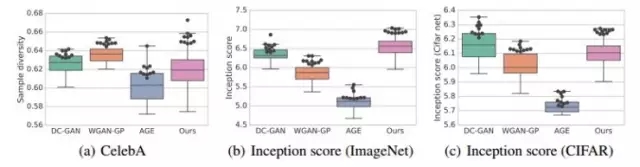

为了更好地理解基于自动编码器的方法在GAN领域中的重要性,作者将该方法与其他GAN方法在三个数据集上进行了对比,包括混合模型AGE,和其他纯GAN方法的变种,例如DCGAN和WGAN-GP。数据集为ColorMNIST,CelebA和CIFAR-10。在实验中,使用了Inception score,MS-SSIM和Independent Wasserstein critic作为评估指标。为了综合分析实验结果,结果采用了每个算法获得的较佳值。为了评估模型对超参数的敏感性,采用了每个模型各个超参数中较好的十个,在图中由黑色圆圈表示。

图一:Wasserstein critic指标下各方法的实验结果

图二:Sample diversity和Inception score指标下各方法实验结果

ColorMNIST数据集结果:

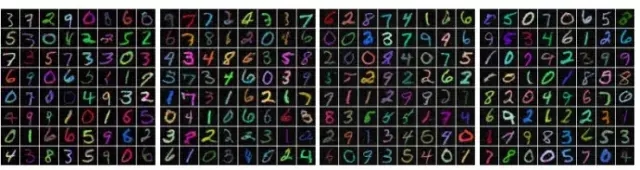

在上图(a)中比较了Wasserstein critic指标的值,其中值越高越好。该方法对超参数的敏感度较低,在这个指标下,该方法在各种设置下都取得了较佳的性能。这也在下图生成的样本中得到了证明:

从左到右分别为:DCGAN,WGAN-GP,AGE,论文中方法

CelebA数据集结果:

CelebA数据集有64*64像素的名人脸图片组成。下图展示了四种模型生成的样本。作者也在Wasserstein critic指标下(见图一(b))和sample diversity score标准下(见图二(a))对各方法进行了比较,论文中方法与WGAN-GP和AGE方法有接近的表现。

从左到右分别为:DCGAN,WGAN-GP,AGE,论文中方法

CIFAR-10数据集结果:

下图中展示了CIFAR-10数据集上四种模型生成的样本。如图一(c)所示,在Wasserstein critc指标下,WGAN-GP是较佳模型。如图二(b)所示,基于ImageNet的Inception score中,论文种方法有较佳的性能,如图二(c)所示,基于CIFAR-10的Inception score中,论文中方法与DC-GAN有相近的性能。

从左到右分别为:DCGAN,WGAN-GP,AGE,论文采用的方法

想要深入了解该方法的请阅读原论文:https://arxiv.org/pdf/1706.04987.pdf

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4579.html

摘要:我们还经验性地演示了贝叶斯在语言建模基准和生成图说任务上优于传统,以及通过使用不同的训练方案,这些方法如何改进我们的模型。第节和第节分别回顾了通过反向传播做贝叶斯,和通过时间做反向传播。 摘要在这项工作里,我们探讨了一种用于 RNN 的简单变分贝叶斯方案(straightforward variational Bayes scheme)。首先,我们表明了一个通过时间截断反向传播的简单变化,能...

摘要:文本谷歌神经机器翻译去年,谷歌宣布上线的新模型,并详细介绍了所使用的网络架构循环神经网络。目前唇读的准确度已经超过了人类。在该技术的发展过程中,谷歌还给出了新的,它包含了大量的复杂案例。谷歌收集该数据集的目的是教神经网络画画。 1. 文本1.1 谷歌神经机器翻译去年,谷歌宣布上线 Google Translate 的新模型,并详细介绍了所使用的网络架构——循环神经网络(RNN)。关键结果:与...

摘要:老顾受邀在一些大学和科研机构做了题为深度学习的几何观点的报告,汇报了这方面的进展情况。昨天年月日,严东辉教授邀请老顾在泛华统计协会举办的应用统计会议上做了深度学习的几何观点的报告。小结最优传输理论可以用于解释深度学习中的概率分布变换。 (最近,哈佛大学丘成桐先生领导的团队,大连理工大学罗钟铉教授、雷娜教授领导的团队应用几何方法研究深度学习。老顾受邀在一些大学和科研机构做了题为深度学习的几何观...

摘要:二是精度查全率和得分,用来衡量判别式模型的质量。精度查全率和团队还用他们的三角形数据集,测试了样本量为时,大范围搜索超参数来进行计算的精度和查全率。 从2014年诞生至今,生成对抗网络(GAN)热度只增不减,各种各样的变体层出不穷。有位名叫Avinash Hindupur的国际友人建立了一个GAN Zoo,他的动物园里目前已经收集了多达214种有名有姓的GAN。DeepMind研究员们甚至将...

摘要:相比于,它将也作为隐变量纳入到变分推断中。结论综述本文的结果表明了变分推断确实是一个推导和解释生成模型的统一框架,包括和。 作者丨苏剑林单位丨广州火焰信息科技有限公司研究方向丨NLP,神经网络个人主页丨kexue.fm前言我小学开始就喜欢纯数学,后来也喜欢上物理,还学习过一段时间的理论物理,直到本科毕业时,我才慢慢进入机器学习领域。所以,哪怕在机器学习领域中,我的研究习惯还保留着数学和物理的...

阅读 925·2023-04-26 00:11

阅读 2718·2021-11-04 16:13

阅读 2178·2021-09-09 09:33

阅读 1529·2021-08-20 09:35

阅读 3915·2021-08-09 13:42

阅读 3664·2019-08-30 15:55

阅读 1181·2019-08-30 15:55

阅读 2275·2019-08-30 13:55