资讯专栏INFORMATION COLUMN

摘要:一段时间以来,我一直在尝试使用生成神经网络制作人物肖像。生成图像的质量与低分辨率输出实现密切相关。在第一阶段,根据给定描述生成相对原始的形状和基本的色彩,得出低分辨图像。使用生成的图像比现有方法更加合理逼真。

一段时间以来,我一直在尝试使用生成神经网络制作人物肖像。早期试验基于类似 Deep Dream 的方法,但最近我开始将精力集中在 GAN 上面。当然,无论在什么时候,高精度和较精确的细节都是很难实现的,使用 GAN 生成人脸也一样。首先,这些网络的感受野往往不到 256×256 像素的大小。

解决这个问题的一种办法是使用 stack GAN。我用基于 stack GAN 的方法,终于将像素提升到 768×768 的大小,最多使用 3 个阶段 stack 将像素提升到了 4k×4k。我不在意结果是否真实,但细节纹理逼真很重要。

为了减少 artifact(模糊不清的地方),我需要应对 mode collapse 等各种问题。具体说,光滑皮肤和多毛皮肤之间,第二阶段 GAN 是 meta stable,往往导致输出变成一块一块的。

现在我使用的最多是 vanilla GAN。当然,我觉得我也该试一下 WGAN、CramerGAN 或 BEGAN,因为大家都说后面几种收敛更好。

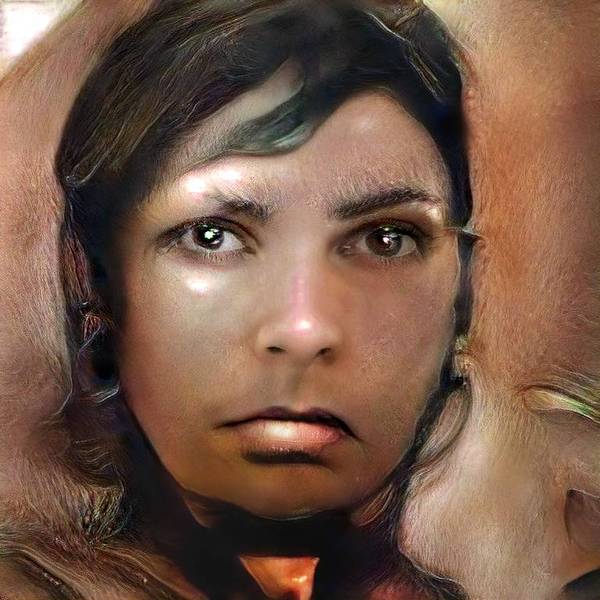

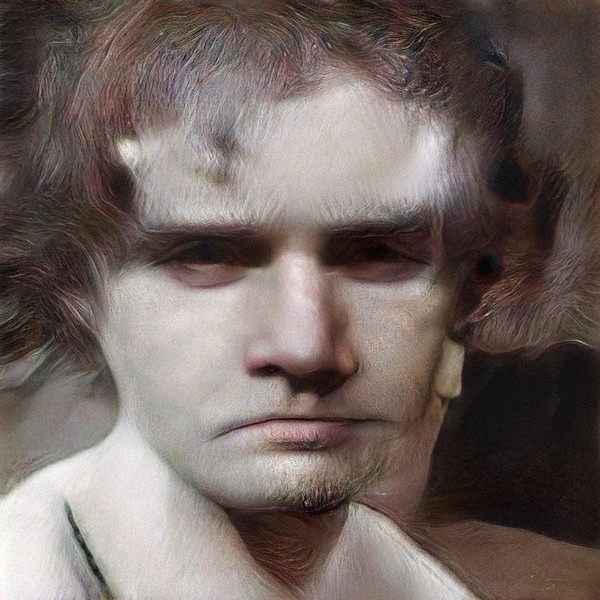

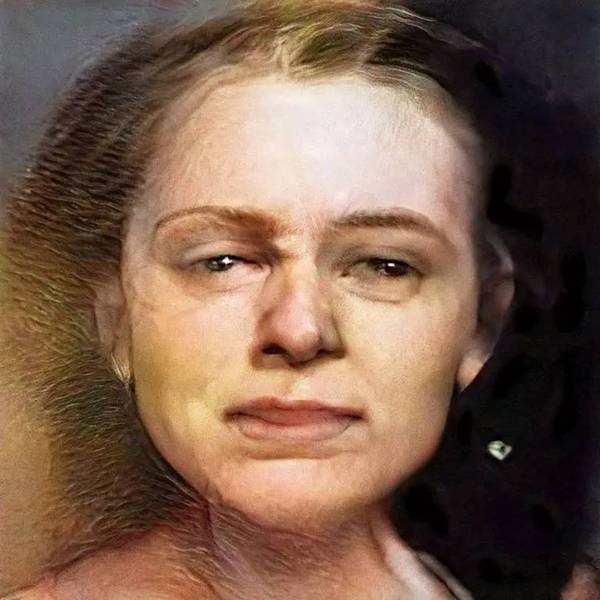

下面就是我使用 GAN 生成的空想人物肖像(我选了效果比较好的放上来)。

生成图像的质量与低分辨率输出(lowres output)实现密切相关。我通常在第一阶段生成 128×128 或者 256×256 像素的结果,然后在第二阶段提升至 768×768 或者 1024×1024。大多数情况下,生成的结果都很糟糕,远远没有我挑选出来的这几张好,但有些时候会出现非常富有艺术性的图像,偶尔看上去还像是有艺术风格诞生。

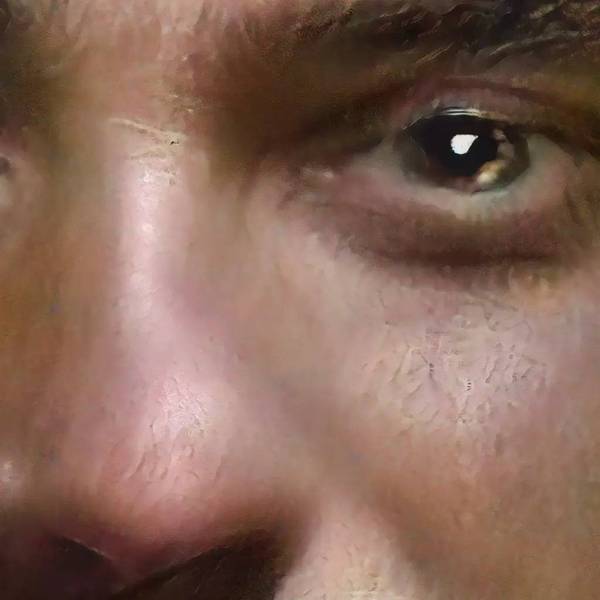

我在最后的第三阶段将像素提升到 4k。但是,实际上我并没有这个像素级别的训练数据,也就是说,网络做的只是大致预测边缘是否平滑等等。

系统不可能知道皮肤高分辨率的人脸数据库。毛孔或睫毛这些细节。因此,我们需要一个与高分辨率的人脸数据库。

考虑到最终的印刷效果,在这种分辨率下故意保留一些 artifact 可能还不错(相比 )。

Mike Tyka 参考了下面这篇论文中所提到的方法 Stack-GAN,并且在论文基础上做了 3 次堆叠。有兴趣你也可以一试:)

摘要

根据文本描述合成逼真图像是计算机视觉一大挑战,也有很多应用。使用现有方法合成的图像在细节和生动方面差强人意。本文中,我们提出 StakeGAN 方法,根据文本描述生成逼真的图像。在第一阶段(Stage-I GAN),GAN 根据给定描述生成相对原始的形状和基本的色彩,得出 Stage-I 低分辨图像。Stage-II GAN 将 Stage-I GAN 和文本描述作为输入,生成高分辨率的逼真图像。Stage-II GAN 能够修正错误,增加令人信服的效果和细节。使用 StackGAN 生成的图像比现有方法更加合理逼真。最重要的是,StackGAN 根据文本第一次生成 256×256 像素的图像,现有方法最多只能生成 128×128 像素的图像。

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4568.html

摘要:据报道,生成对抗网络的创造者,前谷歌大脑著名科学家刚刚正式宣布加盟苹果。他将在苹果公司领导一个机器学习特殊项目组。在加盟苹果后会带来哪些新的技术突破或许我们很快就会看到了。 据 CNBC 报道,生成对抗网络(GAN)的创造者,前谷歌大脑著名科学家 Ian Goodfellow 刚刚正式宣布加盟苹果。他将在苹果公司领导一个「机器学习特殊项目组」。虽然苹果此前已经缩小了自动驾驶汽车研究的规模,但...

摘要:文本谷歌神经机器翻译去年,谷歌宣布上线的新模型,并详细介绍了所使用的网络架构循环神经网络。目前唇读的准确度已经超过了人类。在该技术的发展过程中,谷歌还给出了新的,它包含了大量的复杂案例。谷歌收集该数据集的目的是教神经网络画画。 1. 文本1.1 谷歌神经机器翻译去年,谷歌宣布上线 Google Translate 的新模型,并详细介绍了所使用的网络架构——循环神经网络(RNN)。关键结果:与...

阅读 3918·2021-09-23 11:32

阅读 2603·2021-09-06 15:01

阅读 1699·2021-08-18 10:24

阅读 3568·2019-12-27 11:44

阅读 3674·2019-08-30 15:52

阅读 2579·2019-08-30 11:11

阅读 812·2019-08-29 17:27

阅读 664·2019-08-29 16:22