资讯专栏INFORMATION COLUMN

摘要:研究将会出现在年的会议上,会议将于月在的举办。和大学的研究生证明,哈希技术是一种真实的数据索引方法,可以大大减少深度学习的计算消耗。深度学习网络的基础建造模块是一个人造神经元。据报道,谷歌正在尝试训练一个拥有亿个神经元的网络。

美国莱斯大学(Rice University )的计算机科学家通过使用被广泛使用的快速数据查找技术,以大幅度减少深度学习所必需的计算量,进而大大地节约了能源和时间。

莱斯大学计算机科学家已经采用了广泛使用的快速数据查找技术,以减少计算量,从而减少了深度学习所需的能量和时间,这是一种计算强大的机器学习形式。

“这能运用到任何一种深度学习架构中,并且,其技巧是亚线性扩展的,也就是说,运用的神经网络越大,能节省的计算资源就会越多”,莱斯大学计算机科学系助理教授、该研究的第一作者 Anshumali Shrivastava 介绍说。

研究将会出现在2017年的 KDD 会议上,会议将于8月在Nova Scotia的Halifax 举办。这一研究解决了谷歌、Facebook 和 微软等这些争先恐后地希望搭建、训练和部署大规模的深度神经网络的科技巨头最紧迫的需求之一。它们希望用深度学习来满足越来越多的产品需求,如自动驾驶汽车,语言翻译和智能回复电子邮件等。

Shrivastava和 Rice 大学的研究生 Ryan Spring 证明,“哈希”(Hashing)技术是一种真实的数据索引方法,可以大大减少深度学习的计算消耗。“哈希” 涉及使用智能散列函数将数据转换为可管理的小数,称为哈希。哈希被存储在表格中,其运行方式就好像纸质书中的索引。

“我们的方法混合了两种技术:一个局部敏感哈希 clever 变量,以及一个稀疏的反向传播。这样就能在不大量地降低准确率的情况下,减少必要的计算消耗。Spring 说,“比如,在小规模的测试中,我们发现在标准方法下,能在准确率损失控制在1%的情况下,将计算能耗减少95%。”

深度学习网络的基础建造模块是一个人造神经元。虽然1950年代,生物神经元的首先被发现,但是,人造神经元只是一个数学函数和等式,建立在大量的数据之上,可以转化为输出。

在机器学习中,所有的神经元都从一张白纸的“空”状态开始,在训练过程中变得特异化(specialized)。在训练期间,网络被“给予”大量数据,每个神经元都成为识别数据中特定模式的专家。在较低层,神经元执行最简单的任务。例如,在照片识别应用中,低级神经元可能识别来自暗处的光线或物体的边缘。这些神经元的输出被传递到网络下一层的神经元中,这些神经元又会以其特有的方式搜索它们会识别的特征。

只有几层的神经网络就可以学习识别人脸、各种犬类、停车标志和校车。

Shrivastava 说:“向网络的每层增加更多的神经元可以增强其表现力(expressive power),而且我们想要网络有多大这一点没有上限。”

据报道,谷歌正在尝试训练一个拥有 1370 亿个神经元的网络。相比之下,训练和部署这样的网络需要的计算力是有限的。

Shrivastava 说,目前使用的大多数机器学习算法都是 30 到 50 年前开发的,在设计的时候没有考虑到计算的复杂性。但是,有了大数据之后,对于计算周期、能源和内存等资源来说,就存在着基本的限制,而“我们的实验室侧重于解决这些限制。”

Spring 表示,在大规模深度网络中,hashing 带来的计算和节能将会更大。

Spring 说,由于他们利用大数据中固有的稀疏性,因此能量的节省会随着网络规模的增加而增加。“假设一个深度网络有 10 亿个神经元,对于任何一个给定输入——例如一张狗的图片——只有少部分神经元会被激活。

在数据科学的术语中,这就叫做稀疏性(sparsity),而正因为有了稀疏性,他们的方法节省的能量会随着网络规模的扩大而增加。

“所以,1000 个神经元的网络我们能节能 95%,根据数学推导,10 亿个神经元的网络我们就能节能 99%。”

原文:https://phys.org/news/2017-06-scientists-slash-deep.html#jCp

Ryan Spring (左) 和 Anshumali Shrivastava.

通过随机哈希实现可扩展、可持续的深度学习

这篇论文《通过随机哈希实现可扩展、可持续的深度学习》(Scalable and Sustainable Deep Learning via Randomized Hashing),已经作为 Oral 被 KDD 2017 接收。

虽然论文的同行评议版本要到 KDD 召开时才能得知,通过网上的资料,我们可以看到去年底 Spring 在 arXiv 上传的论文预印版(地址:https://arxiv.org/pdf/1602.08194.pdf)。

为了从复杂的数据集中学习,当前深度学习框架越来越大。这些框架需要进行巨大的矩阵乘法运算来训练数百万个参数。与此相反,另一个呈增长的趋势是将深度学习带入低功耗、嵌入式设备。为了训练和测试深度网络而进行的相关矩阵运算,从计算和能量消耗的角度看是非常昂贵的。我们提出了一种基于 Hashing 的新技术,大幅减少了训练和测试神经网络所需的计算量。我们的方法结合了最近提出的两大概念,即自适应 dropout 和较大内部搜索(MIPS)随机 Hashing,有效选择网络中具有较高激活的节点。

这一新深度学习算法通过在(数量明显更少的)稀疏节点上运行,减少前向和后向传播步骤的总体计算成本。因此,我们的算法在保持原始模型平均精度 1% 的同时,仅使用总乘法的 5%。

论文提出的基于 Hashing 的反向传播算法,一个独特属性是 update 总是稀疏的。而由于稀疏梯度 update,我们的算法非常适合异构和并行训练。通过在几个真实数据集上进行严格的实验评估,我们证明了提出的算法具有可扩展性和可持续性(能量效率高)。

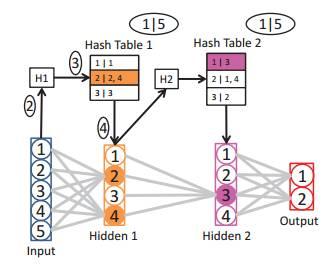

神经网络进行随机哈希的视觉展示

图1:从图中可见,神经网络 Low-Rank 假设需要的参数数量自然会更少

图2:对神经网络进行随机哈希的视觉展示。① 建一个哈希表,方法是对每个隐藏层(一次迭代)的权重做哈希。② 使用该层的随机哈希函数对该层的输入做哈希。③ 查询这一层的哈希表,获取激活数据集 AS。④ 仅在激活神经元上做前向和后向传播。⑤ 更新 AS 权重和哈希表。

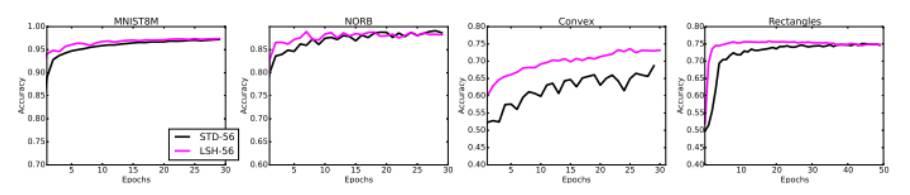

56 核的英特尔 Xeon ES-2697 处理器上的性能比较

图7:一个标准网络使用我们的方法(随机哈希)和使用异构随机梯度下降,在 56 核的英特尔 Xeon ES-2697 处理器上的性能比较。我们依次在 MNIST、NORB、Convex 和 Rectangles 数据集上进行了测试。所有网络的初始值都是一样的。

图8:新方法(LSH-5%)使用异构随机梯度下降每步(per epoch)获得的挂钟时间。我们用一个有 3 层隐藏层的网络,依次在 MNIST、NORB、Convex 和 Rectangles 数据集上进行了测试。Convex 和 Rectangles 数据集上增量较少,是因为在整个过程中可用的训练样本不够多。实验中只使用了 5% 的标准网络计算量。

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4551.html

摘要:和的得分均未超过右遗传算法在也表现得很好。深度遗传算法成功演化了有着万自由参数的网络,这是通过一个传统的进化算法演化的较大的神经网络。 Uber 涉及领域广泛,其中许多领域都可以利用机器学习改进其运作。开发包括神经进化在内的各种有力的学习方法将帮助 Uber 发展更安全、更可靠的运输方案。遗传算法——训练深度学习网络的有力竞争者我们惊讶地发现,通过使用我们发明的一种新技术来高效演化 DNN,...

摘要:毫无疑问,深度学习将驱动在公司中的应用。在其价值评估和策略评估上使用的就是深度学习。端到端的深度学习是一个令人着迷的研究领域,但是迄今为止混合系统在应用领域会更有效率。目前专注于深度学习模式,方法和战略的研究。 在之前的博客中,我曾预言过未来几年的发展趋势。我记得上一篇博客的内容是《2011年软件开发趋势和相关预言》(Software DevelopmentTrends and Predic...

摘要:卷积神经网络原理浅析卷积神经网络,最初是为解决图像识别等问题设计的,当然其现在的应用不仅限于图像和视频,也可用于时间序列信号,比如音频信号文本数据等。卷积神经网络的概念最早出自世纪年代科学家提出的感受野。 卷积神经网络原理浅析 卷积神经网络(Convolutional Neural Network,CNN)最初是为解决图像识别等问题设计的,当然其现在的应用不仅限于图像和视频,也可用于时间序...

摘要:在学习过程中,神经网络的突触权重会以一种有序的方式进行修改,从而实现所需的目标。中间单元的数量被称为网络所用的片的数量。 随着神经网络的进化,许多过去曾被认为不可想象的任务现在也能够被完成了。图像识别、语音识别、寻找数据集中的深度关系等任务现在已经变得远远更加简单了。在此向这一领域的杰出的研究者致以真诚的谢意,正是他们的发现和成果帮助我们利用上了神经网络的真正力量。如果你真正对追求机器学习这...

摘要:前言阿里巴巴机器智能实验室线下智能团队从年底开始涉及线下智能领域,从算法工程产品化业务落地多个方面入手,与合作伙伴们一起取得了一些小小的成绩。目前,该套工具作为推荐的量化工具广泛应用在阿里集团内多个线下业务场景中。 showImg(https://segmentfault.com/img/remote/1460000019246850); 阿里妹导读:AI 技术已经从互联网走向零售、...

阅读 3278·2021-11-25 09:43

阅读 3275·2021-11-23 09:51

阅读 3566·2019-08-30 13:08

阅读 1620·2019-08-29 12:48

阅读 3642·2019-08-29 12:26

阅读 446·2019-08-28 18:16

阅读 2612·2019-08-26 13:45

阅读 2475·2019-08-26 12:15