资讯专栏INFORMATION COLUMN

摘要:生物学上合理的认知计算模型用梯度下降算法训练的经典认知计算模型需要将基于准确的前馈神经元突触权重的误差信号反向传播,这在生物学的神经系统中被认为是不可能的。

反向传播(BP)算法被认为是用于训练深度神经网络的“事实上”(de-facto)的方法。它使用前馈权重的转置,以较精确的方式将输出层的误差反向传播到隐藏层。然而,有人认为,这在生物学上是不合理的,因为在生物神经系统中,带有准确输入权重的误差信号的反向传播被认为是不可能的。在本研究中,基于神经科学和与BP 类似的不对称方法的相关文献,研究者提出了一种在生物学上合理的神经结构范式。具体来说,研究者提出了两种具有可训练前馈和反馈权重的双向学习算法。前馈权重用于将 activation 从输入中继到目标输出。反馈权重则将误差信号从输出层传递到隐藏层。与其他和BP类似的不对称方法不同,反馈权重在框架中也很易变,并且被训练来逼近 forward activition。初步结果表明,研究提出的模型在 MNIST 和 CIFAR-10 数据集上优于其他和BP类似的不对称方法。

论文导读

反向传播(BP)算法是反向模式自动分化和最速下降法的结合,它被认为是用于训练深度神经网络(DNN)的方法。它以较精确的方式将误差从输出层逐层反向传播到输入层。然而,有人认为,在生物学上,大脑中涉及较精确的对称反向信道的学习是不可能的。

在深度学习的早期阶段,先使用 Boltzmann 机器进行无人监督的预训练,然后再用 BP 进行微调,不涉及对称权重,且是基于生物学机制的。最近,关于开发生物学上可行且实用的 BP 替代方案的研究越来越多。

另一方面,归因于神经科学类的文献,长期增强(LTP)被认为是人类记忆和学习的重要一步。如在LTP 中引入的,神经元之间的强联系从神经调节步骤开始,其中一个神经元将更多的离子受体移动到其树突的膜上。结果就是,更多的离子被捕获,从而放大了电脉冲。

基于LTP 的原理和反馈权重易变这一假设,我们提出了一种在生物学层面更合理的感知范式和两个双向学习模型。在这些双向学习模型中,前馈权重在正向相位调整,反馈权重在后向阶段被学习。我们提出的模型消除了反馈权重必须是随机和固定的假设。反馈权重被训练来逼近训练期间的前向激活。基准数据集的实验表明,我们的模型优于使用固定反馈权重来传输误差信号的 FA (feedback-alignment model)和 DFA(direct feedback-alignment model)。我们还提供了关于为什么使用自适应权重传输误差信号优于使用固定权重的初步分析。据我们所知,这是表明自适应非对称反馈信道比 DNN 中的随机和固定反馈信道更有效的首次研究尝试。

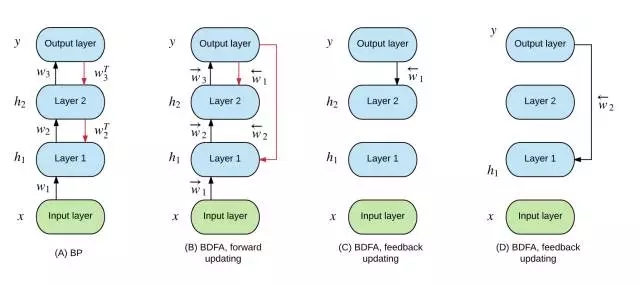

图1:BP(Back-propagation)、FA(feedback-alignment)和 DFA (direct feedback-alignment)模型。黑色箭头代表正向激活路径。红色箭头表示误差(梯度)传播路径。

传统带有 BP、FA 和 DFA 的 DNN 是单向的,意味着它们只是学习如何将输入描绘成目标输出。本研究基于神经科学的相关文献,提出了一种生物学上合理的计算机认知模型,并继而提出了双向反馈比对(bidirectional feedback alignment,BFA)和双向直接反馈比对(bidirectional direct feedbackalignment,BDFA)模型,分别用针对前向和后向进程的两组可训练权重连接神经元。

生物学上合理的认知计算模型

用梯度下降算法训练的经典认知计算模型需要将基于准确的前馈神经元突触权重的误差信号反向传播,这在生物学的神经系统中被认为是不可能的。另一方面,长时程增强(LTP)被认为是生物学中记忆和认知科学中学习的基本要素。

长时程增强

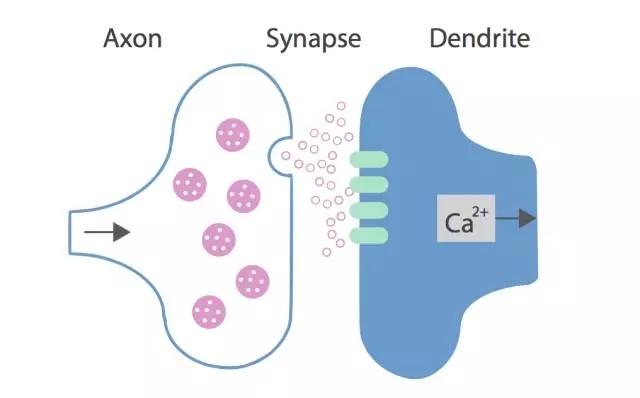

生物神经元由神经元突触连接,包括轴突和树突,其中轴突发射信号,下一个神经元的树突则接收由轴突发射出的信号。然而,轴突和树突被突触间隙分开,轴突通过向突触间隙中释放离子来发送电脉冲,离子则被树突细胞膜上的感受器捕获。结构如下图:

图2:轴突和树突之间的神经连接架构

BioPP 模型的组件如下:

•信号

BioPP 架构中有两套信号:前馈信号——信号在网络中正向传播,应对推理任务;错误信号——信号向后传播,用于调节突触权重

•权重

权重代表了认知计算模型决定从输入或相邻神经元中捕获的信号数量。应该指出,认知计算模型采用的误差信号数量也是由其自身决定的。BioPP 会基于输入中的误差信号,调整其自身的权重,然后再将误差信号发送给其他神经元。

• 激活和偏差

激活和偏差的定义和用 BP 训练的标准 DNN 中的相关定义没有什么差别。

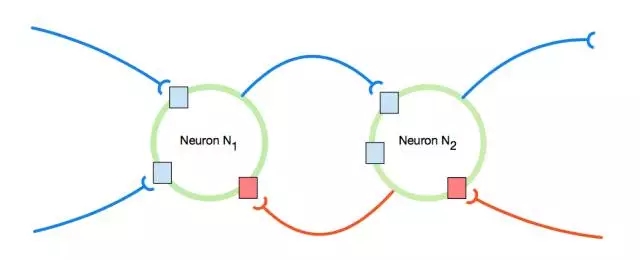

BioPP 的架构如图 3 所示,其中绿色的圈是神经元,蓝色的曲线代表前向突触,红色的曲线代表着后向突触。蓝色的方块和红色的方块分别是前向突触和后向突触的感知器。值得一提的是,根据 BioPP 的定义,权重是由感知器来调整的。

图3:2 个BioPP之间的神经元连接的架构

BioPP 有三个限制:

在输入权重时,误差信号不能被计算,因为轴突势单向地传递神经信号;

基于内部或外部的误差信号,神经元可以在本地学习其权重;

所有输入的权重应该具有自适应性。

FA 和 DFA 中提出的神经模型和 BioPP (其中一些权重是固定的)原则不完全相合。下面我们以 BioPP 原则为基础,优化 FA 和 DFA 的反馈权重,并在基准数据集测试模型。

双向训练 BioPP 网络

FA 和 DFA 都使用固定随机权重来传递误差信号,以此训练神经网络。在 BioPP 中,我们使得权重能够像一般输入权重那样具有自适应性。

图4:双向反馈比对(BFA)。黑色箭头代表前向激活路径。红色箭头表示误差(梯度)传播路径。

BFA 的整体流程见图4。BFA 的主要思路是当训练一组权重时,误差信号通过其他组权重在网络中逐层传递。BFA 满足了 BioPP 的原则和限制。BFA 和目标传播(TP)间的区别是,BFA 学习输入特征,并逐层传播误差信号。而 TP 中的各层则还在用自编码网络(Autoencoder)学习前一层的输入。

图5:双向直接反馈比对(BDFA)。黑色箭头代表前向激活路径。红色箭头表示误差(梯度)传播路径。

BDFA 的总体流程如图5 所示。BDFA 模型的总体思路是,每个隐藏层多带带计算损失,并更新相应的、连接隐藏层和输入层的反馈权重矩阵。

接下来,研究者又分析了为什么应用于双向训练模型中的自适应反馈权重总体上说比固定反馈权重表现更好,并证明了如果反馈权重可以更好地学习描写输入特征和输出特征,训练的整体表现就会得到提升。之后,研究者又对在基准数据集上,在不同超参数设定的条件下, BFA 和 BDFA 的性能是否超过了 FA 和 DFA。

在论文的最后,研究者指出该研究是据他们所知的第一次研究尝试,来论证在DNN 中,自适应非对称反馈信道比随机固定信道要更有效。尽管现在还不清楚大脑是否实施了自适应反馈这一特殊形式,该研究仍然朝着更好理解大脑如何支持从误差信号中学习这一方向迈出了重要的一步。

原文链接:https://arxiv.org/abs/1702.07097

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4517.html

摘要:近几年以卷积神经网络有什么问题为主题做了多场报道,提出了他的计划。最初提出就成为了人工智能火热的研究方向。展现了和玻尔兹曼分布间惊人的联系其在论文中多次称,其背后的内涵引人遐想。 Hinton 以深度学习之父 和 神经网络先驱 闻名于世,其对深度学习及神经网络的诸多核心算法和结构(包括深度学习这个名称本身,反向传播算法,受限玻尔兹曼机,深度置信网络,对比散度算法,ReLU激活单元,Dropo...

摘要:多加了这两层卷积层和汇集层是卷积神经网络和普通旧神经网络的主要区别。卷积神经网络的操作过程那时,卷积的思想被称作权值共享,也在年和关于反向传播的延伸分析中得到了切实讨论。 导读:这是《神经网络和深度学习简史》第二部分,这一部分我们会了解BP算法发展之后一些取得迅猛发展的研究,稍后我们会看到深度学习的关键性基础。神经网络获得视觉随着训练多层神经网络的谜题被揭开,这个话题再一次变得空前热门,罗森...

摘要:导读这是神经网络和深度学习简史第一部分。实际上,神经网络准确的说应该是人工神经网络,就是多层感知机今天感知机通常被称为神经元而已,只不过在这个阶段,只有一层输出层。多层输出的神经网络也可以想象一个与感知机不同的人工神经网络。 导读:这是《神经网络和深度学习简史》第一部分。这一部分,我们会介绍1958年感知机神经网络的诞生,70年代人工智能寒冬以及1986年BP算法让神经网络再度流行起来。深度...

摘要:在普通的全连接网络或中,每层神经元的信号只能向上一层传播,样本的处理在各个时刻独立,因此又被成为前向神经网络。不难想象随着深度学习热度的延续,更灵活的组合方式更多的网络结构将被发展出来。 从广义上来说,NN(或是更美的DNN)确实可以认为包含了CNN、RNN这些具体的变种形式。在实际应用中,所谓的深度神经网络DNN,往往融合了多种已知的结构,包括卷积层或是LSTM单元。这里的DNN特指全连接...

阅读 2468·2023-04-25 19:27

阅读 3558·2021-11-24 09:39

阅读 3973·2021-10-08 10:17

阅读 3448·2019-08-30 13:48

阅读 1994·2019-08-29 12:26

阅读 3170·2019-08-28 17:52

阅读 3583·2019-08-26 14:01

阅读 3585·2019-08-26 12:19