资讯专栏INFORMATION COLUMN

摘要:是直接作用于图的卷积神经网络,允许对结构化数据进行端到端的学习,也即输入可以是任意大小和形状的图。图谱卷积和图卷积神经网络举个例子,让我们看下面这个十分简单的分层优化传播规律是神经网络层的权矩阵,是像这样的非线性激活函数。

Graph Convolutional Network(GCN)是直接作用于图的卷积神经网络,GCN 允许对结构化数据进行端到端的学习,也即输入可以是任意大小和形状的图。本文介绍 GCN 进展,讨论各种方法的优势和缺陷。GCN 未来如何拓展用于解决特定类型的问题,例如学习指示图或关系图,以及怎样用学习的图嵌入更多任务,也值得期待。

现实世界里很多重要的数据集都以图表或网络的形式呈现,例如:社交网络、知识图谱、蛋白质相互作用网络、万维网,等等。然而直到最近,神经网络模型对这些结构化数据集的泛化仍然很少得到关注。

过去几年,很多研究重新思考了推广神经网络用于任意结构化图表的问题(Bruna et al., ICLR 2014; Henaff et al., 2015; Duvenaud et al., NIPS 2015; Li et al., ICLR 2016; Defferrard et al., NIPS 2016; Kipf & Welling, 2016),其中有些已经在某些领域取得了非常不错的结果,而这些领域过去使用基于核函数的方法、基于图的正则化技术或其他方法。

在这篇文章里,我将对这个领域的进展作一个简要概述,并指出各种方法的强处和不足。这些讨论主要关注最近的两篇论文:

Kipf & Welling (2016), Semi-Supervised Classification with Graph Convolutional Networks (免责声明: 我是这篇的第一作者)

Defferrard et al. (NIPS 2016), Convolutional Neural Networks on Graphs with Fast Localized Spectral Filtering

以及 Ferenc Huszar 的评论文章:How powerful are Graph Convolutions? 这篇文章讨论了这些类型的模型的一些限制。

图神经网络模型(Neural Network Models on Graphs)简要介绍

图卷积网络有多强大?

推广成熟的神经模型例如RNN或CNN用于任意结构图表是个有挑战性的问题。最近的一些论文,介绍了针对特定问题的架构(e.g. Duvenaud et al., NIPS 2015; Li et al., ICLR 2016; Jain et al., CVPR 2016),还有一些利用谱图理论(Bruna et al., ICLR 2014; Henaff et al., 2015)的图卷积来定义用于多层神经网络模型的参数化滤波器,类似我们熟悉的“经典”CNN。

最近的研究关注缩小快速的启发式算法和较慢、但更有规则性的谱分方法间的差距。Defferrard 等人(NIPS 2016)用神经网络模型学习的自由参数的Chebyshev多项式模拟了谱域的平滑滤波。他们在正则区域(像是MNIST)得到了有说服力的结果,很接近简单2D CNN模型的结果。

Kipf & Welling (2016)的研究采用了类似的方法,从图谱卷积框架开始,介绍了许多情况下能同时显著加快训练时间和提高预测准确度的最简化方法,在许多基准图集上得到了极好的分类结果。

图卷积神经网络(GCN)定义

目前,大多数图神经网络模型都有一个某种程度上通用的普遍框架。我把这些模型称作图卷积网络(Graph Convolutional Networks, GCNs);卷积,是因为滤波器参数通常在图的所有位置中共享(或在其子集,参见 Duvenaud et al. NIPS 2015)。

对这些模型来说,目标是学习图的信号/特征函数G =(V, E),它的输入如下:

对每个节点 i 的特征描述为 xi;概括在特征矩阵 N×D(N:节点数,D:输入特征数)

以矩阵形式对图结构的代表描述;通常以邻接矩阵 A(或其他函数)的形式

然后生成一个节点层的输出 Z(N×F 特征矩阵,F是每个节点输出特征的数量)。图层面的输出可以引入一些池化操作(参见:e.g. Duvenaud et al., NIPS 2015)。

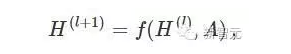

每个神经网络层可以写成一个非线性函数:

H(0) = X 和 H(L) = Z (或在图层面的输出时,z),L表示层数。模型不同的只有怎样选择f(··,·)的参数设定。

图谱卷积和图卷积神经网络

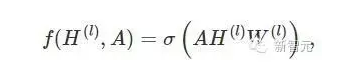

举个例子,让我们看下面这个十分简单的分层优化传播规律:

W(l) 是神经网络 l 层的权矩阵,σ(⋅)是像ReLU这样的非线性激活函数。虽然这个模型非常简单,但它已经是非常强大的。

但让我们先了解这个简单模型的两点局限性:A的增殖意味着对每个节点,我们需要把所有相邻节点的所有特征矢量相加,但不能加上节点本身(除非图上有自回路)。我们可以强迫图执行自回路:在单位矩阵中加上A。

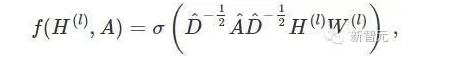

第二个主要的局限是A 通常不是标准化的,所以A的增殖会完全改变特征矢量是规模。标准化A能解决这个问题,例如将所有列归一,即D−1A,D是对角线节点次数矩阵。用D−1A相乘符合相邻节点特征的平均值。在实践中,使用对称标准化,即

这就不仅是相邻节点的平均值,动态性会显得更有趣。把这两个小技巧结合在一起,我们最终得到了 Kipf &Welling(2016) 论文中介绍的传播规律:

其中,I 是单位矩阵,是的对角线节点的度矩阵。

总结

这个课题的研究才刚刚起步。过去几个月里已经能看到令人兴奋的成果,但我们可能才刚刚触及这些类型的表面。图神经网络将怎样应用于解决特定类型的问题,例如,对指示图或关系图的学习,以及怎样用学习的图嵌入更多任务等等。这里列举的还不是全部,我期待在不久的将来有更多人对应用和扩展感兴趣。

了解更多 & 编译来源:

http://tkipf.github.io/graph-convolutional-networks/#gcns-part-iii-embedding-the-karate-club-network

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4413.html

摘要:目前较好的语音识别系统采用双向长短时记忆网络,,这种网络能够对语音的长时相关性进行建模,从而提高识别正确率。因而科大讯飞使用深度全序列卷积神经网络来克服双向的缺陷。 人工智能的应用中,语音识别在今年来取得显著进步,不管是英文、中文或者其他语种,机器的语音识别准确率在不断上升。其中,语音听写技术的发展更为迅速,目前已广泛在语音输入、语音搜索、语音助手等产品中得到应用并日臻成熟。但是,语音应用的...

摘要:描述我们在做报表的时候,往往想体现其中随着时间的变化而产生的项目进度的变化和其他相关的系统进展,每当这种时候甘特图便是其中的不二之选。新增的多项目甘特图可以说是满足了大多数的需要。 1.描述我们在做报表的时候,往往想体现其中随着时间的变化而产生的项目进度的变化和其他相关的系统进展,每当这种时候甘特图便是其中的不二之选。FineReport新增的多项目甘特图可以说是满足了大多数的需要。最...

摘要:描述我们在做报表的时候,往往想体现其中随着时间的变化而产生的项目进度的变化和其他相关的系统进展,每当这种时候甘特图便是其中的不二之选。新增的多项目甘特图可以说是满足了大多数的需要。 1.描述我们在做报表的时候,往往想体现其中随着时间的变化而产生的项目进度的变化和其他相关的系统进展,每当这种时候甘特图便是其中的不二之选。FineReport新增的多项目甘特图可以说是满足了大多数的需要。最...

摘要:图神经网络是近年发展起来的一个很有前景的深度学习方向,也是一种强大的图点云和流形表示学习方法。地址基于的几何深度学习扩展库是一个基于的几何深度学习扩展库,用于不规则结构输入数据,例如图点云和流形。与相比,训练模型的速度快了倍。 过去十年来,深度学习方法(例如卷积神经网络和递归神经网络)在许多领域取得了前所未有的成就,例如计算机视觉和语音识别。研究者主要将深度学习方法应用于欧氏结构数据 (Eu...

阅读 1221·2021-11-11 16:55

阅读 3107·2021-08-16 11:00

阅读 2947·2019-08-30 15:56

阅读 3485·2019-08-30 11:24

阅读 3457·2019-08-30 11:05

阅读 3570·2019-08-29 15:15

阅读 2660·2019-08-26 13:57

阅读 2637·2019-08-23 18:17