资讯专栏INFORMATION COLUMN

摘要:昨天,谷歌宣布开放,这是一个在中定义训练和评估模型的轻量软件包,同时它还能对图像分类领域中的数个有竞争力的网络进行检验与模型定义。今天,谷歌再次宣布开放,一个在图像分类基准上取得顶尖准确率的卷积神经网络。

昨天,谷歌宣布开放 TF-Slim,这是一个在 TensorFlow 中定义、训练、和评估模型的轻量软件包,同时它还能对图像分类领域中的数个有竞争力的网络进行检验与模型定义。今天,谷歌再次宣布开放 Inception-ResNet-v2,一个在 ILSVRC 图像分类基准上取得顶尖准确率的卷积神经网络。文中提到的论文可点击「阅读原文」进行下载。

为了在该领域取得更多进展,今天我们非常高兴的宣布开放 Inception-ResNet-v2,这是一个在 ILSVRC 图像分类基准上取得顶尖准确率的卷积神经网络。Inception-ResNet-v2 是早期发布的 Inception V3 模型的变体,该模型借鉴了微软 ResNet 论文中的思路。具体内容可在我们的论文:Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning 中看到。

残差连接(Residual connections )允许模型中进行 shortcut,也使得研究员能成功的训练更深的神经网络从而产生更好的性能。这也使得 Inception 块的极度简单化成为可能。下图对比了这两个模型架构:

Inception V3 图解

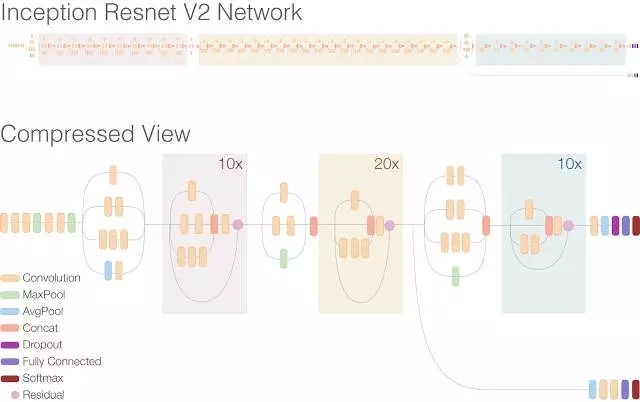

Inception-ResNet-v2 的图解

在第二张图解的顶端,你可以看到全部的网络拓展,可以注意到该网络比之前的 Inception V3 要深得多。主图的下面是更简单阅读同一网络版本的方式,里面重复的残差块是被压缩了。注意,里面的 Inception 块被简化的,比先前的 Inception V3 包含更少的并行塔 (parallel towers)。

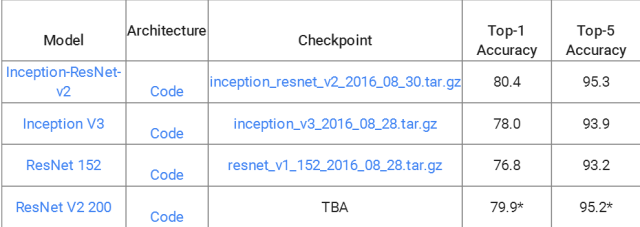

Inception-ResNet-v2 架构比之前的前沿模型更加准确。下表报告了在基于单类图像的 ILSVRC 2012 图像分类基准上的 Top-1 和 Top-5 的准确度检验结果。此外,该新模型相比于 Inception V3 大约只需要两倍的存储和计算能力。

结果援引于 ResNet 论文

举个例子,Inception V3 和 Inception-ResNet-v2 模型在识别犬种上都很擅长,但新模型做的更好。例如,旧模型错误报告右图中的狗是阿拉斯加雪橇犬,而新的 Inception-ResNet-v2 模型准确识别了两张图片中的狗的种类。

阿拉斯加雪橇犬(左),西伯利亚爱斯基摩狗(右)

为了让人们能立即进行试验,我们也发布了 Inception-ResNet-v2 模型的一个预训练案例作为 TF-Slim 图像模型库的一部分。

如果想进行试验,这是如何训练、评估或微调网络的指导:https://github.com/tensorflow/models/blob/master/slim/README.md

欢迎加入本站公开兴趣群商业智能与数据分析群

兴趣范围包括各种让数据产生价值的办法,实际应用案例分享与讨论,分析工具,ETL工具,数据仓库,数据挖掘工具,报表系统等全方位知识

QQ群:81035754

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4407.html

早期成果卷积神经网络是各种深度神经网络中应用最广泛的一种,在机器视觉的很多问题上都取得了当前较好的效果,另外它在自然语言处理,计算机图形学等领域也有成功的应用。第一个真正意义上的卷积神经网络由LeCun在1989年提出[1],后来进行了改进,它被用于手写字符的识别,是当前各种深度卷积神经网络的鼻祖。接下来我们介绍LeCun在早期提出的3种卷积网络结构。 文献[1]的网络由卷积层和全连接层构成,网络...

摘要:我们在已经准备好的图像数据集上,使用库训练一个卷积神经网络。示例包含用于测试卷积神经网络的图像。训练,绘制准确性损耗函数,然后将卷积神经网络和类标签二进制文件序列化到磁盘。第和行将训练集和测试集按照的比例进行分割。 showImg(https://segmentfault.com/img/bV9lqk?w=698&h=698); 为了让文章不那么枯燥,我构建了一个精灵图鉴数据集(Pok...

阅读 3651·2021-11-25 09:43

阅读 3183·2021-10-08 10:04

阅读 1681·2019-08-26 12:20

阅读 2120·2019-08-26 12:09

阅读 675·2019-08-23 18:25

阅读 3632·2019-08-23 17:54

阅读 2402·2019-08-23 17:50

阅读 864·2019-08-23 14:33