资讯专栏INFORMATION COLUMN

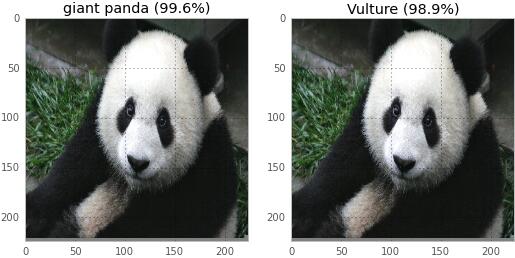

摘要:我们可以让它相信,下面黑色的图像是一张纸巾,而熊猫则会被识别为一只秃鹫现在,这个结果对我来说并不吃惊,因为机器学习是我的工作,而且我知道机器学习习惯产生奇怪的结果。

神奇的神经网络

当我打开Google Photos并从我的照片中搜索“skyline”时,它找到了我在八月拍摄的这张纽约地平线的照片,而我之前并未对它做过任何标记。

当我搜索‘cathedral’,Google的神经网络会找到我曾看到的大教堂和教堂。这似乎很神奇。

当然,神经网络并不神奇,一点都不!最近我阅读了一篇论文,“Explaining and Harnessing Adversarial Examples(对抗样本的解释和利用)”,进一步削弱了我对神经网络的神秘感。

这篇论文介绍了如何欺骗神经网络,让其犯下非常惊人的错误。通过利用比你想象更简单(更线性!)的网络事实来做到这一点。我们会使用一个线性函数来逼近这个网络!

重点是要理解,这并不能解释神经网络犯下的所有(或是大多数)类型的错误!有很多可能会犯的错误!但它确实在一些特定类型的错误上给了我们一些灵感,这非常好。

在阅读这篇论文之前,我对神经网络的了解有以下三点:

它在图片分类中表现得很出色(当我搜索“baby”时,它会找到我朋友可爱的孩子照片)

大家都在网上谈论“深度”神经网络

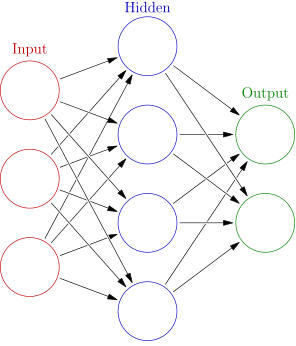

它们是由多层简单的函数(通常是sigmoid)构成,其结构如下图所示:

错误

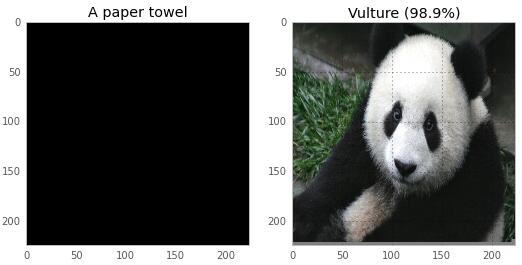

我对神经网络了解的第四点(也是最后一点)是:它们有时会犯很可笑的错误。剧透一下本文后面的结果:这是两张图片,文章会展示神经网络是如何对其进行分类的。我们可以让它相信,下面黑色的图像是一张纸巾,而熊猫则会被识别为一只秃鹫!

现在,这个结果对我来说并不吃惊,因为机器学习是我的工作,而且我知道机器学习习惯产生奇怪的结果。但如果要解决这个超级奇怪的错误,我们就需要理解其背后的原理!我们要学习一些与神经网络有关的知识,然后我会教你如何让神经网络认为熊猫就是一只秃鹫。

做第一个预测

我们首先加载一个神经网络,然后做一些预测,最后再打破这些预测。这听起来真棒。但首先我需要在电脑上得到一个神经网络。

我在电脑上安装了Caffe,这是一个神经网络软件,是Berkeley Vision and Learning Center (BVLC) 社区贡献者开发的。我选择它是因为它是我第一个可以找到的软件,而且我可以下载一个预先训练好的网络。你也可以尝试下Theano或者Tensorflow。Caffe有非常清晰的安装说明,这意味着在我正式使用它进行工作前,仅仅只需花6个小时来熟悉。

如果你想要安装Caffe,可以参考我写的程序,它会让你节省更多的时间。只需去the neural-networks-are-weird repo这个仓库,然后按照说明运行即可。警告:它会下载大约1.5G的数据,并且需要编译一大堆的东西。下面是构建它的命令(仅仅3行!),你也可以在仓库下的README文件中找到。

git clone https://github.com/jvns/neural-nets-are-weird

cd neural-nets-are-weird

docker build -t neural-nets-fun:caffe .

docker run -i -p 9990:8888 -v $PWD:/neural-nets -t neural-nets-fun:caffe /bin/bash -c "export PYTHONPATH=/opt/caffe/python && cd /neural-nets && ipython notebook --no-browser --ip 0.0.0.0"

这会启动你电脑中的IPython notebook服务,然后你便可以用Python做神经网络预测了。它需要在本地9990端口中运行。如果你不想照着做,完全没关系。我在这篇文章中也包含了实验图片。

一旦我们有了IPtyon notebook并运行后,我们就可以开始运行代码并做预测了!在这里,我会贴一些美观的图片和少量的代码片段,但完整的代码和详细细节可以在这里查看。

我们将使用一个名叫GoogLeNet的神经网络,它在LSVRC 2014 多个竞赛中胜出。正确分类是在耗费94%时间的前5大网络猜测中。这是我读过的那篇论文的网络。(如果你想要一个很好的阅读,你可以阅读一下人类不能比GoogLeNet做得更好这篇文章。神经网络真的很神奇。)

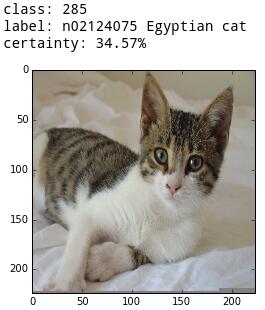

首先,让我们使用网络对一只可爱的kitten进行分类:

下面是对kitten进行分类的代码:

image = "/tmp/kitten.png"

# preprocess the kitten and resize it to 224x224 pixels

net.blobs["data"].data[...] = transformer.preprocess("data", caffe.io.load_image(image))

# make a prediction from the kitten pixels

out = net.forward()

# extract the most likely prediction

print("Predicted class is #{}.".format(out["prob"][0].argmax()))

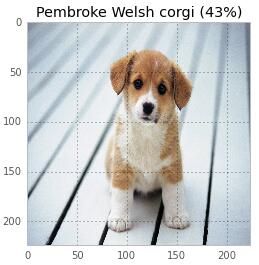

就这些!仅仅只需3行代码。同样,我可以对一只可爱的小狗进行分类!

原来这只狗不是柯基犬,只是颜色非常相似。这个网络对狗的了解果真比我还多。

一个错误是什么样的(以女王为例)

做这项工作时最有趣的事情是,我发现了神经网络认为英国女王戴在她的头上。

所以,现在我们看到网络做了一件正确的事,同时我们也看到它在不经意间犯了一个可爱的错误(女王戴的是浴帽)。现在...我们让它故意去犯错误,并进入它的核心。

故意犯错误

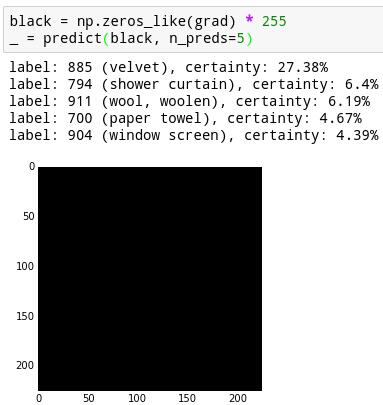

在真正理解其工作原理之前,我们需要做一些数学变换,首先让我们看看它对黑色屏幕的一些描述。

这张纯黑色图像被认为是天鹅绒的概率是27%,被认为是纸巾的概率为4%。还有一些其它类别的概率没有列出来,这些概率之和为100%。

我想弄清楚如何让神经网络更有信心认为这是一个纸巾。

要做到这一点,我们需要计算神经网络的梯度。也就是神经网络的导数。你可以将这看作是一个方向,让图像在这个方向上看起来更像一张纸巾。

要计算梯度,我们首先需要选择一个预期的结果来移动方向,并设置输出概率列表,0表示任何方向,1表示纸巾的方向。反向传播算法是一种计算梯度的算法。我原以为它很神秘,但事实上它只是一个实现链式法则的算法。

下面是我编写的代码,实际上非常简单!反向传播是一种最基本的神经网络运算,因此在库中很容易获得。

def compute_gradient(image, intended_outcome):

# Put the image into the network and make the prediction

predict(image)

# Get an empty set of probabilities

probs = np.zeros_like(net.blobs["prob"].data)

# Set the probability for our intended outcome to 1

probs[0][intended_outcome] = 1

# Do backpropagation to calculate the gradient for that outcome

# and the image we put in

gradient = net.backward(prob=probs)

return gradient["data"].copy()

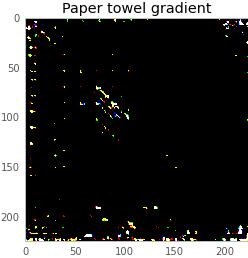

这基本上告诉了我们,什么样的神经网络会在这一点上寻找。因为我们处理的所有东西都可以表示为一个图像,下面这个是compute_gradient(black, paper_towel_label)的输出,缩放到可见比例。

现在,我们可以从我们的黑色屏幕添加或减去一个非常明亮的部分,使神经网络认为我们的图像或多或少像一张纸巾。由于我们添加的图像太亮(像素值小于1 / 256),所以差异完全看不到。下面是这个结果:

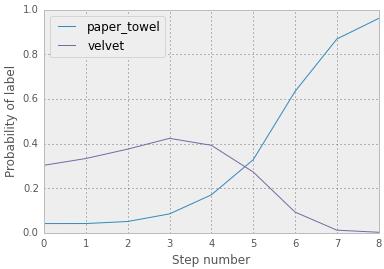

现在,神经网络以16%的概率肯定我们的黑色屏幕是一张纸巾,而不是4%!真灵巧。但是,我们可以做的更好。我们可以采取走十个小步来构成一个有点像纸巾的每一步,而不是在纸巾的方向直接走一步。你可以在下面看到随时间变化的概率。你会注意到概率值与之前的不同,因为我们的步长大小不同(0.1,而不是0.9)。

最后的结果:

下面是构成这张图像的像素值!他们都从0开始,而且你可以看到,我们已经转换了它们,使其认为该图像就是纸巾。

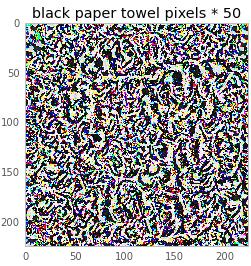

我们还可以用50乘以这个图像从而获得一个更好的图像感知。

对我来说,这看起来并不像一块纸巾,但对你可能就像。我猜测图像的所有漩涡都戏弄了神经网络使其认为这是一张纸巾。这牵扯到基本的概念证明和一些数学原理。马上我们就要接触更多的数学知识了,但首先我们来玩点有趣的。

玩转神经网络

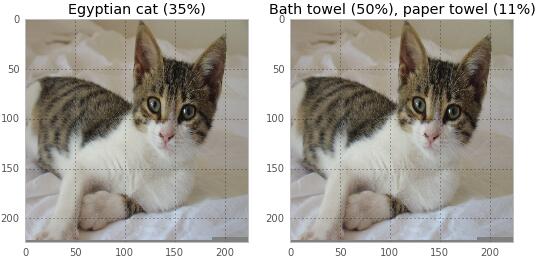

一旦我理解了这个,它就会变得非常有趣。我们可以换一只猫变成浴巾:

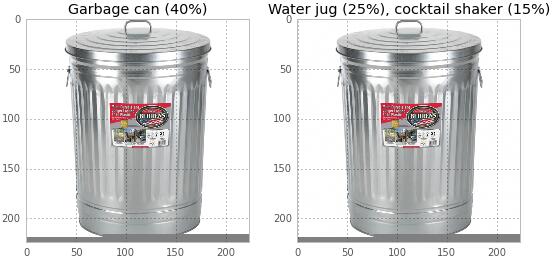

一个垃圾桶可以变成一个水壶/鸡尾酒调酒器:

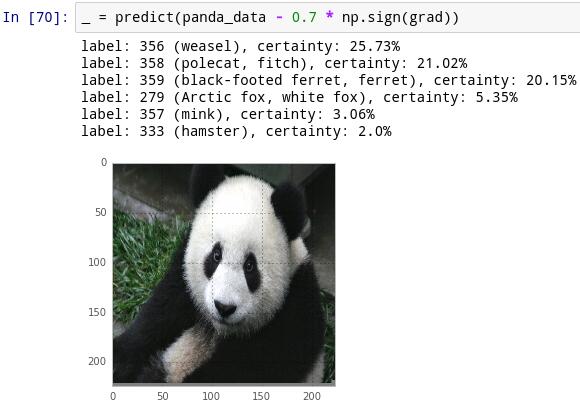

一只熊猫可以变成秃鹫。

这张图表明,在将熊猫认为是秃鹰的100步内,其概率曲线转变地很迅速。

你可以查看代码,让这些工作在 IPython notebook中运行。真的很有趣。

现在,是时候多一点数学原理了。

如何工作:逻辑回归

首先,让我们讨论一种最简单的图像分类方法——逻辑回归。什么是逻辑回归?下面我来试着解释下。

假设你有一个线性函数,用于分类一张图像是否是浣熊。那么我们如何使用线性函数呢?现在假设你的图像只有5个像素(x1,x2,x3,x4,x5),取值均在0和255之间。我们的线性函数都有一个权重,比如取值为(23, - 3,9,2, 5),然后对图像进行分类,我们会将得到像素和权重的内积:

result=23x1−3x2+9x3+2x4−5x5

假设现在的结果是794。那么794到底意味着它是浣熊或者不是呢?794是概率吗?794当然不是概率。概率是一个0到1之间的数。我们的结果在−∞到∞之间。人们将一个取值在−∞到∞之间的数转为一个概率值的一般方法是使用一个叫做logistic的函数:S(t)=1/(1+e^(-t))

此函数的图形如下所示:

S(794)的结果基本为1,所以如果我们从浣熊的权重得到794,那么我们就肯定它100%是个浣熊。在这个模型中——我们先使用线性函数变换数据,然后应用逻辑函数得到一个概率值,这就是逻辑回归,而且这是一种非常简单流行的机器学习技术。

机器学习中的“学习”主要是在给定的训练集下,如何决定正确的权重(比如(23, - 3,9,2, 5)),这样我们得到的概率值才能尽可能的好。通常训练集越大越好。

现在我们理解了什么是逻辑回归,接下来让我们讨论下如何打破它吧!

打破逻辑回归

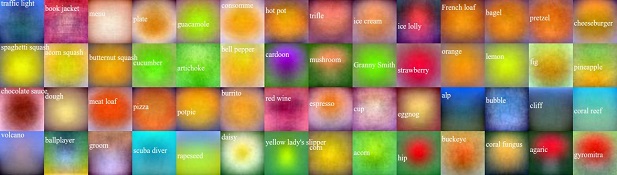

这有一篇华丽的博文,Andrej Karpathy发表的Breaking Linear Classifiers on ImageNet,解释了如何完美地打破一个简单线性模型(不是逻辑回归,而是线性模型)。后面我们将使用同样的原理来打破神经网络。

这有一个例子(来自Karpathy的文章),一些区分不同食物,鲜花以及动物的线性分类器,可视化为下图。

你可以看到“Granny Smith”分类器基本上是问“是绿色么?”(并不是以最坏的方式来找出!),而“menu”分类器发现菜单通常是白色。Karpathy 对其解释的非常清楚:

例如,苹果是绿色的,所以线性分类器在所有的空间位置中,绿色通道上呈现正权值,蓝色和红色通道上呈现负权值。因此,它有效地计算了中间是绿色成分的量。

所以,如果我想要让Granny Smith分类器认为我是一个苹果,我需要做的是:

找出图中哪一个像素点最关心绿色

给关心绿色的像素点着色

证明!

所以现在我们知道如何去欺骗一个线性分类器。但是神经网络并不是线性的,它是高度非线性的!为什么会相关呢?

如何工作:神经网络

在这我必须诚实一点:我不是神经网络专家,我对神经网络的解释并不会很出色。Michael Nielsen写了一本叫做《Neural Networks and Deep Learning》的书,写的很好。另外,Christopher Olah的博客也不错。

我所知道的神经网络是:它们是函数。你输入一张图像,你会得到一个概率列表,对每个类都有一个概率。这些是你在这篇文章中看到的图像的数字。(它是一只狗吗?不。淋浴帽?也不是。一个太阳能电池?YES!!)

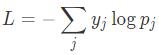

因此,一个神经网络,就像1000个函数(每个概率对应一个)。但1000个函数对于推理来说非常复杂。因此,做神经网络的人,他们把这1000个概率组合并为一个单一的“得分”,并称之为“损失函数”。

每个图像的损失函数取决于图像实际正确的输出。假设我有一张鸵鸟的图片,并且神经网络有一个输出概率Pj,其中j=1...1000,但对于每只鸵鸟我想要得到的是概率yj。那么损失函数为:

假设与“鸵鸟”对应的标签值是700,那么y700=1,其它的yj就为0,L=-logp700。

在这里,重点是要理解神经网络给你的是一个函数,当你输入一张图像(熊猫),你会得到损失函数的最终值(一个数,如2)。因为它是一个单值函数,所以我们将该函数的导数(或梯度)赋值给另一张图像。然后,你就可以使用这个图像来欺骗神经网络,也就是用我们在这篇文章前面讨论的方法!

打破神经网络

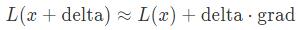

下面是关于如何打破一个线性函数/逻辑回归与神经网络的关系!也就是你一直在等待的数学原理!思考下我们的图像(可爱的熊猫),损失函数看起来像:

其中,梯度grad等于∇L(x)。因为这是微积分。为了让损失函数的变化的更多,我们要较大化移动的delta和梯度grad两者的点积。让我们通过compute_gradient()函数计算梯度,并把它画成一个图片:

直觉告诉我们需要做的是创建一个delta,它重点强调神经网络认为重要的图像像素。现在,假设grad为(−0.01,−0.01,0.01,0.02,0.03).

我们可以取delta=(−1,−1,1,1,1),那么grad⋅delta的值为0.08.。让我们尝试一下!在代码中,就是delta = np.sign(grad)。当我们通过这个数量移动时,果然–现在熊猫变成黄鼠狼了。

但是,这是为什么呢?让我们来思考下损失函数。我们开始看到的结果显示,它是熊猫的概率为99.57%。−log(0.9957)=0.0018。非常小!因此,添加一个delta倍会增加我们的损失函数(使它不像熊猫),而减去一个delta倍会减少我们的损失函数(使它更像熊猫)。但事实正好相反!我对这一点还是很困惑。

你欺骗不了狗

现在我们了解了数学原理,一个简短的描述。我还尝试去欺骗网络,让它识别先前那只可爱的小狗:

但对于狗,网络会强烈地抵抗将其归类为除狗之外的东西!我花了一些时间试图让它相信那只狗是一个网球,但是它仍然是一只狗。是其它种类的狗!但仍然还是一只狗。

我在一个会议上遇到了Jeff Dean(他在谷歌做神经网络工作),并向他请教了这一点。他告诉我,这个网络在训练集中有一堆狗,比熊猫多。所以他假设是要训练更好的网络来识别狗。似乎有道理!

我认为这非常酷,这让我觉得训练更较精确的网络更有希望。

关于这个话题还有另一件更有趣的事情–当我试图让网络认为熊猫是一只秃鹫时,它在中间花了一点时间去思考它是否是鸵鸟。当我问Jeff Dean关于熊猫和狗这个问题时,他随口提到了“熊猫鸵鸟空间”,而我并没有提到让网络认为熊猫是秃鹫时曾思考过它是否是鸵鸟。这真的很酷,他用数据和这些网络花足够的时间一下子就清楚地知道鸵鸟和熊猫以某种关系紧密地结合在一起。

更少的神秘感

当我开始做这件事的时候,我几乎不知道什么是神经网络。现在我可以使它认为熊猫是一只秃鹰,并看到它是如何聪明的分类狗,我一点点的了解他们。我不再认为谷歌正在做的很神奇了,但对于神经网络我仍然很疑惑。有很多需要学习!使用这种方式去欺骗它们,会消除一些神秘感,并且现在对它们的了解更多了。

相信你也可以的!这个程序的所有代码都在(neural-networks-are-weird)这个仓库中。它使用的是Docker,所以你可以轻易地安装,而且你不需要一个GPU或是新电脑。这些代码都是在我这台用了3年的老GPU笔记本上运行的。

想要了解更多,请阅读原论文:Explaining and Harnessing Adversarial Examples。论文内容简短,写得很好,会告诉你更多本文没提及到的内容,包括如何使用这个技巧建立更好的神经网络!

最后,感谢Mathieu Guay-Paquet, Kamal Marhubi以及其他在编写这篇文章帮助过我的人!

译者简介:刘帝伟,中南大学软件学院在读研究生,关注机器学习、数据挖掘及生物信息领域。

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4321.html

摘要:论文可迁移性对抗样本空间摘要对抗样本是在正常的输入样本中故意添加细微的干扰,旨在测试时误导机器学习模型。这种现象使得研究人员能够利用对抗样本攻击部署的机器学习系统。 现在,卷积神经网络(CNN)识别图像的能力已经到了出神入化的地步,你可能知道在 ImageNet 竞赛中,神经网络对图像识别的准确率已经超过了人。但同时,另一种奇怪的情况也在发生。拿一张计算机已经识别得比较准确的图像,稍作调整,...

摘要:言简意赅地说,我们的这款即时视觉翻译,用到了深度神经网络,技术。您是知道的,深度学习的计算量是不容小觑的。因为如果字符扭曲幅度过大,为了识别它,神经网络就会在过多不重要的事物上,使用过高的信息密度,这就大大增加深度神经网络的计算量。 前几天谷歌更新了它们的翻译App,该版本有诸多提升的地方,其中较大的是提升了所谓字镜头实时视频翻译性能和通话实时翻译性能。怎么提升的呢?字镜头技术首创者、Goo...

摘要:解决办法是多层神经网络,底层神经元的输出是高层神经元的输入。这个例子中特征的形状称为异或,这种情况一个神经元搞不定,但是两层神经元就能正确对其进行分类。年多伦多大学的等人构造了一个超大型卷积神经网络,有层,共万个神经元,千万个参数。 0. 分类神经网络最重要的用途是分类,为了让大家对分类有个直观的认识,咱们先看几个例子:垃圾邮件识别:现在有一封电子邮件,把出现在里面的所有词汇提取出来,送进一...

阅读 1459·2021-11-17 09:33

阅读 3053·2021-10-13 09:39

阅读 2720·2021-10-09 10:01

阅读 2478·2021-09-29 09:35

阅读 3942·2021-09-26 10:01

阅读 3538·2019-08-26 18:37

阅读 3169·2019-08-26 13:46

阅读 1930·2019-08-26 13:39