资讯专栏INFORMATION COLUMN

摘要:深度神经网络能够焕发新春,大数据功不可没,然而大数据的版权是否应当延伸到深度学习产生的知识,这是一个现实的问题。要获得有用的学习效果,大型多层深度神经网络又名深度学习系统需要大量的标签数据。

深度神经网络能够焕发新春,大数据功不可没,然而大数据的版权是否应当延伸到深度学习产生的知识,这是一个现实的问题。本文通过ImageNet可视化大数据、Caffe共享深度学习模型和家中训练三个场景审查了深度学习的权值与大数据的关系,介绍了目前的问题和解决方案。文章最后预测深度学习将来可能需要相关的“AI法”。

要获得有用的学习效果,大型多层深度神经网络(又名深度学习系统)需要大量的标签数据。这显然需要大数据,但可用的可视化大数据很少。今天我们来看一个非常著名的可视化大数据来源地,深入了解一下训练过的神经网络,然后扪心自问一些关于数据/模型所有权的问题。接下来,我们需要牢记一个基本的问题:一个学习过的神经网络的权值是输入图像的衍生品吗?换句话说,当一个深度学习系统使用过你的数据之后,谁应该拥有什么?

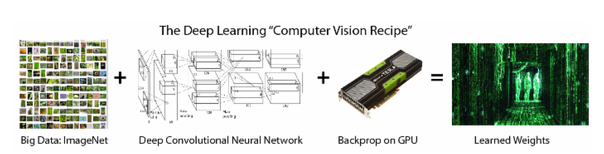

背景:深度学习“计算机视觉秘诀”

现今最成功的机器学习技术之一是深度学习。深度学习引起广泛关注的原因是由于它在处理语音[1]、文本[2]和图像[3]等任务中展现出来的显著成果。深度学习和物体识别(object recognition)技术率先在学术界萌芽(多伦多大学、纽约大学、斯坦福大学、加州大学伯克利分校、麻省理工学院和CMU等),然后被工业界采用(谷歌、Facebook和Snapchat等),现在新兴的创业团队们(Clarifai.com、Metamind.io和Vision.ai等)正将可视化智能(visual intelligence)带到公众的面前。虽然人工智能的走向仍不清晰,但是深度学习将会扮演一个关键角色。

在可视化物体识别任务中,最常用的模型是卷积神经网络(也称为ConvNets或CNNs)。它们可以在不使用手工选取特征引擎的情况下来进行端对端的训练,但是这需要大量的训练图片(有时候称为大数据,或者可视化大数据)。这些大型的神经网络从一个空白模型开始,使用一种高度优化的反向传播算法进行端对端的训练。反向传播算法不过是在微积分101课程中学到的链式法则,并且现在的深度神经网络训练算法同二十世纪80年代的算法几乎没什么不一样。但是今天高度优化的BP的实现是基于GPU的,它能够处理的数据量远多于互联网、云、GPU时代之前的神经网络。深度学习的训练结果是一些权值的集合,这些学习过的权值代表的是模型架构中不同层上的权值——用浮点数表示的这些上百万个的权值代表了从图像中学到的内容。那么,关于这些权值,其中有趣的是什么呢?有趣的是权值和大数据之间的关系,现在,这种关系将受到审查。

“基于ImageNet训练后的神经网络权值是ImageNet的衍生品吗?是数以百万计的版权声明的‘污水坑’吗?通过训练来逼近另外一个ImageNet网络的神经网络又算是什么?”(这个问题在HackerNews上被提出,出自kastnerkyle对文章“ A Revolutionary Technique That Changed Machine Vision”的评论。)

在计算机视觉的背景下,这个问题确实引起了我的兴趣,因为我们开始看到机器人和装备了人工智能技术的设备进入到了我们的家园中。我希望这个问题在未来的十年中受到更多更深的重视。现在先让我们看看在2015年中正在解决的一些问题吧。

1.ImageNet:非商业化的可视化大数据

让我们先看一下一个在深度学习系统中最常用的数据源——ImageNet[4],这个数据源设计的目的是用于识别大量的不同物体。对于研究大规模物体识别和检测的学者来讲,ImageNet是较大的可视化大数据。2009年,该数据集出现在由Fei-Fei Li研究团队发表的一篇CVPR文章中,之后,该数据集取代了PASCAL数据集(这个数据集样本的数量和多样性不够)和LabelMe数据集(这个数据集样本缺乏标准化)。ImageNet数据集脱胎于Caltech101(2004年的一个数据集,侧重于图像分类,同样由Fei-Fei Li团队研发),所以我个人还是认为ImageNet是类似“Stanford10 ^ N”的。ImageNet在推动物体识别到一个新的领域——深度学习阶段起到了核心的作用。

截止到2015年5月1日,ImageNet数据库拥有超过1500万的图像。

问题:有很多非常大的数据集,其图像是从网上采集的,但是这些图像通常都带有自己的版权。版权阻止了图像的收集和出售,所以从商业角度来看,当产生这样的数据集的时候,必须要小心一些。为了使现实世界中识别问题保持较先进技术,我们必须使用标准的大数据集(代表了能够在现实网络中找到的内容),培养一种共享成果的社区意识,并且维持数据源的版权。

解决方案:ImageNet决定公开提供数据集中图像的源链接,这样人们就可以不必从一个大学托管的服务器上来下载这些图像了。ImageNet仅提供图像的缩略图和一个版权侵犯删除声明。只有当使用者签署协议,保证不将数据商业化使用之后,数据集组织者才提供完整的数据集。ImageNet具有下述的声明条款(获取日期:2015年5月5日):

ImageNet不拥有图像的版权。ImageNet会以一种图像搜索引擎的方式,仅提供缩略图和图像的URL。也就是说,ImageNet针对每个同义词集编译了一个较精确的网络图片列表。对于希望将图片用于非商业化研究和/或教育目的的研究人员和教育工作者来说,在同意我们的一定条件和条款的情况下,我们可以提供通过我们的网站来进行访问的方式。

2.Caffe:无使用限制的深度学习模式

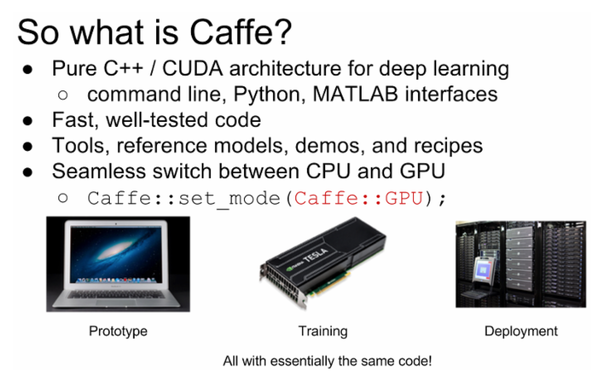

现在,比较明确的是,我们知道哪里可以下载到可视化大数据以及它们适用的条款,我们再将目光转向另一个方面:深度学习训练过程的输出结果。我们看一下Caffe,一个非常流行的深度学习库,它可以用来处理类似于ImageNet的数据。Caffe提供了一个共享模式的生态系统(动物园模型),并且已经成为计算机视觉研究者必不可少的工具。Caffe是伯克利视觉和学习中心研发的,并贡献给了开源社区——它是开源的。

“使用Caffe自己动手搭建深度学习计算机视觉”中的一页幻灯片

问题:作为一个在大学启动的项目,Caffe旨在成为创建、训练和分享深度学习模型的事实标准。分享的模型最初是用于非商业用途,但问题是一波新的初创企业都使用了这些技术。所以必须有一个许可协议,允许高校、大型企业和初创公司来探索同一套预训练模型。

解决方案:Caffe的当前模型许可是无使用限制的。对于大量的黑客、科学家和工程师们来说这是非常伟大的一件事。需要分享的模型需遵守一项非商业使用条款。下面是全部的Caffe的模型条款(获取日期:2015年5月5日):

Caffe模型是BVLC的附属软件,它没有使用的限制。

这些模型利用了ImageNet项目的数据进行训练,这些训练数据包括了一些从网上获取的照片,而这些照片可能受到版权保护。

作为研究者,我们目前的理解是:对于这些公开发布的训练过的模型权值,其使用不应受到什么限制,因为这里面没有包含任何原始图像的全部或者部分。对于现在兴起的一种说法,‘权值系由原始图像训练所得,其版权应归属原始图像版权所有者’,加州大学伯克利分校没有做过任何声明说什么样的使用是被允许的,而是基于大学使命来对待我们的模型,以尽可能不受限制的方式来传播知识和工具。

3.Vision.ai:在家里生成和训练的数据集

深度学习能够学习输入数据的概要。但是如果另一个不同的模型记住了训练数据的详细细节会怎样呢?更重要的是如果模型记住的内容中有你不想对外分享的内容会怎样呢?为了研究这种情况,我们来看Vision.ai,他们设计的实时计算机视觉服务器用于模拟产生一个数据集并且学习一个对象的外观。Vision.ai软件能够从视频和直播的网络摄像头流中实时训练。

不同于从互联网上的图像中收集可视化大数据(如ImageNet),vision.ai的训练过程基于一个人在网络摄像头面前挥舞一个感兴趣的对象。用户自力更生的学习过程一开始有一个初始边界框,算法会在不用干预的情况下持续学习。在算法学习过程中,它会存储它以前见到的部分历史信息,从而有效地创建自己的数据集。因为Vision.ai使用了卷积神经网络来检测物体(图像中目标仅占据很少的一部分),所以收集到的数据集中还保持了大量的背景数据。当训练过程结束后,你同时得到了Caffe类型的信息(学习过的权值)和ImageNet类型的信息(收集的图像)。那么如果现在进行分享模型,会发生什么呢?

用户使用vision.ai的实时检测器训练接口来训练茶杯检测器

问题:在家里的训练意味着潜在的私人信息和敏感信息以背景的形式被采集到图像中。如果你在自己家里训练模型,然后对公众开放它,那你在分享的时候就需要三思而后行了。同样的,你如果从有版权保护的视频/图像中训练了一个物体检测器,那么当你分享/出售这个模型的时候,也需要考虑其中存在的问题。

解决方案:当你把一个Vision.ai模型保存到磁盘上的时候,你能获取到编译模型和完整模型。编译模型是不包含图像的完整模型(因此小的多)。这就允许你在自己的电脑上保留完整的可编辑模型,而只需要分享编译模型即可(特别是只发布训练过的权值),这就避免了别人来偷窥你的生活空间。Vision.ai的计算机视觉服务器称为VMX,它既能够运行完整模型,也能够运行编译模型;然而,只有非编译模型能够编辑和扩展。另外,Vision.ai提供的是视觉服务器的独立安装模式,因此训练图像和计算结果可以保留在本地计算机上。简而言之,Vision.ai的解决方案允许你选择在本机运行还是在云上运行,并且允许你选择是发布完整模型(具有背景图像)还是编译模型(仅有需要检测的对象)。当需要分享训练模型和/或产生数据集的时候,你就能够自由的选择自己的许可协议。

4.授权基于内存的机器学习模型的开放问题

深度学习方法并不是物体识别的可用技术。如果我们的模型是使用原始RGB像素的最近邻分类器(Nearest Neighbor Classifier )会怎样?最近邻分类器是基于内存的分类,它记忆所有的训练数据——模型就是训练数据。如果对同一数据集使用不同的许可,将会产生矛盾,因为某天它可能作为训练数据,而其他的时候又可能是做为学习算法的输出数据了。我不知道是否有一种方法可以调和那种来自ImageNet的非商业使用限制许可和来自Caffe深度学习模型的完全不受限制许可。是否有可能有一个黑客友好的数据模型/许可协议来统一所有的情况?

结论

如果将来神经网络升级成为你的操作系统的一部分,不要感到惊讶。当我们从数据经济(共享图片)向知识经济(共享神经网络)过渡的时候,法律/所有权问题就成为了一个需要考虑的问题了。我希望今天描述的三种场景(可视化大数据、共享深度学习模型、家中训练)可以在你想要分享知识的时候,帮助你思考这里面的法律问题。当AI开始生成自己的艺术(可能通过重新合成老照片),法律问题会出现。当你的竞争对手出售你的模型和/或数据的时候,法律问题再次出现。如果MIT协议、GPL协议和Apache协议针对预训练深度学习模型开始展开争论的时候,也不要感到吃惊。谁知道呢,或许AI法将是接下来的大事件呢。

参考文献:

[1] Deep Speech: Accurate Speech Recognition with GPU-Accelerated Deep Learning

[2]Text Understanding from Scratch

[3]ImageNet Classification with Deep Convolutional Neural Networks

[4]A Large-Scale Hierarchical Image Database

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4316.html

摘要:三大牛和在深度学习领域的地位无人不知。逐渐地,这些应用使用一种叫深度学习的技术。监督学习机器学习中,不论是否是深层,最常见的形式是监督学习。 三大牛Yann LeCun、Yoshua Bengio和Geoffrey Hinton在深度学习领域的地位无人不知。为纪念人工智能提出60周年,的《Nature》杂志专门开辟了一个人工智能 + 机器人专题 ,发表多篇相关论文,其中包括了Yann LeC...

摘要:在每一层学习到的结果表示作为下一层的输入用监督训练来调整所有层加上一个或者更多的用于产生预测的附加层当前,国外在这方面的研究就是三分天下的局面,的与微软合作,的和合作,以及的计算机科学家和。深度学习的入门材料。 转载自:http://doctorimage.cn/2013/01/04/%e5%85%b3%e4%ba%8e%e6%b7%b1%e5%ba%a6%e5%ad%a6%e4%b9%a0...

阅读 2862·2021-09-28 09:45

阅读 1527·2021-09-26 10:13

阅读 930·2021-09-04 16:45

阅读 3688·2021-08-18 10:21

阅读 1114·2019-08-29 15:07

阅读 2656·2019-08-29 14:10

阅读 3168·2019-08-29 13:02

阅读 2484·2019-08-29 12:31