资讯专栏INFORMATION COLUMN

摘要:深度学习现在被视为能够超越那些更加直接的机器学习的关键一步。的加入只是谷歌那一季一系列重大聘任之一。当下谷歌醉心于深度学习,显然是认为这将引发下一代搜索的重大突破。移动计算的出现已经迫使谷歌改变搜索引擎的本质特征。

Geoffrey Hiton说:“我需要了解一下你的背景,你有理科学位吗?”

Hiton站在位于加利福尼亚山景城谷歌园区办公室的一块白板前,2013年他以杰出研究者身份加入这家公司。Hiton也许是全世界研究神经网络系统最早的专家,在1980年代中期,他就是人工智能技术的先驱(他提到在16岁时就开始思考神经网络)。自那时起,以模拟人脑为原理的神经网络被认为是一种在处理计算机视觉和自然语言等棘手问题方面很有前途的方法。但渐渐有人失去了等待的耐心,人们开始质疑是否应该继续下去。

Geoff Hinton. Photo: Michelle Siu/Backchannel

大约十年前,在多伦多大学Hinton的实验室,他和其他研究者取得了一项突破性进展,突然使神经网络成为人工智能领域最热门的话题。不仅是谷歌,还有一些其他公司,比如,Facebook、Microsoft和IBM都开始疯狂追求这个领域中为数不多的科学家,他们精通于建立多层模拟神经元结构以使整个系统能够被训练,或者进行自我训练,然后来预测随机输入值的相干性。这更像是一个婴儿,他学着对那些涌入到其初始感官的数据进行组织。这种新的、有效的处理方式被称作深度学习,一些长期计算难题(比如说计算机“观看”和“听到”的能力等)得以解决。我们翘首期盼的拥有智能的计算机系统突然出现在我们面前,此后谷歌搜索将会变得更加好用。

深度学习的突破对谷歌搜索的下一次跨越式发展极其关键:理解真实世界,在为用户提供准确答案和信息方面向前迈出一大步。为保持搜索的活力,谷歌必须变得更加聪明。

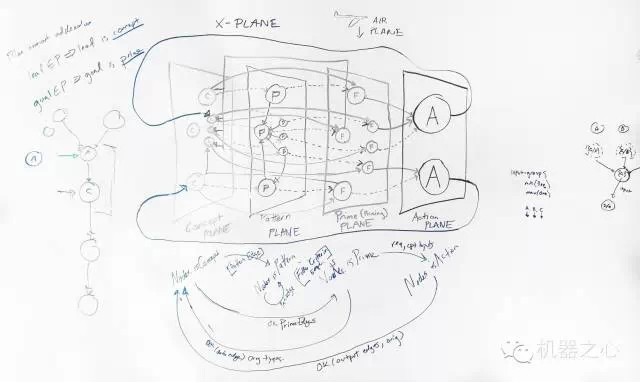

Here’s Dr. Hinton’s explanation for English majors. Photo: Steven Levy

这正中谷歌下怀。在公司早些年,创始人就认定谷歌是一家人工智能公司。它不仅将人工智能用于搜索——尽管它的搜索引擎与人工智能正相关——还用于广告系统、自动驾驶汽车,以及将纳米颗粒注入人体血管来进行早期疾病监测的计划中。正如Larry Page在2002年告诉我的:

“我们不总是生产人们想要的东西,这才是我们工作的难点所在。要实现这个目标,你必须足够聪明,你要了解世界万物,你必须懂得去质疑。我们正在尝试的就是人工智能——最终搜索引擎会很聪明,因此,我们正在努力接近这个目标。”

当Geoffrey Hiton实现这个突破时,谷歌已经做好准备走上这条道路。多年以来,公司一直通过使用机器学习这种更传统的方式来使搜索引擎变得更加强大,而且在这方面遥遥领先。曾经有几年,公司雇佣了一群人工智能工程师和科学家,他们使搜索引擎像synonyms一样学习。当数百万用户用到一个可以进行替换的词语(比如,dog和puppy)时,谷歌能迅速利用知识来更好的理解问题。当谷歌承担网站翻译工作时,它的科学家们会将储备的大量翻译过的文档和来源放入系统。这样,谷歌搜索引擎就“学会”了如何将一种语言匹配到另一种。

深度学习现在被视为能够超越那些更加直接的机器学习的关键一步。它基于人脑结构,它的追随者声称,之前基于计算机特性实现智能几乎是不可能的——至少非常难,但深度学习为其提供了发射台。这就是为什么Hinton的突破会对谷歌如此重要,对于其他有搜索或类似业务的公司也是如此。过去几年,谷歌一直努力将搜索引擎塑造成吸引讨论的话题。但真正使计算机获得初级的、人类般的智能还是需要对人工智能的前沿研究进行扩展,深度学习就是这样一个能够完成这项任务的当下最流行的工具。

神经网络是对生物上大脑学习方式进行建模。当你尝试进行一个新任务时,一系列特定的神经元集合会被激活。你观察到结果,接下来利用反馈来调整哪些神经元应该被激活,以此来训练大脑。多次之后,一些神经元之间的联系将变强而另外一些则变弱,这就形成了记忆的基础。

模拟神经网络以编码方式在本质上复制了这一过程。但比起复制人脑复杂的神经元结构,模拟神经网络更小,神经元也是整齐的分层排列。第一层(或者最初基层)是特征探测,一种人类感官的计算形态。当计算机将数据输入到神经网络——比如说图像、语言或文本文件的数据库——系统通过检测其中的特征值来进行学习。例如,如果任务是识别垃圾邮件,神经网络研究者可能会将许多信息输入到系统,同时贴上“垃圾邮件”及“非垃圾邮件”标签。神经网络将自动察觉到一些单词的复杂特征、模式,以及能够确定该邮件是否为垃圾邮件的标题信息。

在早期神经网络实验中,计算机不能自己设计特征,因此这些特征需要人工添加。Hinton的开创性贡献是开发了一种被称作“Back Propagation(反向传播算法)”的技术,这是一种反馈机制,它允许系统更加有效的从错误中学习以及自己定义特征。“追溯到1986年,我们首次开发出Back Propagation算法,我们因其能学习到多层的特征探测而感到兴奋,我们认为我们解决了这个问题。” Hinton说,“但在解决实际问题中却没有出现大的突破,这非常令人失望,我们完全猜错了需要的计算资源和标记案例数量。”

但是,即使多年来许多研究员不再信仰神经网络,但Hinton依然强烈感觉到它们会有实用价值。1995年,他和他的学生尝试着放弃手动添加标签,至少是学习过程的早期阶段,这项技术被称作“unsupervised pre-training”,是指该系统可以计算出如何自行组织输入值。但Hinton说完成这项工作的核心是数学技巧,一种节约计算时间的近似法,当信息通过各层神经元时将会引发更多次迭代来改善网络。如经常遇到的,速度能够变化,这使得之前神经网络无法完成的“学习”行为成为可能。就像是一个人突然冷静下来说,我能用10分钟完成5个小时的滑雪练习。

伴随着无监控学习的出现,人类专家只需要在更加后面的阶段对机器进行干预,他们是为更想要的结果添加标签并为成功的结果提供奖励。Hinton说:“想象一下小孩子,当他们学着辨认牛时,并并需要去看几百万张妈妈们标记上‘牛’的图片,他们仅仅是学习牛的样子,然后问到:‘这是什么?’ 妈妈会说:‘这是一头牛’,他们就学会了。深度学习就类似于这样。

等到Hinton团队对这一模型进行测试时,他们恰好收益于神经网络初创时尚不具备的条件——超高速图形处理器(GPU)。尽管这些芯片设计之初是用于推导高级图像的计算公式,但它们也非常适用于神经网络的计算需求。Hinton为实验室购置了一堆图形处理器,让两个学生来操作该系统。他们进行了一项测试来观察是否能让神经网络识别讲话中的音素。这自然是许多科技公司——当然,也包括谷歌——试图掌握的技术。因为语音会成为即将到来的移动时代的输入方式,电脑必须学会更好地倾听。

Geoff Hinton. Photo: Michelle Siu/Backchannel

系统表现如何呢?

“他们取得了令人激动的结果,” 辛顿表示,“最初结果几乎和当时技术一样出色,而后者已经调试发展了近30年,很显然,如果在最开始尝试中我们取得那么好的结果,我们最终的结果会更好。” 在接下来几年中,Hinton团队进行了更多严肃的尝试。等到结果发布时,Hinton称系统已经能与现存商用模型的较佳表现比肩。“关键是,这是实验室两个学生做出来的。”他说。

深度学习就此诞生。

2007年,项目进行过程中,Hinton在山景城进行了关于深度学习的谷歌技术演讲,极客们踊跃出席,这一演讲在YouTube上也大受欢迎。这有助于传播这样的理念,即神经网络将成为一个强大工具。这还掀起了一波争先恐后雇佣该领域技术专业的浪潮。Hinton的学生去了IBM、微软,当然还有谷歌。这可是攻坚该领域的四大公司中的三家(还有一家是Nuance,它是苹果的技术供应商)。所有人都能自由使用Hinton实验室的成果用以完善各自系统。“我们基本上对此毫无保留,因为我们着眼于证明我们技术的优势。” Hinton表示,“有趣的是,微软研究院和IBM先于谷歌得到这项技术,但是在将技术转变成产品方面谷歌却比任何人都迅速。”

Hinton的加入只是谷歌那一季一系列重大聘任之一。就在几个月前,人工智能的乐观主义哲学家Ray Kurzweil刚刚加入包括Peter Norvig(编写了人工智能课程的标准教科书)、Sebastian Thrun (自动驾驶汽车的主要发明者)等人工智能传奇人物在内的团队。

当下谷歌醉心于深度学习,显然是认为这将引发下一代搜索的重大突破。移动计算的出现已经迫使谷歌改变搜索引擎的本质特征。为了更进一步,它必须采取和人类认知世界相一致的方式——当然另一方面也要执行知晓世间一切并且在不到半秒钟找到这些的非凡任务。所以, Jeff Dean参与进来是迟早的事情。

Dean是谷歌的传奇人物。早在1999年加入谷歌时,他在计算机科学圈子里就已经声名远扬,聘任Dean是谷歌的一个里程碑,彼时谷歌还是个员工只有两位数相对默默无闻的互联网公司。在接下来的几年里,Dean成为构建谷歌软件基础构架的领军人物。在这一过程中,Dean粉们组建了一个极客团体,他们用恶恶搞来表达对Dean耀眼才华的崇敬,叫「关于 Jeff Dean的真相」。其中大多数都涉及超级极客的编码奥秘,但也有些相对容易理解的,比如:

Jeff Dean能在四子连珠中打败你。只需要三步。

某天 Jeff Dean出门时误将Etch-a-Sketch(一种画板,使用者通过控制两个旋钮来控制画笔在画板上的移动)当做笔记本电脑了。在他回家取笔记本电脑的路上,他对画板进行了编程用其来玩俄罗斯方块。

Jeff Dean仍在等待数学家们解开他藏在数字π中的笑话。

现年46岁的Dean早已知晓神经网络,他在本科论文项目就曾应用过它。然而在随后的几年,他和大部分同行得出了相似的结论:神经网络的黄金时期尚未到来。“神经网络前途无量,但因为我们尚没有足够的计算能力使其一鸣惊人,神经网络一度销声匿迹。" Dean说到。不过在2011年, Jeff Dean在谷歌一间茶水间遇见了吴恩达(Andrew Ng)。吴恩达是斯坦福的人工智能教授,人工智能领域的巨擘,他每周会花上一天时间呆在这家搜索引擎公司。Dean问吴恩达在忙些什么,吴恩达的回答令他大吃一惊——“我们在试图训练神经网络”。吴恩达告诉Dean,风头已变,伴随着深度学习领域的突破,神经网络表现颇佳,如果谷歌能掌握训练大型网络的技巧,会发生奇迹。

Jeff Dean. Photo: Talia Herman/Backchannel

Dean认为这听上去很有意思,在“涉足”六个月后开始相信,建立一个庞大神经网络系统能够很快取得实质性成果。因此他和吴恩达将其变成了一个独立项目。(吴恩达已经离开谷歌,就在最近加入了百度,以发展中国搜索引擎领导者——百度自己的人工智能项目。)

大约用了一年时间,该项目俗称为“谷歌大脑”,立项于Google X——谷歌公司高瞻远瞩的研究部门。“这是我们内部开玩笑的叫法,我们尽量不这么对外宣称,毕竟听起来有点奇怪”,Dean说。2012年,研究积累了一定成果后,项目组走出了纯试验部门——Google X ,转移到搜索部门。项目组也开始避免使用“大脑”一词。在对外宣传中,他们更青睐“谷歌深度学习项目”这个名字,虽然这个名称听起来没有“大脑”有深意,但这也不太可能导致有人在Googleplex(谷歌总部)门前示威抗议。

Dean表示,项目组最开始尝试的是无监督学习(unsupervised learning),因为“这个世界上监控外的数据远多于监控下的数据”。这反映在Dean项目组的第一篇论文中,在这项实验中谷歌大脑(覆盖了1.6万个多个微处理器,创建了一个有数十亿连接的神经网络)观看了千万数量级的YouTube图像,以试图观察该系统能否学会将其所见到的定义出来。没有发生意外,有赖于YouTube的内容,该系统自发辨识出了猫,并且相当擅长于许多普通用户通常会做的事情——搜索猫科动物明星的视频。“在训练中,我们从未告诉它(谷歌大脑)‘这是一只猫’”,Dean告诉《纽约时报》,“基本上可以说,它发明了猫这个概念。”

而这只是观察系统能做些什么的测试之一。很快,深度学习项目组建了一个更加强大的神经网络,并且开始承担类似语音识别的任务。“我们的研究项目集合相当棒,在一些中短期项目中,系统对事物的超凡理解能力能迅速提升产品性能。还有一些中长期目标,对此我们脑海里没有一个具体的产品,但是我们知道这些将会非常有用。”

在我访谈Dean后不久,一个例子就出现了,4位谷歌深度学习科学家发表了一篇名为《展示与讲述》的论文。这不仅标志着一个科学突破,更催生了谷歌搜索旗下的一个应用。这篇论文介绍了“神经图片标题生成器”(neural image caption generator,NIC ),旨在没有人类介入的情况下为图片列示标题。可以说这个系统充当了报纸的图片编辑。这是一项包含视觉和语言的大型实验。这个系统的非凡之处在于,它将可视化图片的学习系统建立在能够用自然语言造句的神经网络基础之上。

没有人会说这个系统已经拥有了优于人类的照片分类能力。事实上,如果雇一个基于该神经网络的人为照片写标题的话,这个网络新手可能都坚持不到午餐时间。可是这个系统在机器上却运行的出奇出色。其中一些无比准确的例子包括:一群正在玩飞盘游戏的年轻人;一个正在泥泞路上骑着摩托的人;一群正穿过干旱草地的大象。系统可以对飞盘、马路和一群大象生成自己的概念,这足以令人印象深刻。所以,当这个系统错把极限运动的单车骑士当成滑板者;或者错把淡黄色的跑车认成了校车,也是无可厚非的。毕竟这个系统还处于认识繁杂世界的萌芽期。

这只是“谷歌大脑”的起始阶段,Dean不打算对外宣称说谷歌已经拥有了世界上较大的神经网络系统,但是他承认,这是他所知道的这个领域里面的领先者。

Hinton的被雇佣以及Dean的聪明才智是公司推进深度学习的重要举措之一,而其中最重要的非2013年谷歌花费4亿美元收购Deepmind莫属,这是一家伦敦的人工智能公司。基于对大脑的深度研究,这家公司对于深度学习有着自己的独到见解。谷歌击败了它的主要竞争对手完成此次收购。正如谷歌当年花17亿美元买下YouTube,和曾经花5000万美元买下羽翼未丰的开源移动操作系统安卓,我们有充分理由相信Deepmind是谷歌捡的另一个大便宜。

CEO和创始人之一的Demis Hassabis是一个满头黑发,矮小结实的38岁男人。思路敏捷,语速之快就像播客以两倍速快进播放。“我整个事业都是在为人工智能做准备和铺垫,”他在伦敦市中心高耸的总部大楼里休息时说到,总部大楼坐落在St Pancras火车站旁。Deepmind刚刚从Bloomsbury的一幢不起眼的写字楼入驻这栋新大楼。这栋大楼之不寻常是因为它挨着一家老医院的副楼而建,有点时空穿越的不和谐感。大楼里的会议厅都是以一些著名哲学家、作家和画家命名,因为这些他们代表着是人类智慧的巨大飞跃,比如达芬奇、哥德尔、玛丽 雪莱。这个团队最近开始接手两家由Deepmind收购的以牛津大学作为实验基地的公司。一个是Dark Blue Labs,运用深度学习来解决自然语言理解问题;另外一家Vision Factory,其开发物体识别技术。

Hassabis 在14岁时就是个狂热的电脑游戏程序设计者,同时也是象棋天才,师从游戏大师Peter Molyneux,在《黑与白》和《主题公园》里程碑作品中起到了重要作用。随后在二十几岁时开始运营自己的游戏公司,有大约60名员工。但是他说游戏是一种达到目的的方式,而这个目的是一个拥有通用智能的人工智能机器的发展。直到2004年,他觉得他已经把游戏智能做到极致了,可是建立人工智能公司还是有些操之过急,因为他所需要的计算能力既不充足,也不划算。所以他在英国伦敦大学学院修了一个认知神经科学的博士学位。

2007年,有一篇关于记忆神经基础的论文被《Science》评为年度十大突破之一,他是作者之一。他成为伦敦大学学院Gatsby Computational Neuroscience Unit的一员,并与UCL,MIT和Harvard展开合作。但在2010年,他觉得是时候成立一个做高级人工智能的公司了,他和盖茨比计算神经科学组的同事Shane Legg以及19岁就从剑桥辍学的连续创业家Mustafa Suleyman一起着手创立。投资者还包括Peter Theil的Founders Fund和Elon Musk(他对后来对人工智能的不足表示过担忧),Geoffrey Hinton也是顾问之一。

DeepMind一直秘密运行,在谷歌收购之前只有一次公开的结果发布。这足以引发一场炒作狂潮,同时也伴随着一些无知的嘲笑。论文表述了DeepMind在通过被动训练神经网络来玩Atari游戏方面的成功。神经网络系统通过自身深度学习来学习游戏规则——系统直接尝试百万遍Pong, Space Invaders, Beam Rider和其他经典游戏,通过自学达到甚至超越了一个精通游戏的青少年。更有趣的是,它许多成功的策略都是人类无法想象的。“这就是此类技术的一个特殊潜能,” Hassabis说,“我们灌输给它一种能力使它像人类一样从经验中自我学习,因此,它就能自行处理那些我们都不知道该如何编程的事情。看到它想出了程序之外的Atari游戏的新策略,这非常令人激动。”

这朝着Hassabis的伟大目标又前进了一小步,他想象中的模拟大脑不仅知道大量事实,还知道接下来该怎么做。DeepMind绝不满足于开发一种只能应用在有限领域的工具,就像Atari游戏、通勤或者处理约会。他们想创造一种通行的人工智能机器,可以随时随地处理信息,并将每件事情都完成的非常漂亮。“我们现在所研究的通行人工智能是指将非结构化信息转化成有用的、可行动的知识,” 他说,“我们有模板——人类大脑。我们会系鞋带、骑自行车、会处理建筑的物理学问题。所以我们知道这是可能的,并且我们研究项目的理念正在慢慢的拓宽现有的应用领域。”这听起来是否令人害怕?Hassabis正在展望一种超级人工大脑,它能够吸收全世界的信息并将其构造成它能理解的形式,然后采取行动?至少他承认,他们团队所引领的这项先进技术可能会导致一个问题——人工智能脱离人类控制,或至少会变得足够强大,以至于它的某些功能会被限制。这就是为什么在谷歌收购DeepMind之后,Hassabis和其他创始人要求谷歌设立一个外部咨询委员会来监控公司在人工智能方面的进步。DeepMind早已决定永远不会将自己的技术授权给军方和间谍组织,他们也让谷歌同意了这一点。

遗憾的是Hassabis并没有透露委员会的组成人员,他只提到“由计算机、神经科学和机器学习领域的较高级教授组成。” 因为DeepMind的工作依然处于早期——离所谓的“奇点”还早——他告诉我们现在没有必要把委员会成员公布出来。他说:“当前不存在的议题有可能会在未来5年或者10年出现。因此,事实上,游戏刚刚开始。”

但游戏进展飞快。去年秋天,DeepMind公布的另一篇论文描述了他们的一个新项目,通过综合一些神经科学里的记忆理论来构建一个配备图灵机性能的神经网络,就像是通用计算设备。这意味着该系统在足够的时间和内存下能够计算任何事情。论文重点关注实际应用:记录信息并随后提取的能力——就像是对人类大脑“工作记忆”的人工模拟——“神经网络图灵机”比此前的神经网络有更快的学习能力,能够处理更加复杂的任务,更重要是是“拥有在训练制度之外的良好的概括能力”。这不经让我们感到,向着Hassabis那个梦想中的通用人工智能工具又迈出了关键一步。

事实上,到目前为止,谷歌深度学习的成果都还未在搜索及其他产品上大展拳脚。但这一点即将改变。

自从Jeff Dean深度学习项目的研究方向从Google X转移到Knowledge部门(包括搜索)之后,他的小组就一直和一些相关的搜索团队进行着密切合作,包括语言和图像识别。谷歌大脑已经成为该公司的一个人工智能工具。Dean说道,这就像一个内部服务,如果小组的人对某个特定问题感兴趣,他们会通过它找到正确的解决方法。他接着说到,谷歌现在有35到40个小组在使用它,除了搜索和语言,这项技术在广告、街景和自动驾驶方面都有应用。

Jeff Dean. Photo: Talia Herman/Backchannel

至于远期项目,Dean谈到他们正尝试做一个更好的实时翻译软件,这是近段时间的热点,除了当前谷歌获得高度关注的系统外,微软的Skype同样使观察者印象深刻,这一系统通过远程声音完成翻译。但是Dean还是为自己团队通过努力推动项目向前发展感到兴奋。他说,这是一个仅通过神经网络就可以实现首尾相连语言翻译的模型,你可以训练一对用两种语言表达但意义一致的句子。拿英语和法语来说,你一个词一个词的输入英语句子,然后通过一个“英语结束”的标记,这个模型会马上将其翻译成法语。

Dean在神经模型和谷歌现有系统之间进行了深入比较,结果表明他的新的深度学习系统在识别语音细节方面更胜一筹,而这被认为是语义表达的关键。Dean表示:“如果对这项技术进行扩展,未来可以做更震撼的事情。”

DeepMind同样为产品化做好了准备。Hassabis说大概需要六个月左右的时间,他们的技术就可以找到和谷歌产品实现对接的途径。他的组织被分成了几部门,其中一个和谷歌紧密合作,致力于人工智能的实际应用,该部门由它的联合创始人Mustafa Suleyman负责。

Hassabis希望DeepMind的技术能帮助人们提高生活水平。他相信一个更具积极主动性的搜索引擎——不只为人们提供答案,更能帮人们做决定——可能成为价值的提供者,它将为人们提供更为宝贵和稀缺的商品——时间。Hassabis举例说世界上可能找到的有趣的书与人有限的一生中能够读完的书相比要多很多,既然如此,为什么每次在一个漫长的飞行途中或在某地的难得度假当中都要去想该读哪本书?这将永远不会发生,因为很多类似的事情将更好的实现自动化。

沿着这个思路,Hassabis设想DeepMind能够通过自己的方式涉足谷歌更多有开创性意义的项目,比如自动驾驶汽车,甚至Calico---一个致力于延长人类寿命的公司。

最终,Deepmind、谷歌大脑连同Hinton的深度学习小组将共同组成谷歌搜索,这才是最重要的。许多年前,Larry Page 和Sergey Brin曾经半开玩笑的说,语音将被植入我们的大脑,然而现在已经没人再讨论植入了。谷歌并不是通过开发人类大脑来让搜索变的更好,他们是在建造一个只属于它自身的、独一无二的大脑。

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4295.html

摘要:几乎没有人比岁的更能与深度学习紧密地联系在一起。他于年成为纽约大学教授,并从此引领了深度学习的发展。最近,深度学习及其相关领域已然成为最活跃的计算机研究领域之一。 本文原载IEEE,作者Lee Gomes,由机器之心翻译出品,参与成员:电子羊、翬、泥泥刘、赤龙飞、郑劳蕾、流明。人工智能经历了几次低潮时期,这些灰暗时光被称作「AI寒冬」。这里说的不是那段时期,事实上,人工智能如今变得异常火热,...

摘要:生成式对抗网络简称将成为深度学习的下一个热点,它将改变我们认知世界的方式。配图针对三年级学生的对抗式训练属于你的最严厉的批评家五年前,我在哥伦比亚大学举行的一场橄榄球比赛中伤到了自己的头部,导致我右半身腰部以上瘫痪。 本文作者 Nikolai Yakovenko 毕业于哥伦比亚大学,目前是 Google 的工程师,致力于构建人工智能系统,专注于语言处理、文本分类、解析与生成。生成式对抗网络—...

摘要:我仍然用了一些时间才从神经科学转向机器学习。当我到了该读博的时候,我很难在的神经科学和的机器学习之间做出选择。 1.你学习机器学习的历程是什么?在学习机器学习时你最喜欢的书是什么?你遇到过什么死胡同吗?我学习机器学习的道路是漫长而曲折的。读高中时,我兴趣广泛,大部分和数学或科学没有太多关系。我用语音字母表编造了我自己的语言,我参加了很多创意写作和文学课程。高中毕业后,我进了大学,尽管我不想去...

摘要:有几次,人工智能死在人工神经网络上。在过去十年中,他一直在举办为期一周的有关神经网络的暑期学校,我曾经拜访过。神经网络压缩信息之后,这些信息无法复原。 魔法已经进入这个世界。如今,许多美国人口袋里装着薄薄的黑色平板,这些机器接入遥远的数字云和卫星,它们解码语言、通过摄像头观察并标记现实,挖掘个人数据,它们以某种方式理解、预测着我们的心愿。倾听、帮助着人类。因为与多伦多大学有个约会,这个夏天,...

摘要:年实验室团队采用了深度学习获胜,失败率仅。许多其他参赛选手也纷纷采用这一技术年,所有选手都使用了深度学习。和他的同事运用深度学习系统赢得了美元。深度学习,似乎是解决 三年前,在山景城(加利福尼亚州)秘密的谷歌X实验室里,研究者从YouTube视频中选取了大约一千万张静态图片,并且导入到Google Brain —— 一个由1000台电脑组成的像幼儿大脑一样的神经网络。花费了三天时间寻找模式之...

阅读 2470·2021-10-11 10:57

阅读 1334·2021-10-09 09:59

阅读 2041·2019-08-30 15:53

阅读 3244·2019-08-30 15:53

阅读 1047·2019-08-30 15:45

阅读 777·2019-08-30 15:44

阅读 3488·2019-08-30 14:24

阅读 989·2019-08-30 14:21