资讯专栏INFORMATION COLUMN

回顾2012,更多开放,更多协作,更多机会产生。从来没有一项服务会将几乎所有IT、互联网、通信技术整合在一起,没有合作、开放的心态就没有云计算。接下来,将从IaaS、NoSQL与NewSQL、数据中心、大数据、安全这几个方面对过去一年作出总结。

IaaS——群雄追赶AWS

谈到IaaS,Google和AWS是公认的业界最强。AWS是全球将IaaS这个business运营的较好的公司,除了技术领先,还要得益于其多年的B2C领域积累的经验和口碑。而Google的强大在于其对技术极致的探索,从“三驾马车”Big Table、GFS和MapReduce,到Pregel、Dremel、Big Query(与之对应的还有Twitter的Blobstore、Cloudrea Impala以及Apache Drill。),能够完成跨数据中心的数据存储和快速SQL查询,毫无疑问,这些技术都是互联网巨头和IaaS服务商必须要解决的。这背后还需要强大的网络拓扑、IDC设计等等,今年Google一反常态的公布了数据中心内部的照片和文档,虽然信息量不大,但这足够证明Google在数据中心PUE控制方面的自信。

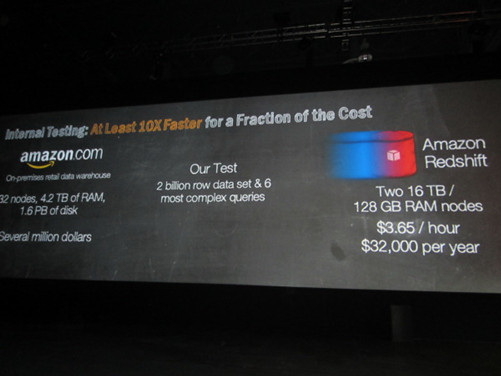

图:AWS正在与PaaS和SaaS服务结合。Redshift大数据分析工具,其成本只有Teradata IBM Oracle的十分之一。

说了半天废话,以下将从:私有与开源、商业模式探索、国内格局三个话题展开:

1、私有与开源

2012年不得不说的开源项目之一OpenStack,这是一个基于ASF 2.0协议的开源IaaS平台,说白了,任何一个人通过OpenStack都可以复制出一个AWS(当然,服务器、交换机这些还是需要的。)。正因为OpenStack巨大的魅力,包括IBM、HP、Intel、Red Hat、VMware以及国内的新浪、华为均先后加入组织。OpenStack对于所有IT和通信厂商而言都是全新的机遇和挑战。众所周知,硬件利润越来越低,而VMware等虚拟化厂商却“肥的流油”。已经打的不可开交HP和Dell都不想错过重新排定生态链次序的机会,两者均与Cloud Foundry合作,扩展渠道,并在差异化上下足功夫。

和OpenStack拥有类似功能的开源IaaS平台还包括CloudStack、OpenNebula和Eucalyptus。这四大开源平台将与AWS在未来的相当一段时间共同成长。明年,CloudStack将迎来爆发,更有可能成为Apache正式的项目。OpenNebula更显低调,Eucalyptus则专注在私有云市场。

另外,IBM、HP、VMware等传统IT厂商私有云或共有云产品并不是真正的IaaS,这也是这些厂商积极投入OpenStack的原因。同时,来自新浪、趣游等本土公司也在积极参与到OpenStack的贡献和交流。

2、商业模式探索

AWS是全球最成功的IaaS服务商,虽然占Amazon整体的营收比例依然很小,外界仍十分看好AWS的未来。在Amazon披露的财报中,没有对AWS业务的营收数据做具体描述,十分低调。只能看到:包括AWS和内容增值服务的业务,一直处于增长。包括分析师、投资公司的报告普遍认为,今年AWS的营收将达到10-15亿美元,根据一般的经验判断,这些数据的可靠性是比较高的。

之所以AWS能够成为IaaS的领军者,离不开其多年在B2C领域积累的经验和口碑,这点是Google所不具备的,国内的阿里与AWS基因最相似。同时,AWS、OpenStack的成员们都在紧密与PaaS或SaaS服务商合作。只有与用户最接近,利润率才越高。如果把Saleforce看作IaaS,无疑是最赚钱的IaaS平台。

3、国内的IaaS格局

相对于国外的几大阵营和发展趋势,国内的情况更为复杂。割裂的网络、不透明的准入机制、电信运营商的垄断、信用卡支付壁垒、用户习惯的培养等等,所有这些问题一个问题解决不了都可能制约IaaS运营商的发展。目前国内两大IaaS平台分别是阿里云和盛大云,阿里的优势在前文已经提到,垄断了大量珍贵的BGP网络,先天优势明显。

微软Azure与世纪互联的合作可以看作国外IaaS平台进入大陆的起点,这也让AWS进军国内充满了更多期待。

第二梯队中Ucloud、Linkcloud、西部数码、华云等比较有代表性。当然,还有一个隐蔽的企业华为。全球电信运营商的设备大部分由华为提供,依靠多年积累的BOSS系统支持经验,以及与运营商的良好关系,华为IaaS上线只待更好的时机。但关键在于,华为几乎没有B2C的经验,这是华为必须解决的难题。

新时代的数据库

在过去一年中随着数据体积的爆发性增长,大数据技术也越发的炙手可热。俗话说工欲善其事必先利其器——为了实现对越来越多数据的挖掘和分析,2012无疑是绞尽脑汁的一年。好吧,言归正传。下面分几个方面简单的讨论一下2012年的数据库发展趋势。

SQL 、NoSQL、NewSQL

随着NoSQL这场运动最终被定义为Not Only SQL,数据库领域的人们也确定了NoSQL不是SQL的取代——更应该作为对数据库领域非关系数据类型补充。而随着各个厂商以各种方式在NoSQL数据库产品中添加对SQL的支持,在面对大数据带来的挑战上也终于达成了“两手抓,两手硬”的共识。而就目前的市场调研来看10gen的MongoDB仍然是更受欢迎的NoSQL数据库。然而NoSQL的精髓在于百花齐放,用细分的技术解决各种大数据所带来的挑战;所以MongoDB不能完全的代表NoSQL。期间Neo4j等产品也是拥有了一定的拥护度。

再看NewSQL,NewSQL概念的存在更像是对早期NoSQL的补充,这里需要先看一下NoSQL以及NewSQL的设置宗旨:NoSQL数据库,旨在满足分布式系统结构的可扩展性需求和/或无模式数据管理的需求;NewSQL数据库,旨在满足分布式体系结构的需求,或者提高性能以便不必再进行横向扩展。这就意味着在NoSQL数据库发展为Not Only SQL的大趋势下,NewSQL与NoSQL之间的界限就变的越发的模糊。所以再去强调NewSQL或者是NoSQL的意义显然已经不大。

数据库发展的趋势

在这个数据的年代,更多的数据胜过更好的算法已经被大多数人所接受。然而面对数据这座宝山却没有对应的处理和分析技术,无疑只能望梅止渴。随着数据能采集到数据体积的暴增,数据的实时处理无疑成为了重中之重。这里我们不得不提的就是数据处理工具。

快,还要更快

![]()

图:Apache S4分布式流数据处理平台

说到数据分析工具就不得不提到Apache Hadoop,它的开源和强大的批处理能力得到了众多大数据玩家的喜爱。然而随着数据的爆发性增长一些数据分析产品相继问世,比如:Dremel、Storm、Impala、Apache S4和Drill;而他们共有的显著特性就是优于Hadoop几倍甚至几十倍的查询能力。这无疑说明了各个组织及机构把数据分析和处理的关键聚焦于实时之上,并开始着手解决望梅止渴的窘境。

是的数据的处理和分析需要快,那么数据的存储呢?

可靠还要更可靠

众所周知,Hadoop及HBase、HDFS其实是在Google的MapReduce、BigTable和GFS三篇论文的启发下开发出来的。而近年来Google的基础机构又有了一波新的补充及更新——Caffeine、Pregel和Dremel。然而Google的脚步并不仅如此,Google在OSDI 2012上公布了分布数据库Spanner。这是第一个扩展到世界规模的数据库系统,并支持了外部一致性分布式事务。然而外部事务强一致性的保障以及全球及的分布,无疑确定了人们对数据库可靠性的要求越来越高。也只有全球及数据转移才能保证大范围自然灾害下的强可靠性,比如这次飓风Sandy的过境。

数据中心在这一年中有很多精彩的内容,比如亚马逊三番五次宕机、谷歌历经7年终于开放其数据中心等等。我们在接下来的内容里将为您盘点几个重要公司在数据中心方面的现状、发展、技术等内容。

图:Google Concil Bluffs数据中心内部

亚马逊

亚马逊的数据中心历来都很神秘,对其的报道也很少很少,大家的目前都集中在它的云服务上,但这离不开其庞大的数据中心支持。去年年底,亚马逊已经增加了其第七个云数据中心,作为全球数据中心容量扩张的一部分。新设施位于美国俄勒冈州博德曼,在哥伦比亚河沿岸采用低成本的水力发电。除了廉价的水电,博德曼位于波特兰市以东80英里,提供了充足的冷却水供应。现代数据中心安装较低数量的空调,并经常使用某种形式的蒸发来冷却外界空气,让其在数据中心流通。通过这种方式,两排服务器虹吸释放出的暖空气到热通道,在热通道热空气被收集,强大的风扇将其排出建筑物。热通道的温度为华氏95-100度。

由于经济恶化,亚马逊在2009年停止对博德曼设施的建设,但在今年早先时候恢复工作并完成了中心的配置。并在十月初开始运营,11月9日亚马逊开始提供服务,设置标准为IaaS:EC2的弹性计算云,简单存储服务,简单的数据库服务,亚马逊简单队列服务,以及其他。

6月15日,亚马逊北维吉尼亚的数据中心遭遇停电,由此导致亚马逊网络服务AWS中断约6个小时,影响波及亚马逊弹性计算EC2、亚马逊关系数据库服务以及AWS Elastic Beanstalk。今年的10月,亚马逊再次发生宕机事故,导致用户信心流失不少。最后再圣诞节平安夜的时候,亚马逊AWS位于美国东部的数据中心发生故障,其弹性负载均衡服务(Elastic Load Balancing Service)中断,导致Netflix和Heroku受到影响,不过作为Netflix的竞争对手,Amazon Prime Instant Video并未受到影响。

Facebook选择俄勒冈州的高度沙漠化地区建立新数据中心,这里的夜晚是凉爽的,即使是在夏天。该设施坐落于尤金以东100英里,并成为Facebook四月声称要运行一个高效的数据中心来支撑其数以百万计在线应用的基础。 Facebook在其开放计算项目中发表了服务器架构的细节,作为它创造更高效数据中心的承诺的标志。

Facebook透露,开源服务器的有效率达到94.5%,这个成绩离不开整个数据中心的供电和散热系统的帮助。和Facebook在Virginia和California的数据中心相比,Prineville的数据中心电力节省38%,成本降低24%。数据中心的PUE平均在1.6到1.8,然而Facebook的Prineville数据中心的PUE则达到在惊人1.05到1.10之间。

谷歌

过去,数据中心被Google视为核心技术,因此Google对自己数据中心的细节总是三缄其口。一般而言,每当Google公开一项技术,意味着Google已经掌握了更先进的技术。即便如此,已经被Google“解密”的技术依然值得深入研究、学习。谷歌于今年的10月份,终于向媒体开放了它的数据中心,并发布了一些照片。

通过照片我们可以看到,谷歌的数据中心是一个巨大的房间,而不是被分成若干独立的区域。完全采用风道设备,彻底避免服务器或机架产生的空气泄露。冷空气直接流入服务器,热空气并不会流回,而是通过热交换器将热量传递出去。空气流动控制格外重要,空气流动经济性(air-side economization)是提升散热效率的关键。提高空气流动经济性的关键是让冷空气流入服务器,而不是让服务器排出热空气。

Google把整个建筑视为风道的一部分,并没有完全弃用水冷系统,而是将其升级进化,从而提高水冷系统的效率。固然直通到机架的水冷系统拥有高效率,但任何一个空气流动经济系统都可以屏蔽户外的热空气,并让冷空气长途跋涉输送给服务器。然而,随着服务器密度不断增加,单位空间的功率也随之增长,水冷系统就十分必要了。

在微软Azure宕机的同一天,Google Gmail用户使用的Gtalk中断了近5小时。Gtalk服务的控制面板页为用户提供了因服务中断所导致的升级。Google对此也做出了道歉“请相信google是极度重视系统可靠性的,我们会更加注意提升我们系统的性能”。

GAE是用于开发和托管WEB应用程序的平台,数据中心由google管理,中断时间是10月26日,持续4小时,因为突然变得反应缓慢,而且出错。受此影响,50%的GAE请求均失败。google表示没有数据丢失,应用程序行为也有备份可以还原。google表示他们正在加强其网络服务以应对网络延迟问题,“我们已经增强了流量路由能力,并调整了配置,这些将会有效防止此类问题再次发生”。

微软

微软今年花了1.3亿美元扩展了其位于都柏林的数据中心,本次投资将新增11.2万平方英尺第4代设备。该数据中心全年充分利用风能冷却设备,降低能耗,减少微软碳足迹。每年能耗高峰时期平均电源使用效率PUE为1.25。微软称,设备99%的剩余能耗将实现循环使用,水能耗仅相当于同等大小的数据中心水能耗的1%。此外,微软计划在怀俄明州夏延 (Cheyenne)建立一个新的数据中心,预计在2013年春季开工。

新的数据中心将帮助微软承载更多的产品,而不是销售客户在他们自己的计算机上安装的软件。微软除了提供它的PaaS产品、Azure、去年开始销售的Office 365、提供的电子邮件托管和协作服务外,它也希望能增长其Bing搜索量,这就要求数据中心为用户服务搜索结果。

2月28日,由于“闰年bug”导致微软Azure在全球范围内大面积服务中断,中断时间超过24小时。虽然微软表示该软件BUG是由于闰年时间计算不正确导致,但这一事件激起了许多用户的强烈反应,许多人要求微软为此做出更合理详细的解释。

7月26日,Azure再次故障,导致西欧用户受影响。微软对故障的解释是“由于错误配置了网络设备导致了西欧区域的服务网络中断”。此次中断持续2.5小时。微软表示此次事故中并无用户数据丢失。

2013发展趋势

今年的数据中心发展道路可以说很顺利,Facebook、谷歌纷纷向媒体公开其数据中心,这表明未来的数据中心将是越来越开放的。但我们也要看到发展中遇到的一些问题,AWS今年在运行过程中三番五次的宕机,这反映出数据中心的安全运行问题值得迫切关注。还有一个趋势就是清洁能源在数据中心运行中占的比重越来越大,风能、太阳能等清洁能源正被更多的数据中心所使用。最后,随着科学技术向亚太地区转移,以及亚太地区特有的人力资源优势,我们可以想象到随着时间的推移更多的数据中心将向亚太地区迁移。

2012年,大数据的发展势头可谓“如火如荼”。因为移动互联网和云计算的崛起,数据量的激增让很多企业看到了无限的商机。很多人谈到大数据时,首先想到的就是Hadoop,此时很多“专业人士”就会告诉你,Hadoop不是大数据的全部。当然,我们必须认识到Hadoop自身还有很多局限性。不过这也侧面说明:Hadoop是大数据的“超级明星”!

在2012年1月1日,CSDN对Hadoop的开篇之作就是“Hadoop 1.0正式发布”,历时六年,这一个较高级Apache开源项目终于发布,雅虎是其最主要的贡献者,它也是由前雅虎开发者Doug Cutting(也是Nutch和Lucene的创始人)开发的分布式计算平台,受Google的MapReduce和GFS启发,主要被应用于分析大容量数据集。Hadoop被eBay、Facebook、Yahoo、AOL和Twitter等互联网公司广泛采用,今年微软、IBM和甲骨文等也都纷纷拥抱了Hadoop。

Hadoop具备低成本和前所未有的高扩展性,已被公认为是新一代的大数据处理平台。就像30年前SQL出现一样,Hadoop正带来了新一轮的数据革命。如今Hadoop已从初出茅庐的小象变成了行业的巨人,但Hadoop仍需继续完善。不过今天,Hadoop已经从初出茅庐的小象变身行业巨人。

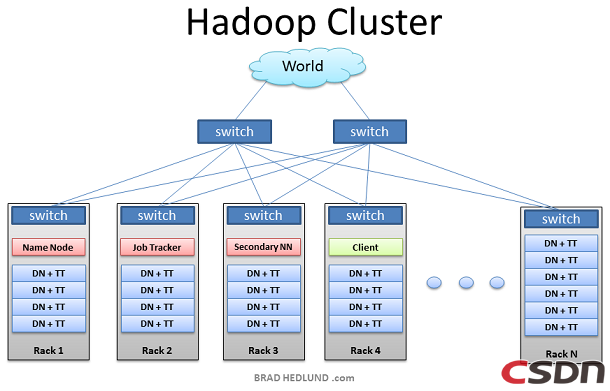

Hadoop相关技术的那点事

技术干货!如果想深入理解Hadoop集群和网络,那么不妨看一下Dell企业技术专家Brad Hedlund撰写的文章,他阐述了Hadoop主要的任务部署分为3个部分,分别是:Client机器,主节点和从节点。主节点主要负责Hadoop两个关键功能模块HDFS、Map Reduce的监督。当Job Tracker使用Map Reduce进行监控和调度数据的并行处理时,名称节点则负责HDFS监视和调度。从节点负责了机器运行的绝大部分,担当所有数据储存和指令计算的苦差。每个从节点既扮演者数据节点的角色又冲当与他们主节点通信的守护进程。守护进程隶属于Job Tracker,数据节点在归属于名称节点。不过如果发现部署Hadoop还有困难,那么你就需要关注管理Hadoop集群的5大工具,它们就是Apache Ambari、Apache Mesos、Platform MapReduce、StackIQ Rocks+ Big Data以及Zettaset Orchestrator。

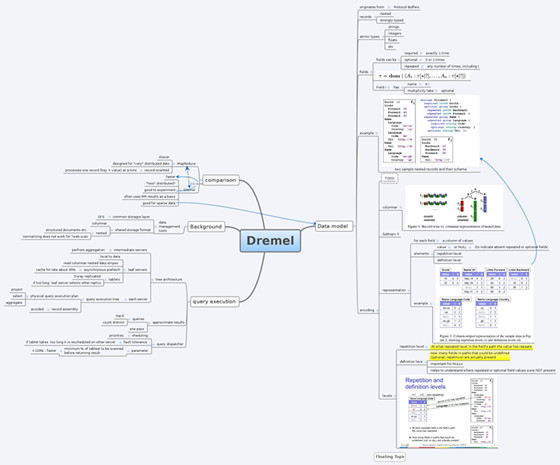

众所周知,Google在2003年到2004年公布了关于GFS、MapReduce和BigTable三篇技术论文,这也成为后来云计算发展的重要基石,如今Google在后Hadoop时代的新“三驾马车”——Caffeine、Pregel、Dremel再一次影响着全球大数据技术的发展潮流。

不过,CSDN总编刘江曾经撰文:有媒体称之为后Hadoop时代的三驾马车Caffeine、Pregel和Dremel。当然,这种说法有混淆了辈份之嫌,而且并不十分科学。Pregel是图数据库,据说在MapReduce之外担负了另外20%的数据处理任务,与三大论文之间没有承继关系。其实某种程度上,Caffeine是MapReduce的演进,在今年OSDI上大火的Spanner可以视为BigTable的演进,而Dremel则是新出的。

Hadoop的相关产品

2012年10月24日,实时运营信息软件供应商Splunk在Strata Conference + Hadoop World上推出Splunk Hadoop Connect和Splunk App for HadoopOps。前者实现与Hadoop相集成,并且能够与其进行互动,后者监控超越Hadoop本身的集群资源,这些都意味着Hadoop外延应用越来越丰富。

以此同时,大数据技术会议Strata Conference + Hadoop World同样传来消息,Cloudera发布了实时查询开源项目Impala 1.0 beta版,称比原来基于MapReduce的Hive SQL查询速度提升3~90倍。

再看一下微软,他已经将Hadoop作为自身大数据战略的核心。微软此举的理由就是看中了Hadoop的潜力,在大数据领域Hadoop已经成为分布式数据处理的标准。通过集成Hadoop技术,微软也允许客户访问快速增长的Hadoop生态系统。 让我们一起走进“Microsoft Azure Hadoop特性一览”。

目前Facebook Hadoop集群内的HDFS物理磁盘空间承载超过100PB的数据(分布在不同数据中心的100多个集群)。由于HDFS存储着Hadoop应用需要处理的数据,因此优化HDFS成为Facebook为用户提供高效、可靠服务至关重要的因素。Facebook公开其Hadoop与Avatarnode代码——有效解决Namenode的顽疾。

Hadoop领域的那些大牛们

其实在Hadoop领域有很多传奇人物,先说说Hortonworks的CTO Eric Baldeschwieler,Eric在2006年毅然投入雅虎Apache Hadoop项目的怀抱,将其从20个节点的原型系统发展为42000个节点的服务。而后,当雅虎决定全力支持Apache Hadoop项目,并于2011年7月成立新公司Hortonworks时,Eric当之无愧地成为首任CTO。作为资深技术人士,但当CTO的Eric感觉自己面临了诸多挑战。但他对Hadoop的前景非常乐观,“大家多贡献一点,Hadoop将会创造奇迹。”

根据目前的状况来看,Hadoop作为企业级数据仓库体系结构核心技术,在未来的数年中将会保持持续增长的势头。下一代的MapReduce节点数将从目前的4000增加到6000-10000,其次并发的任务数从目前的40000增加到100000。

Hadoop不是万能的

虽然Hadoop有很多忠实的拥护者。毕竟它可以轻而易举地处理PB级别的数据,它可以将运算扩展到数千个节点的分布式计算能力,它也具有存储和加载数据的灵活性。但在经历过一系列的探索与使用之后,你会发现,Hadoop也有自己的软肋,下面列举了为什么不使用Hadoop做数据分析的原因:

不过更为讽刺的是,Hadoop较大的缺点之一就是其较大的优势所在——分布式文件系统(HDFS)。现在越来越多想要取代HDFS的选项证明了HDFS并不是适合所有的领域。一些Hadoop用户对于性能、可用性和企业级功能有严格的要求,而对直连存储(DAS)架构并不热衷。而关注可用性的用户一定特别关注方方面面,比如绝不会使用没有内建高可用性名称节点(High Availability NameNode)的旧版本。这里就有8项产品(或方案)声称可以取代HDFS:Cassandra (DataStax)、CEPH、Dispersed Storage Network (Cleversafe)、GPFS(IBM)、Isilon (EMC)、Lustre、MapR File System以及NetApp Open Solution for Hadoop。

Hadoop的辉煌还能延续多久?

Hadoop的灵魂是MapReduce。但是面对数据的爆炸性增长,谷歌的工程师Jeff Dean和Sanjay Ghemawat架构并发布了两个开创性的系统:GFS和谷歌MapReduce(GMR)。前者是一个出色而实用的解决方案-使用常规的硬件扩展并管理数据,后者同样辉煌,造就了一个适用于大规模并行处理的计算框架。不过一个有趣的现象是,MapReduce在谷歌已不再显赫。当企业瞩目MapReduce的时候,谷歌好像早已进入到了下一个时代。事实上,我们谈论的这些技术早就不是新技术了,MapReduce也不例外。

尽管当前大数据技术的核心依然是Hadoop,但谷歌却已经为我们展现了许多更先进的大数据技术。谷歌开发这些技术的本意并不是要立刻抛弃掉MapReduce,但毫无疑问这是未来大数据技术的趋势。尽管已经出现了上述大数据技术的开源实现,但我们不禁要问,Hadoop的辉煌还能延续多久?

基于Hadoop的改进以及的成果

围绕Hadoop,产业链更加清晰。十月或许是大数据历史上值得标注的一个月,因为Hadoop会被重新定义:既可以是大数据批量处理的一个研究框架,也可以是结构化与非结构化数据大规模并行分析数据高速的发动机,交互分析的产品。Birst、Splice Machine和Teradata这三家企业的产品从外延提升了Hadoop的应用范畴。

接下来,就要说说一些常用的开源工具了。首先看看Storm,这是我们经常用的一个非常有效的开源实时计算工具,它由Twitter开发,通常被比作“实时的Hadoop”。然而Storm远比Hadoop来的简单,因为用它处理大数据不会带来新老技术的交替。当然对比Hadoop的批处理,Storm是个实时的、分布式以及具备高容错的计算系统。同Hadoop一样Storm也可以处理大批量的数据,然而Storm在保证高可靠性的前提下还可以让处理进行的更加实时;也就是说,所有的信息都会被处理。Storm同样还具备容错和分布计算这些特性,这就让Storm可以扩展到不同的机器上进行大批量的数据处理。

不过说到Twitter,就不得不提起近期刚刚发布的Blobstore图片存储系统,是由Twitter开发的一个低成本和可扩展的的存储系统,可以用来存储图片以及其他的二进制对象(称为“blob”)。不过令人遗憾的是,Blobstore并不是一个开源工具。

不过我们还有其他的选择,Facebook最近在他们官方Github上发布了Corona的开源版本,声称这是下一代MapReduce,他们马上将用这一新技术替代他们的Hadoop系统中的MapReduce。其实Corona就是一个取代MapReduce用来调度Hadoop Job的新的系统。其目的是为了更好的利用集群的资源,同时能够让Hadoop的应用范围更广。

还有上文提到的Cloudera发布了实时查询开源项目Impala。多款产品实测表明,比原来基于MapReduce的Hive SQL查询速度提升3~90倍。虽然Impala是Google Dremel的模仿,但在SQL功能上青出于蓝胜于蓝。

大数据面临的一个很大的问题是大多数分析查询都很缓慢且非交互式。Google的Dremel能以极快的速度处理网络规模的海量数据。据谷歌的研究报告显示,Dremel能以拍字节(petabyte,PB,1PB等于1024TB)的数量级来进行查询,而且只需几秒钟时间就能完成。而其对应的开源版本就是Drill。 Drill与MapReduce相辅相成。在谷歌,数以千计的工程师每天都在使用Dremel和MapReduce,未来也将有着更多的人来使用Drill与MapReduce。如果想了解的更多,可能你还需要看看Google Dremel 与 Apache Hadoop的对比篇。

随着IT技术本身的发展和更加深入广泛的生活应用,让我们先盘点下2012年计算机安全上的大事件:

随着云计算和大数据技术的成熟,对于的安全技术也在逐渐发展,下面就一些热门的云安全技术做下盘点:

策略

以往的安全解决方案就是一套杀毒软件,一套安全设施再加一套安全体系。如今,在云背景下安全早已经上升到企业战略这个高度,那么面对云计算,对企业在策略上的变化做下盘点:

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/4019.html

摘要:国内领头企业金蝶,年上半年收入亿元。金蝶自年转型企业云服务开始,云服务营收占比逐年上涨。政府推动企业上云,应用迎来机会年月,政府颁发了推动企业上云实施指南年,提出到年,云计算要在企业生产经营管理中的应用广泛普及,全国新增上云企业万家。经常有人问,SaaS行业有前途吗?先看个例子。P图鼻祖Photoshop,大家都知道吧。打造Photoshop的Adobe公司,2018全年营收达高达90.3 ...

摘要:,普通表格近日,两位云计算高管离职,此次离开距离他们加入这个公司只有一年左右时间。是两位离职高管之一,这一消息已经从发言人那里得到确认。走了之后,或将采取新的策略。 近日,两位SAP云计算高管离职,此次离开距离他们加入这个公司只有一年左右时间。这两位高管都是跟随Ariba的被收购而进入SAP,2012年5月,SAP以 43亿美元收购Ariba。 Bob Calderon...

摘要:有市场分析机构预测,年国内公有云服务市场规模将超过亿元,增速超过。更老牌的科技巨头华为在大会上明确表示,未来发展要构建云生态战略,主打行业云,以业务为主,每年在业务的投资将不低于亿美元。 2015年,云计算产业广被熟知。更为重要的是,以往言必称亚马逊、谷歌、微软的云计算市场,由于大批国产厂商的崛起而备具中国特色:阿里云成阿里巴巴增长最快业务;腾讯云、金山云(联合小米)、百度云全力上阵;甚至...

摘要:从技术的角度来看,当前国内云计算尚处于初级的阶段,在鄂尔多斯市构建一个健康的云计算产业链,不仅需要对技术有清晰的认识,而且必须严把安全关口。而技术的发展要符合自身的发展规律,云计算是不可能在年的时间内迅速发展成熟的。 从技术的角度来看,当前国内云计算尚处于初级的阶段,在鄂尔多斯市构建一个健康的云计算产业链,不仅需要对技术有清晰的认识,而且必须严把安全关口。今后鄂尔多斯云计算产业研究院将抓大扶...

摘要:在年第三季度,来自最新公布的报告显示,全球整体企业级存储市场收入获得了的增长,其中戴尔易安信与去年同期相比在该季度获得了的增长,并以的行业份额排名第一。在戴尔易安信继续领跑全球服务器市场的同时,自然也带来了在服务器的存储销售增长与良好势头。云计算不但没有将企业级存储抛弃,而且还给了企业级存储新的发展机会。RightScale的《2018年云状况调查》报告分析,针对不同工作负载、不同的云,自然...

阅读 2673·2023-04-25 15:07

阅读 759·2021-11-24 10:21

阅读 2384·2021-09-22 10:02

阅读 3564·2019-08-30 15:43

阅读 3284·2019-08-30 13:03

阅读 2350·2019-08-29 17:18

阅读 3636·2019-08-29 17:07

阅读 1966·2019-08-29 12:27