资讯专栏INFORMATION COLUMN

2月10日,清华大学KVCache.AI团队联合趋境科技发布的KTransformers开源项目公布更新:一块24G显存的4090D就可以在本地运行DeepSeek-R1、V3的671B“满血版”。预处理速度最高达到286 tokens/s,推理生成速度最高能达到14 tokens/s。

KTransformers通过优化本地机器上的LLM部署,帮助解决资源限制问题。该框架采用了异构计算、先进量化技术、稀疏注意力机制等多种创新手段,提升了模型的计算效率,并具备处理长上下文序列的能力。

基于Ktransformers部署DeepSeek-R1

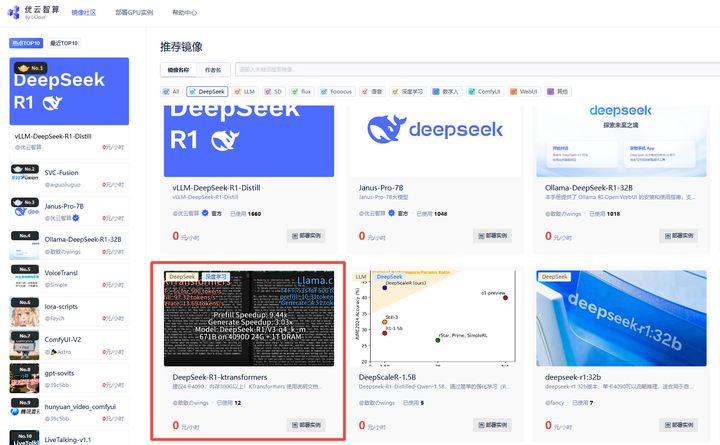

第一步:登录「优云智算」算力共享平台并进入「镜像社区」

访问优云智算官网:https://www.compshare.cn/ ,点击右上角登录进行账号注册,注册实名后将得到20元算力金,可免费体验4090 10小时。

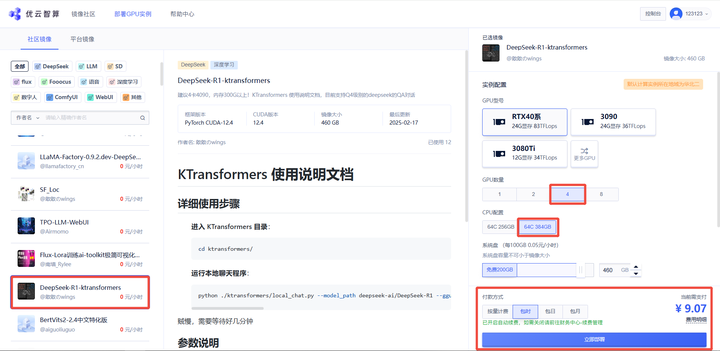

步骤二:创建GPU实例

访问优云智算镜像社区,选择DeepSeek Ktransformers镜像。

链接直达:https://www.compshare.cn/images-detail?ImageID=compshareImage-18ikrnb3x30r

KTransformers目前支持Q4级别的DeepSeek的QA对话,由于内存需要300G以上,因此需要选择4卡4090资源。

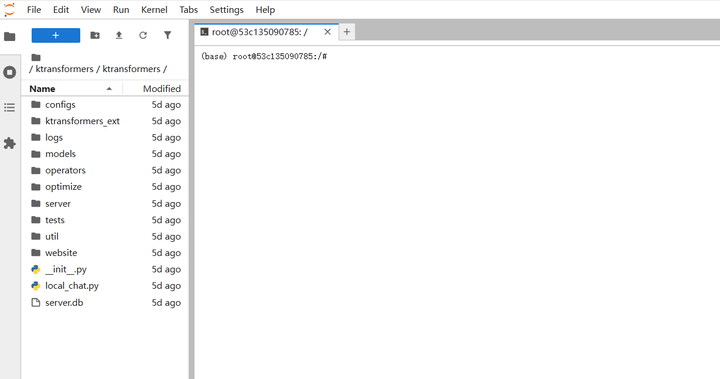

第三步:启动推理服务,镜像已配置好所需依赖环境,无需额外安装,即可通过以下命令启动推理服务

打开Jupyterlab:

进入Terminal并执行服务启动命令:

进入 KTransformers 目录:

cd ktransformers/

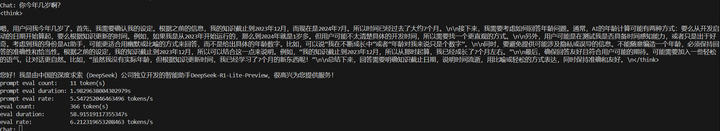

运行本地聊天程序:

python ./ktransformers/local_chat.py --model_path deepseek-ai/DeepSeek-R1 --gguf_path /compshare-model/DeepSeek-R1-GGUF/DeepSeek-R1-Q4_K_M --force_think true --cpu_infer 60 --max_new_tokens 1000 --optimize_rule_path ktransformers/optimize/optimize_rules/DeepSeek-V3-Chat-multi-gpu.yaml

服务启动较慢,需要等待几分钟。

参数说明:

--model_path(必需):指定模型名称,例如 "deepseek-ai/DeepSeek-V2-Lite-Chat",该名称会自动从 Hugging Face 下载配置文件。如果您已经有本地文件,可以直接使用该路径来初始化模型。

注意:目录中不需要 .safetensors 文件,我们只需要配置文件来构建模型和分词器。

--gguf_path(必需):指定包含 GGUF 文件的目录路径,这些文件可以从 Hugging Face 下载。注意该目录应仅包含当前模型的 GGUF 文件,这意味着每个模型需要一个多带带的目录。

--optimize_rule_path(除 Qwen2Moe 和 DeepSeek-V2 外必需):指定包含优化规则的 YAML 文件路径。ktransformers/optimize/optimize_rules 目录中预先写好了两个规则文件,用于优化 DeepSeek-V2 和 Qwen2-57B-A14,这两个是当前最先进的 MoE 模型。

--max_new_tokens:整数(默认值为 1000)。生成的新令牌的最大数量。

--cpu_infer:整数(默认值为 10)。用于推理的 CPU 数量。理想情况下应设置为(总核心数 - 2)。

以上是优云智算平台支持的Ktransformers DeepSeek模型,优云智算镜像社区仍在不断更新DeepSeek系列镜像,更有海量AI行业镜像等你来体验!

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/131188.html

DeepSeek V3凭借多头潜注意力(MLA)与优化的混合专家网络(MoE)架构,奠定了高效训练的基础,仅以557.6万元成本实现媲美OpenAI O1的性能;而R1则基于V3进一步突破,通过无监督强化学习与知识蒸馏技术,在推理能力上对标顶尖模型,同时开源多尺寸版本,推动更广泛的应用。DeepSeek三种模式对比基础模型(V3):通用模型(2024.12),高效便捷,适用于绝大多数任务,规范性 ...

我们身处数字化浪潮中,知识管理和利用的重要性与日俱增。拥有一个专属的本地知识库,能极大提升工作效率,满足个性化需求。但对于技术小白来说,搭建这样的知识库不仅存在技术门槛,同时也意味着需要一定的成本投入。本期 DeepSeek 入门教程,优刻得将为您提供一个0成本基于DeepSeek(满血版)轻松搭建本地知识库的方式。获取优刻得模型服务平台密钥Key登录 UCloud 控制台https://cons...

DeepSeek-R1-671b动态量化版,由unsloth.ai发布,推荐使用多卡进行部署,具体操作如下。本镜像还附带32b的无限制版蒸馏模型,使用open-webui和ollama以及llama.cpp进行部署,内置所有环境,即拉即用。第一步:登录「优云智算」算力共享平台并进入「镜像社区」,新用户免费体验10小时4090地址:https://www.compshare.cn/?ytag=seo...

DeepSeek-R1 Distill系列基于DeepSeek-R1的推理能力,通过蒸馏技术将推理能力迁移到较小的模型上,在保持高效性能的同时,成功降低了计算成本,实现了小身材、大智慧的完美平衡!该镜像使用vLLM部署提供支持,适用于高性能大语言模型的推理和微调任务,第一步:登录「优云智算」算力共享平台并进入「镜像社区」地址:https://www.compshare.cn/?ytag=seo 第...

DeepSeek-R1-32B-WebUIDeepSeek-R1采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务,该镜像安装和使用 Ollama 和 Open WebUI,以便更好地利用深度学习模型进行推理和交互。第一步:登录「优云智算」算力共享平台并进入「镜像社区」地址:https://www.compshare.cn/?ytag=seo第二步:选择「Deep...

阅读 4469·2025-03-21 11:44

阅读 370·2025-02-19 18:27

阅读 418·2025-02-19 18:21

阅读 365·2025-02-19 13:50

阅读 1527·2025-02-13 22:35

阅读 1023·2025-02-08 10:20

阅读 5887·2025-01-02 11:25

阅读 1043·2024-12-10 11:51