资讯专栏INFORMATION COLUMN

DeepSeek-R1-32B-WebUI

DeepSeek-R1采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务,该镜像安装和使用 Ollama 和 Open WebUI,以便更好地利用深度学习模型进行推理和交互。

第一步:登录「优云智算」算力共享平台并进入「镜像社区」

地址:https://www.compshare.cn/?ytag=seo

第二步:选择「DeepSeek-R1-32B」镜像,点击「使用该镜像创建实例」

镜像地址:https://www.compshare.cn/images-detail?ImageID=compshareImage-17j1nrwtdmid

根据镜像说明中的引导,选择所用模型需要的GPU算力规格,并点击「立即部署」即可拥有一个自带模型的算力资源。

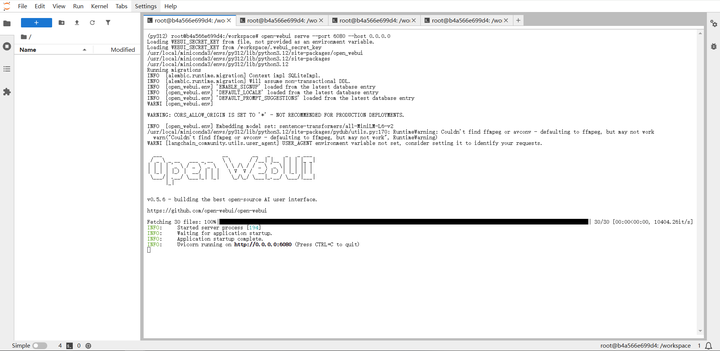

第三步:进入JupyterLab启动服务

运行 Ollama

在终端中执行以下命令以启动 Ollama 服务:

ollama serve

运行模型(可选)

接下来,您可以安装并运行指定的深度学习模型。以下是安装和运行 deepseek-r1:32b 模型的命令:

ollama run deepseek-r1:32b

启动 Open WebUI

启动 Open WebUI 服务,指定端口和主机:

open-webui serve --port 6080 --host 0.0.0.0

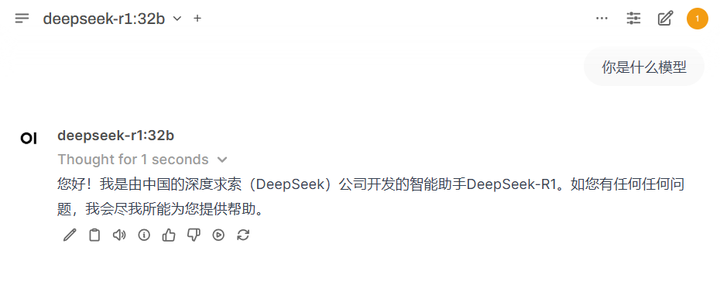

用户名和密码设置

访问机器外网IP:6080,在启动Open WebUI 后,您需要设置用户名和密码。请按以下步骤进行设置:

创建用户名和密码,均设置为 123。邮箱为:pony@123.com

以上是优云智算平台支持的DeepSeek系列模型,优云智算镜像社区仍在不断更新DeepSeek系列镜像,更有海量AI行业镜像等你来体验,现在注册实名可得20算力金,免费体验10小时4090!

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/131185.html

DeepSeek-R1-671b动态量化版,由unsloth.ai发布,推荐使用多卡进行部署,具体操作如下。本镜像还附带32b的无限制版蒸馏模型,使用open-webui和ollama以及llama.cpp进行部署,内置所有环境,即拉即用。第一步:登录「优云智算」算力共享平台并进入「镜像社区」,新用户免费体验10小时4090地址:https://www.compshare.cn/?ytag=seo...

我们身处数字化浪潮中,知识管理和利用的重要性与日俱增。拥有一个专属的本地知识库,能极大提升工作效率,满足个性化需求。但对于技术小白来说,搭建这样的知识库不仅存在技术门槛,同时也意味着需要一定的成本投入。本期 DeepSeek 入门教程,优刻得将为您提供一个0成本基于DeepSeek(满血版)轻松搭建本地知识库的方式。获取优刻得模型服务平台密钥Key登录 UCloud 控制台https://cons...

DeepSeek 的持续火热,吸引了大量个人开发者和企业用户,他们期望借助 DeepSeek 大模型的强大能力,融合私有知识库,训练出契合自身需求的专属大模型,因此纷纷选择通过云端或本地部署的方式来独立部署 DeepSeek。今天,优刻得就为大家带来第一期超实用干货:仅需 10 分钟,利用 UCloud 云主机 UHost+DeepSeek + Open-WebUI 快速搭建起属于自己的私有化知识...

DeepSeek-R1 Distill系列基于DeepSeek-R1的推理能力,通过蒸馏技术将推理能力迁移到较小的模型上,在保持高效性能的同时,成功降低了计算成本,实现了小身材、大智慧的完美平衡!该镜像使用vLLM部署提供支持,适用于高性能大语言模型的推理和微调任务,第一步:登录「优云智算」算力共享平台并进入「镜像社区」地址:https://www.compshare.cn/?ytag=seo 第...

ollama介绍在本地启动并运行大型语言模型。运行Llama 3、Phi 3、Mistral、Gemma和其他型号。Llama 3Meta Llama 3 是 Meta Inc. 开发的一系列最先进的模型,提供8B和70B参数大小(预训练或指令调整)。Llama 3 指令调整模型针对对话/聊天用例进行了微调和优化,并且在常见基准测试中优于许多可用的开源聊天模型。安装pipinstallollama...

阅读 484·2025-02-07 13:40

阅读 741·2025-02-07 13:37

阅读 912·2024-11-06 13:38

阅读 1057·2024-09-10 13:19

阅读 1231·2024-08-22 19:45

阅读 1461·2021-11-19 09:40

阅读 2779·2021-11-18 13:14

阅读 4388·2021-10-09 10:02