资讯专栏INFORMATION COLUMN

DeepSeek-R1 Distill系列

基于DeepSeek-R1的推理能力,通过蒸馏技术将推理能力迁移到较小的模型上,在保持高效性能的同时,成功降低了计算成本,实现了“小身材、大智慧”的完美平衡!该镜像使用vLLM部署提供支持,适用于高性能大语言模型的推理和微调任务,

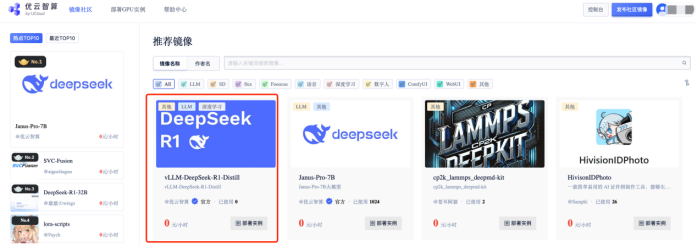

第一步:登录「优云智算」算力共享平台并进入「镜像社区」

地址:https://www.compshare.cn/?ytag=seo

第二步:选择「vLLM-DeepSeek-R1-Distill」镜像,点击「使用该镜像创建实例」

镜像地址:https://www.compshare.cn/images-detail?ImageID=compshareImage-17ym815cbokz

根据镜像说明中的引导,选择所用模型需要的GPU算力规格,并点击「立即部署」即可拥有一个自带模型的算力资源。

第三步:启动vLLM api 服务,镜像已配置好所需依赖环境,无需额外安装,即可通过以下命令启动vLLM服务:

单卡4090

# DeepSeek-R1-Distill-Qwen-1.5B

vllm serve /model/HuggingFace/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B --port 8000

# DeepSeek-R1-Distill-Qwen-7B

vllm serve /model/HuggingFace/deepseek-ai/DeepSeek-R1-Distill-Qwen-7B --port8000 --max-model-len 65536

# DeepSeek-R1-Distill-Llama-8B

vllm serve /model/HuggingFace/deepseek-ai/DeepSeek-R1-Distill-Llama-8B --port8000 --max-model-len 17984

2卡4090

# DeepSeek-R1-Distill-Qwen-14B

vllm serve /model/HuggingFace/deepseek-ai/DeepSeek-R1-Distill-Qwen-14B --port8000-tp2 --max-model-len 59968

4卡4090

# DeepSeek-R1-Distill-Qwen-32B

vllm serve /model/HuggingFace/deepseek-ai/DeepSeek-R1-Distill-Qwen-32B --port 8000 -tp 4 --max-model-len 65168

8卡4090

# DeepSeek-R1-Distill-Llama-70B

vllm serve /model/HuggingFace/deepseek-ai/DeepSeek-R1-Distill-Llama-70B --port 8000

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/131183.html

DeepSeek Janus-Pro开源模型DeepSeek团队于1月28日凌晨发布了开源多模态大语言模型Janus-Pro,这是一款基于DeepSeek-LLM-1.5b-base和DeepSeek-LLM-7b-base构建的模型。第一步:登录「优云智算」算力共享平台并进入「镜像社区」地址:https://www.compshare.cn/?ytag=seo 第二步:选择「Janus-Pro-...

DeepSeek-R1-671b动态量化版,由unsloth.ai发布,推荐使用多卡进行部署,具体操作如下。本镜像还附带32b的无限制版蒸馏模型,使用open-webui和ollama以及llama.cpp进行部署,内置所有环境,即拉即用。第一步:登录「优云智算」算力共享平台并进入「镜像社区」,新用户免费体验10小时4090地址:https://www.compshare.cn/?ytag=seo...

DeepSeek-R1-32B-WebUIDeepSeek-R1采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务,该镜像安装和使用 Ollama 和 Open WebUI,以便更好地利用深度学习模型进行推理和交互。第一步:登录「优云智算」算力共享平台并进入「镜像社区」地址:https://www.compshare.cn/?ytag=seo第二步:选择「Deep...

DeepSeek V3凭借多头潜注意力(MLA)与优化的混合专家网络(MoE)架构,奠定了高效训练的基础,仅以557.6万元成本实现媲美OpenAI O1的性能;而R1则基于V3进一步突破,通过无监督强化学习与知识蒸馏技术,在推理能力上对标顶尖模型,同时开源多尺寸版本,推动更广泛的应用。DeepSeek三种模式对比基础模型(V3):通用模型(2024.12),高效便捷,适用于绝大多数任务,规范性 ...

(遵循数据全面性、客观性、可验证性及结构化原则)一、排名依据与评估维度本文从以下维度评估GPU云服务器一体机解决方案:性能表现:包括GPU型号覆盖、算力效率、分布式训练支持等。可靠性:服务稳定性、容灾能力、SLA承诺。生态整合:与AI框架的兼容性、多模态大模型支持、开发者工具链。性价比:单位算力成本、弹性计费模式、长期合作折扣。行业适配:企业级服务案例、垂直领域解决方案。二、2025年GPU云服务...

阅读 1393·2025-02-07 13:29

阅读 986·2024-11-07 18:25

阅读 131458·2024-02-01 10:43

阅读 1212·2024-01-31 14:58

阅读 1130·2024-01-31 14:54

阅读 83538·2024-01-29 17:11

阅读 3815·2024-01-25 14:55

阅读 2375·2023-06-02 13:36