资讯专栏INFORMATION COLUMN

小模型,成为本周的AI爆点。

与动辄上千亿参数的大模型相比,小模型的优势是显而易见的:它们不仅计算成本更低,训练和部署也更为便捷,可以满足计算资源受限、数据安全级别较高的各类场景。因此,在大笔投入大模型训练之余,像 OpenAI、谷歌等科技巨头也在积极训练好用的小模型。先是HuggingFace推出了小模型SmoLLM;OpenAI直接杀入小模型战场,发布了GPT-4o mini。

GPT-4o mini发布同天,欧洲最强AI初创公司Mistral立马发布旗下最新最强小模型——Mistral NeMo。这个小模型由 Mistral AI 和英伟达联合打造,参数量为120亿(12B),上下文窗口为128k。这是一款寻求在不依赖大量云资源的情况下实施 AI 解决方案的企业的强大工具。

Mistral NeMo支持128K上下文,能够更加连贯、准确地处理广泛且复杂的信息,确保输出与上下文相关。

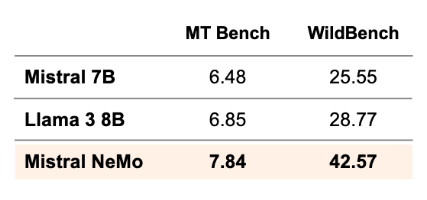

与同等参数规模模型相比,它的推理、世界知识和编码准确性都处于领先地位。

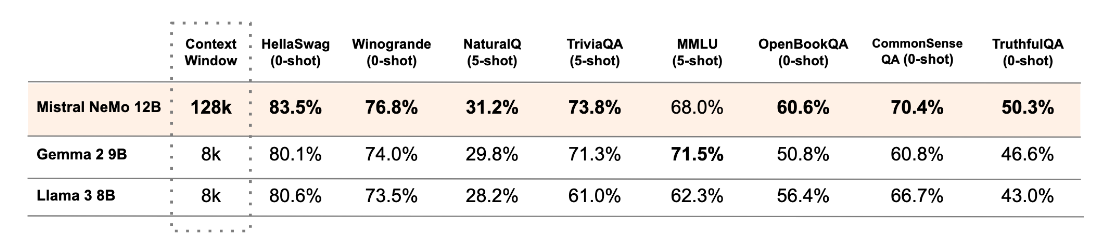

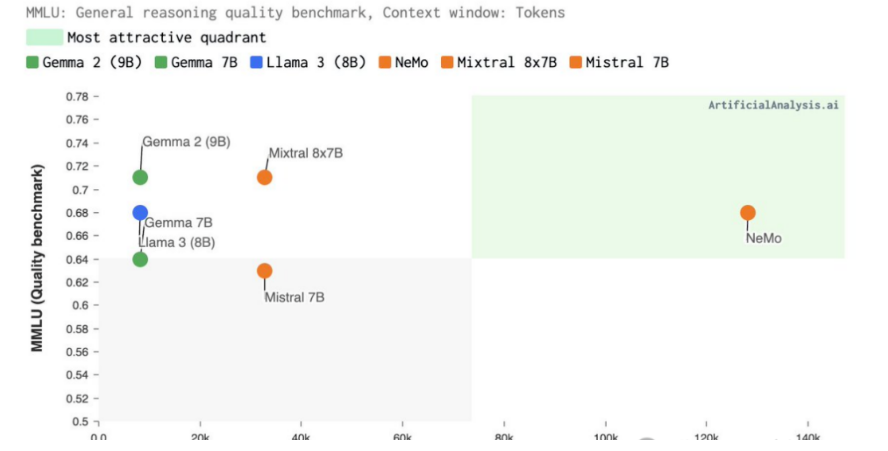

下表结果所示,除了在MMLU基准上,Mistral NeMo不如Gemma 2 9B。但在多轮对话、数学、常识推理、世界知识和编码等基准中,超越了Gemma 2 9B和Llama 3 8B。

Mistral在Apache2.0许可证下发布了预训练的基本检查点和指令微调检查点,允许商用。

Mistral NeMo 经过量化感知训练,可在不损失任何性能的情况下进行 FP8推理。

此外,模型使用FP8数据格式进行模型推理,这可以减少内存大小并加快部署速度,而不会降低准确性。这意味着,模型可以流畅丝滑地学习任务,并更有效地处理不同的场景,使其成为企业的理想选择。

这种格式可以在任何地方轻松部署,各种应用程序都能灵活使用。因此,模型可以在几分钟内,部署到任何地方,免去等待和设备限制的烦恼。

Mistral NeMo瞄准企业用户的使用,采用属于NVIDIA AI Enterprise一部分的企业级软件,具有专用功能分支、严格的验证流程以及企业级安全性的支持。开放模型许可证也允许企业将Mistral NeMo无缝集成到商业应用程序中。

Mistral NeMo NIM专为安装在单个NVIDIA L40S、NVIDIA GeForce RTX 4090或NVIDIA RTX 4500 GPU的内存上而设计,高效率低成本,并且保障安全性和隐私性。也就是说,单个英伟达L40S,一块GPU就可跑了。

Mistral AI和英伟达各自擅长的领域结合,优化了Mistral NeMo的训练和推理。模型利用Mistral AI的专业知识进行训练,尤其是在多语言、代码和多轮内容方面,受益于英伟达全堆栈的加速训练。它专为实现最佳性能而设计,利用高效的模型并行技术、可扩展性以及与Megatron-LM的混合精度。该模型使用NVIDIA NeMo的一部分Megatron-LM进行训练,在DGX Cloud上配备3,072个H100 80GB Tensor Core GPU,由NVIDIA AI架构组成,包括加速计算、网络结构和软件,以提高训练效率。

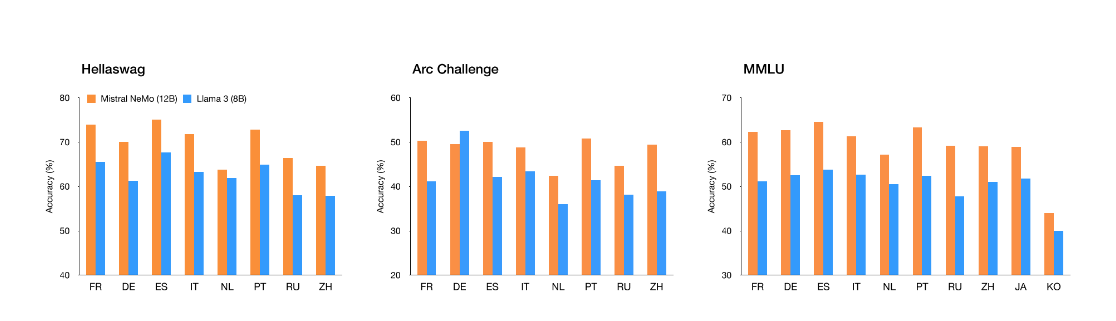

Mistral NeMo模型专为全球多语言应用程序而设计。它受过函数调用训练,拥有一个大型上下文窗口,在英语、法语、德语、西班牙语、意大利语、葡萄牙语、中文、日语、韩语、阿拉伯语和印地语方面表现尤为突出。可以说,这是将前沿人工智能模型带到全世界不同语言使用者手中的重要一步。下图是Mistral NeMo 在多语言基准测试中的表现:

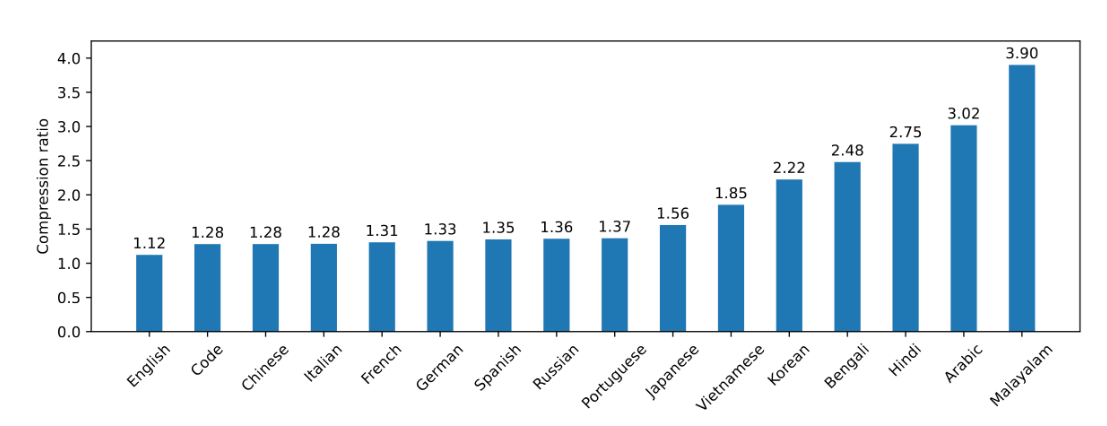

Mistral NeMo使用基于Tiktoken的全新分词器——Tekken,该分词器已针对100多种语言进行训练,并且比以前的Mistral模型中使用的SentencePiece分词器更有效地压缩自然语言文本和源代码。具体而言,在压缩源代码、中文、意大利语、法语、德语、西班牙语和俄语方面的效率提高了约30%;在压缩韩语和阿拉伯语方面的效率也分别提高了2倍和3倍。与Llama 3分词器相比,Tekken在压缩大约85%的所有语言的文本方面表现更为出色。

Mistral NeMO 经历了高级微调和调整阶段。与 Mistral 7B 相比,它在遵循精确指令、推理、处理多轮对话和生成代码方面表现得更好。

随着 AI 领域的不断发展,Mistral-NeMo 的发布标志着为企业提供更可访问、高效和强大的 AI 工具方面的重要里程碑。这将如何影响更广泛的 AI 生态系统还有待观察,但可以肯定的是:将 AI 能力更接近最终用户的竞赛正在升温,Nvidia 和 Mistral AI 已经在这一方向上迈出了大胆的一步。用户可以立即通过ai.nvidia.com作为NVIDIA NIM体验Mistral NeMo,可下载的NIM版本即将推出。

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/131139.html

随着大型模型技术的持续发展,视频生成技术正逐步走向成熟。以Sora、Gen-3等闭源视频生成模型为代表的技术,正在重新定义行业的未来格局。而近几个月,国产的AI视频生成模型也是层出不穷,像是快手可灵、字节即梦、智谱清影、Vidu、PixVerse V2 等。就在近日,智谱AI秉承以先进技术,服务全球开发者的理念,宣布将与清影同源的视频生成模型——CogVideoX开源,以期让每一位开发者、每一家企...

Llama3 中文聊天项目综合资源库,该文档集合了与Lama3 模型相关的各种中文资料,包括微调版本、有趣的权重、训练、推理、评测和部署的教程视频与文档。1. 多版本支持与创新:该仓库提供了多个版本的Lama3 模型,包括基于不同技术和偏好的微调版本,如直接中文SFT版、Instruct偏好强化学习版、趣味版等。此外,还有Phi3模型中文资料仓库的链接,和性能超越了8b版本的Llama3。2. 部...

DeepSeek-R1-671b动态量化版,由unsloth.ai发布,推荐使用多卡进行部署,具体操作如下。本镜像还附带32b的无限制版蒸馏模型,使用open-webui和ollama以及llama.cpp进行部署,内置所有环境,即拉即用。第一步:登录「优云智算」算力共享平台并进入「镜像社区」,新用户免费体验10小时4090地址:https://www.compshare.cn/?ytag=seo...

NVIDIA和MIT的研究人员推出了一种新的视觉语言模型(VLM)预训练框架,名为VILA。这个框架旨在通过有效的嵌入对齐和动态神经网络架构,改进语言模型的视觉和文本的学习能力。VILA通过在大规模数据集如Coy0-700m上进行预训练,采用基于LLaVA模型的不同预训练策略进行测试。研究人员还引入了视觉指令调整方法,利用视觉语言数据集进行基于提示的指令调整来细化模型。VILA在视觉问答基准测试中...

NVIDIA和MIT的研究人员推出了一种新的视觉语言模型(VLM)预训练框架,名为VILA。这个框架旨在通过有效的嵌入对齐和动态神经网络架构,改进语言模型的视觉和文本的学习能力。VILA通过在大规模数据集如Coy0-700m上进行预训练,采用基于LLaVA模型的不同预训练策略进行测试。研究人员还引入了视觉指令调整方法,利用视觉语言数据集进行基于提示的指令调整来细化模型。VILA在视觉问答基准测试中...

阅读 12750·2025-03-21 11:44

阅读 613·2025-02-19 18:27

阅读 722·2025-02-19 18:21

阅读 684·2025-02-19 13:50

阅读 1816·2025-02-13 22:35

阅读 1364·2025-02-08 10:20

阅读 5982·2025-01-02 11:25

阅读 1337·2024-12-10 11:51