资讯专栏INFORMATION COLUMN

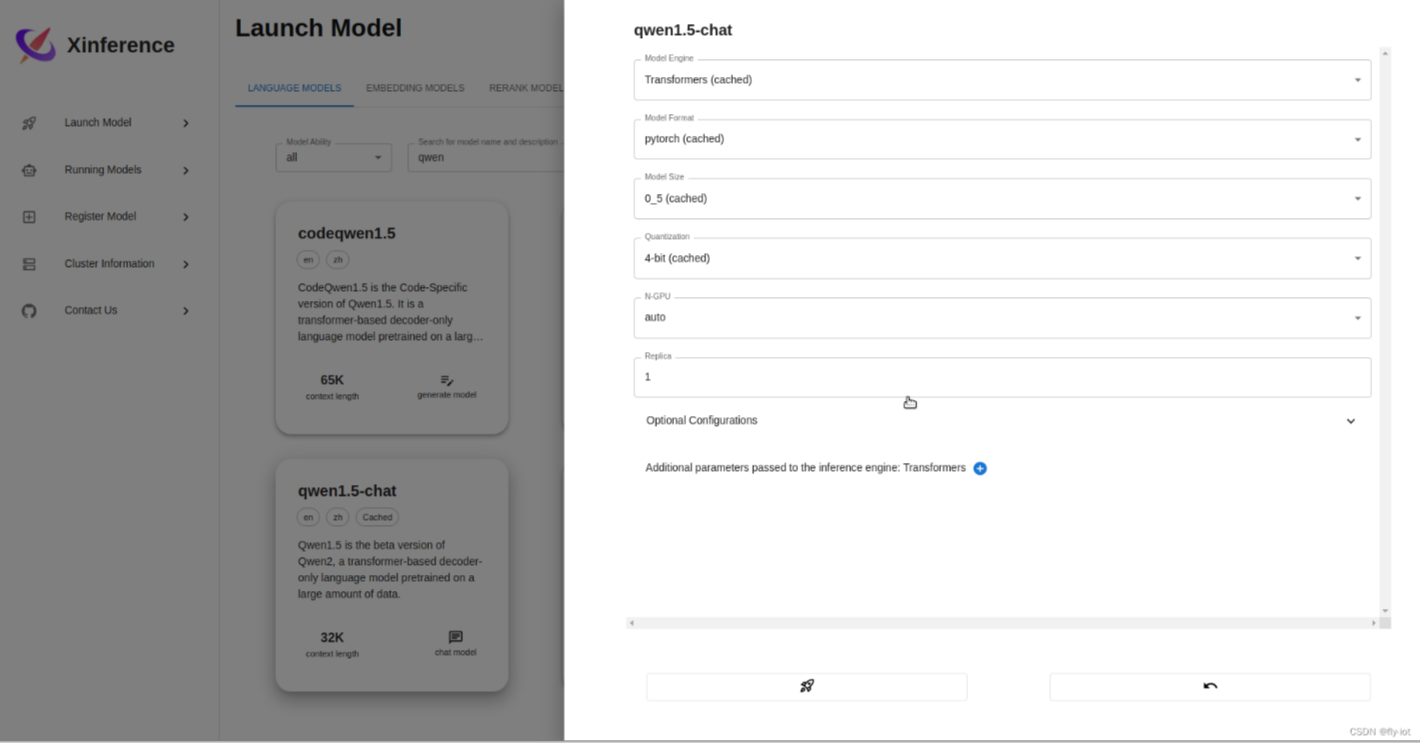

【compshare】推荐一个GPU按小时租的平台,使用实体机部署,可以方便快速的部署xinf推理框架并提供web展示,部署qwen大模型,特别方便

UCloud(优刻得)是中国知名的中立云计算服务商,科创板上市(股票代码:688158),中国云计算第一股,专注于提供可靠的企业级云服务,包括云服务器、云主机、云数据库、混合云、CDN、人工智能等服务。

compshare算力共享平台:

专注于提供高性价比算力资源,海量GPU,一键部署,即算即用,让AI训练、深度学习、科研计算效率翻倍。

————————————————

原文链接:https://blog.csdn.net/freewebsys/article/details/139188230

2、直接使用帐号远程登陆

端口使用8888

ssh root@117.50.xxx.xxx

输入密码就可以操作了

因为没有设置环境变量所以需要执行:

export PATH=${PATH}:/home/ubuntu/.local/bin

export HF_ENDPOINT=https://hf-mirror.com

export XINFERENCE_MODEL_SRC=modelscope

export XINFERENCE_HOME=/home/ubuntu/xinf-data

xinference-local --host 0.0.0.0 --port 8888

curl -X 'POST' 'http://0.0.0.0:8888/v1/chat/completions' -H 'Content-Type: application/json' -d '{

"model": "qwen1.5-chat","stream": true,

"messages": [

{

"role": "user",

"content": "北京景点?"

}

],

"max_tokens": 512,

"temperature": 0.7

}'推荐使用NVIDIA RTX 40 显卡做模型推理,购买地址如下:

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/131108.html

Compshare是一个专注于提供高性价比算力资源的平台,它为AI训练、深度学习、科研计算等场景提供强大的支持。平台的核心优势在于其高效的GPU算力资源,用户可以根据自己的需求,灵活选择不同的GPU配置,实现一键部署和即算即用,从而显著提升工作效率。100% GPU性能Compshare平台通过GPU显卡直通技术,确保用户能够充分利用GPU的性能,相比传统的容器形式,性能损耗降低了30%。这意味着...

摘要:新加坡云服务器多少钱新加坡云服务器多少钱新加坡云服务器新加坡云服务器怎么样新加坡云服务器机房都位于亚洲的金融中心之一的新加坡。下面,云服务器网小编详细介绍一下新加坡云服务器租用优势及价格。新加坡云服务器多少钱?新加坡云服务器怎么样?新加坡云服务器机房都位于亚洲的金融中心之一的新加坡。新加坡云服务器国际带宽充足,机房管理十分规范。完善的法律与机房充分保证了新加坡云服务器的高速稳定。ucloud...

摘要:签约方式金翼物理机支持按月付款标准机型协议期限支持个月个月个月个月个月个月定制型协议期限仅支持个月个月个月租用个月后,服务器产权归用户所有。UCloud金翼物理机汇集UCloud多年硬件选型和运维经验,以独享物理机包年包月的形式租用给用户,满足用户多层次的计算资源需求。金翼物理机作为UCloud公有云计算资源的有效补充,结合UCloud数据中心产品和网络产品,为用户提供完整的混合云解决方案。...

2024年4月18日,Meta AI正式宣布推出开源大模型Llama3,这标志着开源大型语言模型(LLM)领域的又一重大突破。Llama3以其卓越的性能和广泛的应用前景,或将推动人工智能技术快速迈进新纪元。为方便AI应用企业及个人AI开发者快速体验Llama3的超高性能,近期优刻得GPU云主机上线Llama3-8B-Instruct-Chinese镜像,一键配置,快速部署模型开发环境。为客户提供开...

阅读 4469·2025-03-21 11:44

阅读 370·2025-02-19 18:27

阅读 418·2025-02-19 18:21

阅读 364·2025-02-19 13:50

阅读 1527·2025-02-13 22:35

阅读 1023·2025-02-08 10:20

阅读 5887·2025-01-02 11:25

阅读 1043·2024-12-10 11:51