资讯专栏INFORMATION COLUMN

项目简介

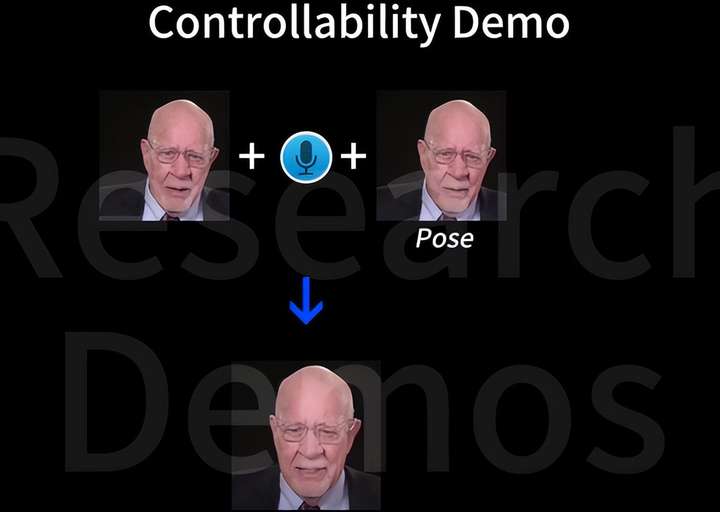

AniTalker是一个开源项目,它利用静态照片和音频文件来创造动态的面部说话视频。

AniTalker采用了一种通用的运动表示方法。这种创新的表示方法有效地捕捉了广泛的面部动态,包括微妙的表情和头部动作。

AniTalker通过两种自监督学习策略增强了运动描述:第一种策略是通过同一身份内的源帧重建目标视频帧来学习微妙的运动表示;第二种策略是使用度量学习开发身份编码器,同时积极减少身份和运动编码器之间的互信息。

这种方法确保了运动表示是动态的,并且不包含特定身份的细节,显著减少了对标记数据的需求。

功能特点

动态视频创作

AniTalker能够将静态图像转化为动态视频,其中不仅包括口型与音频的精准匹配,还涵盖了丰富的面部表情和头部动作。

个性化动画

用户可以根据个人喜好和需求,调整参数,定制出具有个性化表情和动作的面部动画。

高度仿真

这项技术能够捕捉到面部的微小动作,如眨眼和微笑,从而制作出具有高度仿真感的动态视频。

支持长视频

AniTalker支持制作超过3分钟的长视频,这使得它非常适合用于创建虚拟助手、数字角色表演等应用场景。

项目实操

预装环境

conda create -n anitalker python==3.9.0 conda activate anitalker conda install pytorch==1.8.0 torchvision==0.9.0 torchaudio==0.8.0 cudatoolkit=11.1 -c pytorch -c conda-forge pip install -r requirements.txt

演示脚本

python ./code/demo_audio_generation.py \ --infer_type 'mfcc_pose_only' \ --stage1_checkpoint_path 'ckpts/stage1.ckpt' \ --stage2_checkpoint_path 'ckpts/stage2_pose_only.ckpt' \ --test_image_path 'test_demos/portraits/monalisa.jpg' \ --test_audio_path 'test_demos/audios/english_female.wav' \ --result_path 'results/monalisa_case1/' \ --control_flag True \ --seed 0 \ --pose_yaw 0 \ --pose_pitch 0 \ --pose_roll 0

项目地址:

https://github.com/X-LANCE/AniTalker

推荐使用NVIDIA RTX 40 显卡做模型推理,购买地址如下:

https://www.ucloud.cn/site/active/gpu.html?ytag=seo

https://www.compshare.cn/?ytag=seo

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/131099.html

Llama3 中文聊天项目综合资源库,该文档集合了与Lama3 模型相关的各种中文资料,包括微调版本、有趣的权重、训练、推理、评测和部署的教程视频与文档。1. 多版本支持与创新:该仓库提供了多个版本的Lama3 模型,包括基于不同技术和偏好的微调版本,如直接中文SFT版、Instruct偏好强化学习版、趣味版等。此外,还有Phi3模型中文资料仓库的链接,和性能超越了8b版本的Llama3。2. 部...

DeepSeek-R1-671b动态量化版,由unsloth.ai发布,推荐使用多卡进行部署,具体操作如下。本镜像还附带32b的无限制版蒸馏模型,使用open-webui和ollama以及llama.cpp进行部署,内置所有环境,即拉即用。第一步:登录「优云智算」算力共享平台并进入「镜像社区」,新用户免费体验10小时4090地址:https://www.compshare.cn/?ytag=seo...

摘要:阿里云服务器平台在云端提供统一硬件平台与中间件,可大大降低加速器的开发与部署成本。我们相信,通过即开即用的硬件资源统一的软硬件逻辑开发接口和市场,阿里云能够真正兑现计算资源平民化的承诺。 阿里云ECS的异构计算团队和高性能计算团队一直致力于将计算资源平民化;高性能计算团队在做的E-HPC就是要让所有云上用户都能够瞬间拥有一个小型的超算集群,使得超算不再仅仅是一些超算中心和高校的特权;而...

阅读 12255·2025-03-21 11:44

阅读 596·2025-02-19 18:27

阅读 693·2025-02-19 18:21

阅读 654·2025-02-19 13:50

阅读 1793·2025-02-13 22:35

阅读 1328·2025-02-08 10:20

阅读 5977·2025-01-02 11:25

阅读 1319·2024-12-10 11:51