TiDB运维文档(上)

点击上方“IT那活儿”公众号,关注后了解更多内容,不管IT什么活儿,干就完了!!!

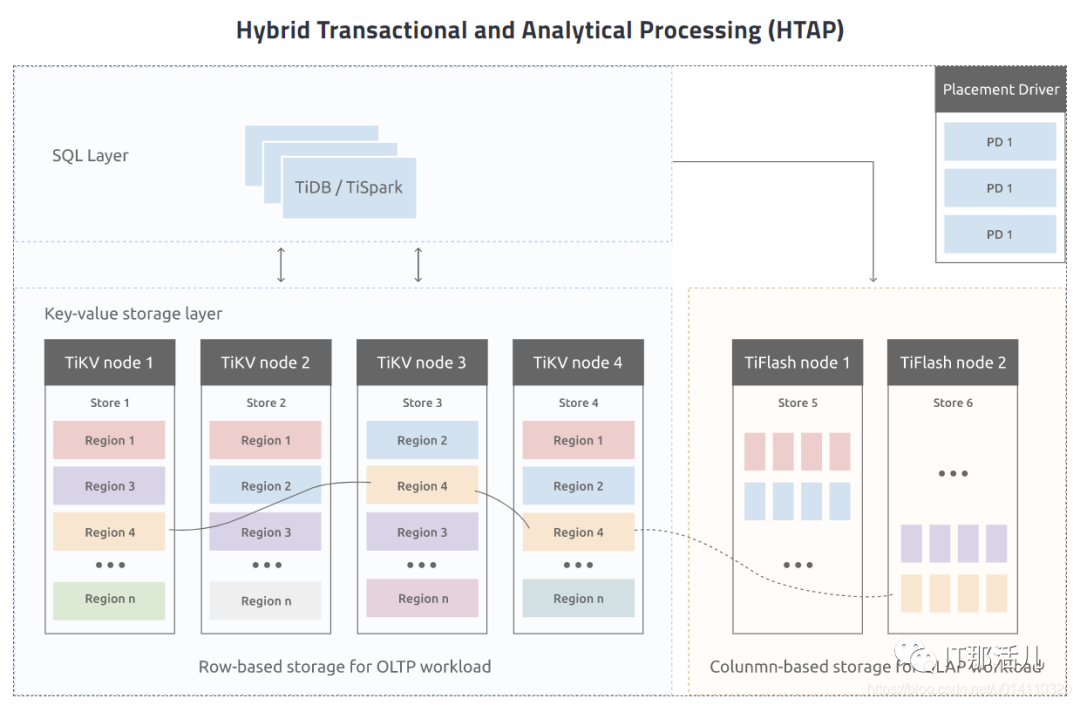

TiDB 是 PingCAP 公司自主设计、研发的开源分布式关系型数据库,是一款同时支持在线事务处理与在线分析处理 (Hybrid Transactional and Analytical Processing, HTAP) 的融合型分布式数据库产品,具备水平扩容或者缩容、金融级高可用、实时 HTAP、云原生的分布式数据库、兼容 MySQL 5.7 协议和 MySQL 生态等重要特性。目标是为用户提供一站式 OLTP (Online Transactional Processing)、OLAP (Online Analytical Processing)、HTAP 解决方案。TiDB 适合高可用、强一致要求较高、数据规模较大等各种应用场景。1.1 架构简介

1.1.1 TiDB Server

SQL 层,对外暴露 MySQL 协议的连接 endpoint,负责接受客户端的连接,执行 SQL 解析和优化,最终生成分布式执行计划。TiDB 层本身是无状态的,实践中可以启动多个 TiDB 实例,通过负载均衡组件(如 LVS、HAProxy 或 F5)对外提供统一的接入地址,客户端的连接可以均匀地分摊在多个 TiDB 实例上以达到负载均衡的效果。TiDB Server 本身并不存储数据,只是解析 SQL,将实际的数据读取请求转发给底层的存储节点 TiKV(或 TiFlash)。1.1.2 PD (Placement Driver) Server

整个 TiDB 集群的元信息管理模块,负责存储每个 TiKV 节点实时的数据分布情况和集群的整体拓扑结构,提供 TiDB Dashboard 管控界面,并为分布式事务分配事务 ID。PD 不仅存储元信息,同时还会根据 TiKV 节点实时上报的数据分布状态,下发数据调度命令给具体的 TiKV 节点,可以说是整个集群的“大脑”。此外,PD 本身也是由至少 3 个节点构成,拥有高可用的能力。建议部署奇数个 PD 节点。1.1.3 存储节点

1.2 五大核心特性

1.2.1 一键水平扩容或者缩容

得益于 TiDB 存储计算分离的架构的设计,可按需对计算、存储分别进行在线扩容或者缩容,扩容或者缩容过程中对应用运维人员透明。1.2.2 金融级高可用

数据采用多副本存储,数据副本通过 Multi-Raft 协议同步事务日志,多数派写入成功事务才能提交,确保数据强一致性且少数副本发生故障时不影响数据的可用性。可按需配置副本地理位置、副本数量等策略满足不同容灾级别的要求。1.2.3 实时 HTAP

提供行存储引擎 TiKV、列存储引擎 TiFlash 两款存储引擎,TiFlash 通过 Multi-Raft Learner 协议实时从 TiKV 复制数据,确保行存储引擎 TiKV 和列存储引擎 TiFlash 之间的数据强一致。TiKV、TiFlash 可按需部署在不同的机器,解决 HTAP 资源隔离的问题。1.2.4 云原生的分布式数据库

专为云而设计的分布式数据库,通过 TiDB Operator 可在公有云、私有云、混合云中实现部署工具化、自动化。1.2.5 兼容 MySQL 5.7 协议和 MySQL 生态

兼容 MySQL 5.7 协议、MySQL 常用的功能、MySQL 生态,应用无需或者修改少量代码即可从 MySQL 迁移到 TiDB。提供丰富的数据迁移工具帮助应用便捷完成数据迁移。

2.1 环境准备

2.1.1 Linux 操作系统版本要求

- a) 目前尚不支持 Red Hat Enterprise Linux 8.0、CentOS 8 Stream 和 Oracle Enterprise Linux 8.0,因为目前对这些平台的测试还在进行中。

- b) 不计划支持 CentOS 8 Linux,因为 CentOS 的上游支持将于 2021 年 12 月 31 日终止。

- c) TiDB 将不再支持 Ubuntu 16.04。强烈建议升级到 Ubuntu 18.04 或更高版本。

2.1.2 软件配置

2.1.3 硬件配置

- a) 单Tikv节点建议存储2T内数据,可视服务器cpu、内存情况增加。

- b) Tiflash节点磁盘性能同于或高于tikv节点磁盘性能。

2.1.4 系统环境准备

1)在 TiKV 部署目标机器上添加数据盘EXT4文件系统挂载参数

生产环境部署,建议使用 EXT4 类型文件系统的 NVME 类型的 SSD 磁盘存储 TiKV 数据文件。这个配置方案为最佳实施方案,其可靠性、安全性、稳定性已经在大量线上场景中得到证实。使用 root 用户登录目标机器,将部署目标机器数据盘格式化成 ext4 文件系统,挂载时添加 nodelalloc 和 noatime 挂载参数。nodelalloc 是必选参数,否则 TiUP 安装时检测无法通过;noatime 是可选建议参数。以 /dev/nvme0n1 数据盘为例,具体操作步骤如下:--查看数据盘。

fdisk -l

Disk /dev/nvme0n1: 1000 GB

--创建分区。

parted -s -a optimal /dev/nvme0n1 mklabel gpt -- mkpart primary ext4 1 -1

--格式化文件系统。

--查看数据盘分区 UUID。

本例中 nvme0n1p1 的 UUID 为 c51eb23b-195c-4061-92a9-3fad812cc12f。lsblk -f

NAME FSTYPE LABEL UUID MOUNTPOINT

sda

├─sda1 ext4 237b634b-a565-477b-8371-6dff0c41f5ab /boot

├─sda2 swap f414c5c0-f823-4bb1-8fdf-e531173a72ed

└─sda3 ext4 547909c1-398d-4696-94c6-03e43e317b60 /

sr0

nvme0n1

└─nvme0n1p1 ext4 c51eb23b-195c-4061-92a9-3fad812cc12f

--编辑 /etc/fstab 文件,添加 nodelalloc 挂载参数。

vi /etc/fstab

UUID=c51eb23b-195c-4061-92a9-3fad812cc12f /data1 ext4 defaults,nodelalloc,noatime 0 2

--挂载数据盘。

--执行以下命令,如果文件系统为 ext4,并且挂载参数中包含 nodelalloc,则表示已生效。mount -t ext4

/dev/nvme0n1p1 on /data1 type ext4 (rw,noatime,nodelalloc,data=ordered)

2)检测及关闭系统swap

TiDB 运行需要有足够的内存,并且不建议使用 swap 作为内存不足的缓冲,这会降低性能。因此建议永久关闭系统 swap,并且不要使用 swapoff -a 方式关闭,否则重启机器后该操作会失效。echo "vm.swappiness = 0">> /etc/sysctl.conf

swapoff -a && swapon -a

sysctl -p

3)检测及关闭目标部署机器的防火墙

因为在 TiDB 集群中,需要将节点间的访问端口打通才可以保证读写请求、数据心跳等信息的正常的传输。在普遍线上场景中,数据库到业务服务和数据库节点的网络联通都是在安全域内完成数据交互。如果没有特殊安全的要求,建议将目标节点的防火墙进行关闭。否则建议按照端口使用规则,将端口信息配置到防火墙服务的白名单中。检查防火墙状态(以 CentOS Linux release 7.7.1908 (Core) 为例)sudo firewall-cmd --state

sudo systemctl status firewalld.service

--关闭防火墙服务。

sudo systemctl stop firewalld.service

--关闭防火墙自动启动服务。

sudo systemctl disable firewalld.service

sudo systemctl status firewalld.service

4)检测及安装NTP服务

TiDB 是一套分布式数据库系统,需要节点间保证时间的同步,从而确保 ACID 模型的事务线性一致性。目前解决授时的普遍方案是采用 NTP 服务,可以通过互联网中的 pool.ntp.org 授时服务来保证节点的时间同步,也可以使用离线环境自己搭建的 NTP 服务来解决授时。采用如下步骤检查是否安装 NTP 服务以及与 NTP 服务器正常同步:步骤一:执行以下命令,如果输出 running 表示 NTP 服务正在运行:

sudo systemctl status ntpd.service

ntpd.service - Network Time Service

Loaded: loaded (/usr/lib/systemd/system/ntpd.service; disabled; vendor preset: disabled)

Active: active (running) since 一 2017-12-18 13:13:19 CST; 3s ago

若返回报错信息 Unit ntpd.service could not be found.,请尝试执行以下命令,以查看与 NTP 进行时钟同步所使用的系统配置是 chronyd 还是 ntpd:sudo systemctl status cronyd.service

chronyd.service - NTP client/server

Loaded: loaded (/usr/lib/systemd/system/chronyd.service; enabled; vendor preset: enabled)

Active: active (running) since Mon 2021-04-05 09:55:29 EDT; 3 days ago

如果你使用的系统配置是 chronyd,请直接执行以下的步骤 3。步骤二:执行 ntpstat 命令检测是否与 NTP 服务器同步:

如果输出 synchronised to NTP server,表示正在与 NTP 服务器正常同步:synchronised to NTP server (85.199.214.101) at stratum 2

time correct to within 91 ms

polling server every 1024 s

Unable to talk to NTP daemon. Is it running?

步骤三:如果要使 NTP 服务尽快开始同步,执行以下命令。可以将 pool.ntp.org 替换为你的 NTP 服务器:

sudo systemctl stop ntpd.service &&

sudo ntpdate pool.ntp.org &&

sudo systemctl start ntpd.service

步骤四:如果要在 CentOS 7 系统上手动安装 NTP 服务,可执行以下命令:sudo yum install ntp ntpdate &&

sudo systemctl start ntpd.service &&

sudo systemctl enable ntpd.service

5)配置SSH互信及sudo免密码

对于有需求,通过手动配置中控机至目标节点互信的场景,可参考本段。通常推荐使用 TiUP 部署工具会自动配置 SSH 互信及免密登录,可忽略本段内容。以 root 用户依次登录到部署目标机器创建 tidb 用户并设置登录密码。

useradd tidb &&

passwd tidb

执行以下命令,将 tidb ALL=(ALL) NOPASSWD: ALL 添加到文件末尾,即配置好 sudo 免密码。

visudo

tidb ALL=(ALL) NOPASSWD: ALL

以 tidb 用户登录到中控机,执行以下命令。将 10.0.1.1 替换成你的部署目标机器 IP,按提示输入部署目标机器 tidb 用户密码,执行成功后即创建好 SSH 互信,其他机器同理。

新建的 tidb 用户下没有 .ssh 目录,需要执行生成 rsa 密钥的命令来生成 .ssh 目录。如果要在中控机上部署 TiDB 组件,需要为中控机和中控机自身配置互信。ssh-keygen -t rsa

ssh-copy-id -i ~/.ssh/id_rsa.pub 10.0.1.1

以 tidb 用户登录中控机,通过 ssh 的方式登录目标机器 IP。如果不需要输入密码并登录成功,即表示 SSH 互信配置成功。

ssh 10.0.1.1

[tidb@10.0.1.1 ~]$

以 tidb 用户登录到部署目标机器后,执行以下命令,不需要输入密码并切换到 root 用户,表示 tidb 用户 sudo 免密码配置成功。

sudo -su root

[root@10.0.1.1 tidb]#

6)安装numactl工具

在生产环境中,因为硬件机器配置往往高于需求,为了更合理规划资源,会考虑单机多实例部署 TiDB 或者 TiKV。NUMA 绑核工具的使用,主要为了防止 CPU 资源的争抢,引发性能衰退。NUMA 绑核是用来隔离 CPU 资源的一种方法,适合高配置物理机环境部署多实例使用。通过 tiup cluster deploy 完成部署操作,就可以通过 exec 命令来进行集群级别管理工作。登录到目标节点进行安装(以 CentOS Linux release 7.7.1908 (Core) 为例)

sudo yum -y install numactl

通过 TiUP 的 cluster 执行完 exec 命令来完成批量安装。

tiup cluster exec tidb-test --sudo --command "yum -y install numactl"

由nginx或haproxy负载tidb接口,提供对外服务。建议方案有两种:

- 方案一:代理机负载全部tidb-server节点,代理机利用keepalive工具,部署主备式架构,采用VIP对外提供统一服务接口。

- 方案二:代理机负载全部或分配部分tidb-server节点,根据业务情况,划分使用哪个代理机入口。

方案一:对外统一接口

方案二:对外规划接口

2.3 集群部署

2.3.1 准备 TiUP 离线组件包

使用tiupmirrorclone命令手动打包离线组件包。1)在线环境中安装 TiUP 包管理器工具

curl --proto =https --tlsv1.2 -sSf https://tiup-mirrors.pingcap.com/install.sh | sh

2)使用 TiUP 制作离线镜像

tiup mirror clone tidb-community-server-${version}-linux-amd64 ${version} --os=linux --arch=amd64

该命令会在当前目录下创建一个名叫 tidb-community-server-${version}-linux-amd64 的目录,里面包含 TiUP 管理的组件包。通过 tar 命令将该组件包打包然后发送到隔离环境的中控机:

tar czvf tidb-community-server-${version}-linux-amd64.tar.gz tidb-community-server-${version}-linux-amd64

此时,tidb-community-server-${version}-linux-amd64.tar.gz 就是一个独立的离线环境包。2.3.2 部署离线环境 TiUP 组件

将离线包发送到目标集群的中控机后,执行以下命令安装 TiUP 组件:tar xzvf tidb-community-server-${version}-linux-amd64.tar.gz

sh tidb-community-server-${version}-linux-amd64/local_install.sh

source /home/tidb/.bash_profile

local_install.sh 脚本会自动执行 tiup mirror set tidb-community-server-${version}-linux-amd64 命令将当前镜像地址设置为 tidb-community-server-${version}-linux-amd64。若需将镜像切换到其他目录,可以通过手动执行 tiup mirror set 进行切换。如果需要切换到在线环境,可执行 tiup mirror set https://tiup-mirrors.pingcap.com。2.3.3 配置初始化参数文件 topology.yaml

集群初始化配置文件需要手动编写,完整的全配置参数模版可以参考 Github TiUP 项目配置参数模版。需要在中控机上面创建 YAML 格式配置文件,例如 topology.yaml:cat topology.yaml

# # Global variables are applied to all deployments and used as the default value of

# # the deployments if a specific deployment value is missing.

global:

user: "tidb"

ssh_port: 22

deploy_dir: "/tidb-deploy"

data_dir: "/tidb-data"

server_configs:

pd:

replication.enable-placement-rules: true

pd_servers:

- host: 10.0.1.4

- host: 10.0.1.5

- host: 10.0.1.6

tidb_servers:

- host: 10.0.1.7

- host: 10.0.1.8

- host: 10.0.1.9

tikv_servers:

- host: 10.0.1.1

- host: 10.0.1.2

- host: 10.0.1.3

tiflash_servers:

- host: 10.0.1.10

data_dir: /data1/tiflash/data,/data2/tiflash/data

cdc_servers:

- host: 10.0.1.6

- host: 10.0.1.7

- host: 10.0.1.8

monitoring_servers:

- host: 10.0.1.4

grafana_servers:

- host: 10.0.1.4

alertmanager_servers:

- host: 10.0.1.4

2.3.4 部署 TiDB 集群

1)执行以下命令来部署TiDB集群

tiup cluster deploy tidb-test v4.0.0 topology.yaml --user tidb [-p] [-i /home/root/.ssh/gcp_rsa]

tiup cluster start tidb-test

2)参数说明

- 通过 TiUP cluster 部署的集群名称为 tidb-test;

- 部署版本为 v4.0.0,其他版本可以执行 tiup list tidb 获取;

- --user tidb:通过 tidb 用户登录到目标主机完成集群部署,该用户需要有 ssh 到目标机器的权限,并且在目标机器有 sudo 权限。也可以用其他有 ssh 和 sudo 权限的用户完成部署;

- [-i] 及 [-p]:非必选项,如果已经配置免密登陆目标机,则不需填写。否则选择其一即可,[-i] 为可登录到部署机 root 用户(或 --user 指定的其他用户)的私钥,也可使用 [-p] 交互式输入该用户的密码;

- 预期日志结尾输出会有 Deployed cluster `tidb-test` successfully 关键词,表示部署成功;

- 部署完成后,集群相关操作可参考 cluster 命令。

2.4 集群状态验证

2.4.1 中控机

检查集群状态的命令是 tiup cluster display ,例如:tiup cluster display tidb-test预期结果输出:各节点 Status 状态信息为 Up 说明集群状态正常。2.4.2 监控页面

1)通过 {pd-ip}:{pd-port}/dashboard 登录 TiDB Dashboard,登录用户和口令为 TiDB 数据库 root 用户和口令。如果你修改过数据库的 root 密码,则以修改后的密码为准,默认密码为空。2)通过 {Grafana-ip}:3000 登录 Grafana 监控,默认用户名及密码为 admin/admin。点击 Overview 监控页面检查 TiDB 端口和负载监控信息。下篇文章我们讲一下TIDB的日常运维,本文到此结束,谢谢!

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/129140.html