资讯专栏INFORMATION COLUMN

Python在工作中的应用还是比较的广泛的,市场上面对于这类人才开出的薪资还是比较的高的。那么,如何使用第三方库jieba库与中文分词进行一个分解呢?下面小编就给大家详细的做出一个解答。

一、什么是jieba库

jieba是优秀的中文分词第三方库,由于中文文本之间每个汉字都是连续书写的,我们需要通过特定的手段来获得其中的每个词组,这种手段叫做分词,我们可以通过jieba库来完成这个过程。

二、jieba分词原理

jieba库的分词原理是利用了一个中文词库,将待分词的内容与分词词库对比,通过图结构和动态规则划分方法找到最大概率的词组。除了分词,jieba还提供增加自定义中文单词的功能。

三、jieba库支持的三种分词模式

1.精确模式

将句子最精确地分开,适合文本分析;

2.全模式

把句子中所有可以成词的词语都扫描出来,速度非常快,但是不能解决歧义;

3.搜索引擎模式

在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词

注:对中文分词来说,jieba库只需要一行代码即可。英文文本不存在分词问题

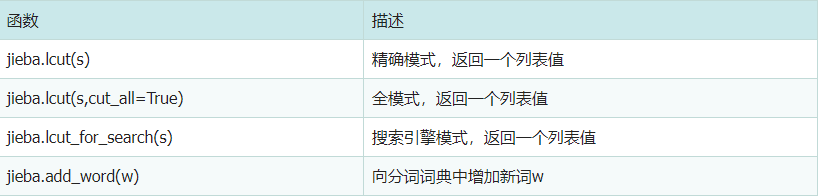

四、jieba库常用函数

五、jieba实操

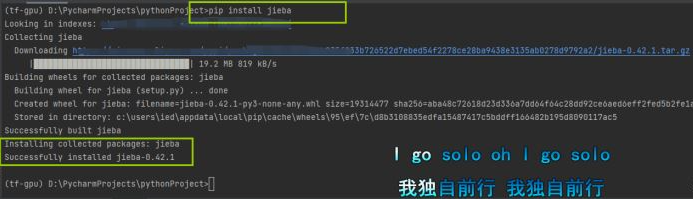

首先你需要安装jieba库

pip install jieba

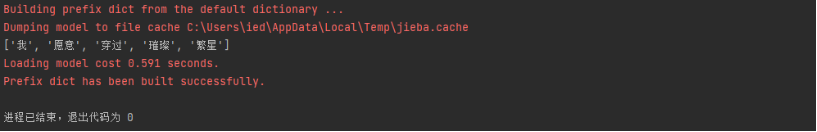

练习一(jieba.lcut)精确模式

jieba.lcut(s)是最常用的中文分词函数,用于精确模式,将字符串分割成等量的中文词组。

import jieba

ls=jieba.lcut("我愿意穿过璀璨繁星")

print(ls)

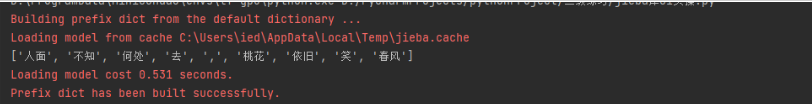

练习二(jieba.lcut(s,cut_all=True))全模式

jieba.lcut(s,cut_all=True)用于全模式,将字符串的所有分词可能列出来,冗余最大。

import jieba

ls=jieba.lcut("人面不知何处去,桃花依旧笑春风",cut_all=True)

print(ls)

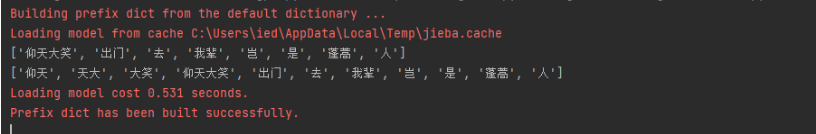

练习三(jieba.lcut_for_search)搜索引擎模式

jieba.lcut_for_search该模式首先执行精确模式,然后在对其中长词进一步分获得最终结果

import jieba

ls1=jieba.lcut("仰天大笑出门去我辈岂是蓬蒿人")

ls=jieba.lcut_for_search("仰天大笑出门去我辈岂是蓬蒿人")

print(ls1)

print(ls)

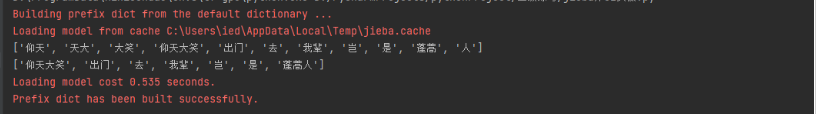

练习四(jieba.add_word(w))增加新词

import jieba

ls=jieba.lcut_for_search("仰天大笑出门去我辈岂是蓬蒿人")

print(ls)

jieba.add_word("蓬蒿人")

ls1=jieba.lcut("仰天大笑出门去我辈岂是蓬蒿人")

print(ls1)

小结:精确模式因为不产生冗余,最为常用。

到此为止,这篇文章就给大家介绍到这里了,希望可以给大家带来更多的帮助。

文章版权归作者所有,未经允许请勿转载,若此文章存在违规行为,您可以联系管理员删除。

转载请注明本文地址:https://www.ucloud.cn/yun/128245.html

摘要:据小编简单了解,已知对工作报告高频词汇进行梳理的媒体包括法制日报和新华网。高频词词频年以来政府工作报告中的提及总数发展经济改革建设社会推进创新政策企业加强下面是新华网数据新闻部统计的高频词汇。 本文首发于微信公众号号编程派。微信搜索编程派,获取更多Python编程一手教程及优质资源吧。 上周六,总理在大会堂作政府工作报告,全球媒体瞩目。每年都会有媒体对报告中的高频词汇进行梳理,我们也可...

摘要:先看效果环境位目标抓取一篇报纸,并提取出关键字,然后按照出现次数排序,用在页面上显示出来。首先要抓取网页,但是网页在控制台输出的时候,中文总是乱码。但是不得不承认,上有很多非常优秀的库。例如但是这些包我在上安装的时候总是报错。 先看效果: showImg(https://segmentfault.com/img/bVRLCc?w=612&h=668); 环境 win7 64位 pyt...

摘要:分词的算法中文分词有难度,不过也有成熟的解决方案。例如通过人民日报训练的分词系统,在网络玄幻小说上,分词的效果就不会好。三的优点是开源的,号称是中,最好的中文分词组件。 showImg(https://segmentfault.com/img/remote/1460000016359704?w=1350&h=900); 题图:by Lucas Davies 一、前言 分词,我想是大多数...

摘要:前言今天教大家用模块来生成词云,我读取了一篇小说并生成了词云,先看一下效果图效果图一效果图二根据效果图分析的还是比较准确的,小说中的主人公就是程理,所以出现次数最多。 前言 今天教大家用wrodcloud模块来生成词云,我读取了一篇小说并生成了词云,先看一下效果图: 效果图一: showImg(https://segmentfault.com/img/remote/1460000015...

阅读 1045·2023-01-14 11:38

阅读 1042·2023-01-14 11:04

阅读 874·2023-01-14 10:48

阅读 2330·2023-01-14 10:34

阅读 1117·2023-01-14 10:24

阅读 1008·2023-01-14 10:18

阅读 636·2023-01-14 10:09

阅读 711·2023-01-14 10:02